Administration Guide

Configuring and Managing Red Hat Gluster Storage

Configuring and Managing Red Hat Gluster Storage

Red Hat Gluster Storage Documentation Team

gluster-docs@redhat.com

Copyright © 2015-2019 Red Hat, Inc.

This document is licensed by Red Hat under the Creative Commons Attribution-ShareAlike 3.0

Unported License. If you distribute this document, or a modified version of it, you must provide

attribution to Red Hat, Inc. and provide a link to the original. If the document is modified, all Red Hat

trademarks must be removed.

Red Hat, as the licensor of this document, waives the right to enforce, and agrees not to assert,

Section 4d of CC-BY-SA to the fullest extent permitted by applicable law.

Red Hat, Red Hat Enterprise Linux, the Shadowman logo, the Red Hat logo, JBoss, OpenShift,

Fedora, the Infinity logo, and RHCE are trademarks of Red Hat, Inc., registered in the United States

and other countries.

Linux ® is the registered trademark of Linus Torvalds in the United States and other countries.

Java ® is a registered trademark of Oracle and/or its affiliates.

XFS ® is a trademark of Silicon Graphics International Corp. or its subsidiaries in the United States

and/or other countries.

MySQL ® is a registered trademark of MySQL AB in the United States, the European Union and

other countries.

Node.js ® is an official trademark of Joyent. Red Hat is not formally related to or endorsed by the

official Joyent Node.js open source or commercial project.

The OpenStack ® Word Mark and OpenStack logo are either registered trademarks/service marks

or trademarks/service marks of the OpenStack Foundation, in the United States and other

countries and are used with the OpenStack Foundation's permission. We are not affiliated with,

endorsed or sponsored by the OpenStack Foundation, or the OpenStack community.

All other trademarks are the property of their respective owners.

概要

概要

Red Hat Gluster Storage Administration Guide describes the configuration and management of Red

Hat Gluster Storage for On-Premise.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

目次

目次

パート パート I. プリフェイスプリフェイス 第 第1章章 プリフェイスプリフェイス1.1. RED HAT GLUSTER STORAGE の製品ページ 1.2. GLUSTERFS について 1.3. オンプレミスインストールについて パート パート II. 概要概要 第 第2章章 アーキテクチャーおよび概念アーキテクチャーおよび概念 2.1. アーキテクチャー 2.2. オンプレミス型アーキテクチャー 2.3. ストレージの概念 パート パート III. 設定および検証設定および検証 第

第3章章 RED HAT GLUSTER STORAGE における考慮事項における考慮事項 3.1. ファイアウォールおよびポートアクセス 3.2. 機能互換性サポート 第 第4章章 信頼済みストレージプールへのサーバーの追加信頼済みストレージプールへのサーバーの追加 4.1. 信頼済みストレージプールへのサーバーの追加 4.2. 信頼済みストレージプールからのサーバーの削除 第 第5章章 ストレージボリュームの設定ストレージボリュームの設定 5.1. GDEPLOY を使用した GLUSTER ストレージボリュームの設定 5.2. 暗号化したディスクについて 5.3. ブリックのフォーマットとマウント 5.4. 分散ボリュームの作成 5.5. REPLICATED ボリュームの作成 5.6. 分散複製ボリュームの作成 5.7. 任意の複製ボリュームの作成 5.8. 分散ボリュームの作成 5.9. 分散分散ボリュームの作成 5.10. ボリュームの起動 第 第6章章 ボリュームへのアクセスの作成ボリュームへのアクセスの作成 6.1. クライアントサポート情報 6.2. ネイティブクライアント 6.3. NFS 6.4. SMB 6.5. POSIX アクセス制御リスト

6.6. CLIENT OPERATING VERSIONS の確認 第

第7章章 RED HAT GLUSTER STORAGE とと WINDOWS ACTIVE DIRECTORY の統合の統合 7.1. 前提条件 7.2. 統合 パート パート IV. 管理管理 第 第8章章 スナップショットの管理スナップショットの管理 8.1. 前提条件 8.2. スナップショットの作成 8.3. スナップショットのクローン作成 6 7 7 7 7 8 9 9 9 10 15 16 16 18 22 22 24 26 27 69 69 73 75 79 81 92 94 96 97 97 99 110 155 173 177 179 180 181 189 190 191 192 194

. . . . . . . . . . . . . . . . 8.4. 利用可能なスナップショットの一覧表示 8.5. 利用可能なすべてのスナップショットの情報の取得 8.6. 利用可能なスナップショットの状態の取得 8.7. スナップショットの動作の設定 8.8. スナップショットのアクティブ化と非アクティブ化 8.9. スナップショットの削除 8.10. スナップショットの復元 8.11. スナップショットへのアクセス 8.12. スナップショットのスケジューリング 8.13. ユーザーサービス可能なスナップショット 8.14. トラブルシューティング 第 第9章章 ディレクトリークォータの管理ディレクトリークォータの管理 9.1. クォータの有効化および無効化 9.2. ディレクトリーでクォータを設定する前 9.3. ディスク使用量の制限 第 第10章章 GEO-REPLICATION の管理の管理 10.1. GEO-REPLICATION について 10.2. 複製ボリューム VS GEO-REPLICATION 10.3. GEO レプリケーションのデプロイの準備 10.4. GEO-REPLICATION の起動 10.5. GDEPLOY を使用した GEO-REPLICATION の設定 10.6. 新規に追加された BRICK、ノード、またはボリュームでの GEO レプリケーションの開始 10.7. CRON ジョブとしての GEO レプリケーションのスケジュール設定 10.8. 障害復旧 10.9. GEO レプリケーションボリュームのスナップショットの作成 10.10. 例 - CASCADING GEO-REPLICATION の設定 10.11. 推奨されるプラクティス 10.12. GEO-REPLICATION のトラブルシューティング 第

第11章章 RED HAT GLUSTER STORAGE ボリュームの管理ボリュームの管理 11.1. ボリュームオプションの設定 11.2. 複数のボリュームオプションの設定 11.3. サポート対象のボリュームオプション 11.4. ボリュームを読み取り専用にマウントするよう設定 11.5. ボリュームのトランスポート種別の設定 11.6. ボリュームでのストレージの確保 11.7. ボリュームの拡張 11.8. ボリュームの縮小 11.9. ボリュームの移行 11.10. ホストの置き換え 11.11. ボリュームのリバランス 11.12. 共有ストレージボリュームの設定 11.13. ボリュームの停止 11.14. ボリュームの削除 11.15. SPLIT-BRAIN の管理 11.16. 推奨される設定: 分散ボリューム 11.17. REPLICA および DISPERSE サブボリューム内の一貫した時間属性 第

第12章章 RED HAT GLUSTER STORAGE ログの管理ログの管理 12.1. ログローテーション

12.2. RED HAT GLUSTER STORAGE コンポーネントのログと場所 12.3. ログ形式の設定 195 196 196 197 199 200 200 202 203 207 209 214 214 214 215 219 219 219 219 228 237 242 244 245 248 249 250 253 256 256 256 257 284 285 285 286 292 297 305 314 317 318 319 319 345 352 354 354 354 356

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12.4. ログレベルの設定 12.5. 繰り返しログメッセージの非表示 12.6. GEO レプリケーションログ 第

第13章章 MANAGING RED HAT GLUSTER STORAGE VOLUME LIFE-CYCLE EXTENSIONS 13.1. スクリプトの場所 13.2. パッケージ済みスクリプト 第 第14章章 BITROT の検出の検出 14.1. BITROT デーモンの有効化および無効化 14.2. BITROT 検出動作の変更 14.3. 正しくないファイルの復元 第 第15章章 GLUSTERFIND を使用した増分バックアップ支援を使用した増分バックアップ支援 15.1. GLUSTERFIND 設定オプション 第 第16章章 階層の管理(非推奨)階層の管理(非推奨) 16.1. 階層アーキテクチャー(非推奨) 16.2. 階層の主な利点(非推奨) 16.3. 階層の制限(非推奨) 16.4. ボリュームへの階層の接続(非推奨) 16.5. 階層ボリュームの設定(非推奨) 16.6. 階層ステータス情報の表示(非推奨) 16.7. ボリュームからの階層の切断(非推奨) パート パート V. 監視およびチューニング監視およびチューニング 第

第17章章 RED HAT GLUSTER STORAGE GLUSTER ワークロードの監視ワークロードの監視 17.1. プロファイリングボリューム 17.2. ボリュームトップコマンドの実行 17.3. ボリュームの一覧表示 17.4. ボリューム情報の表示 17.5. ノード情報の取得 17.6. 現在のボリュームオプション設定の取得 17.7. STATEDUMP を使用した完全なボリューム状態の表示 17.8. ボリュームステータスの表示

17.9. RED HAT GLUSTER STORAGE で信頼されるストレージプールの問題のトラブルシューティング 第 第18章章 リソース使用状況の管理リソース使用状況の管理 第 第19章章 パフォーマンスチューニングパフォーマンスチューニング 19.1. ディスクの設定 19.2. ブリックの設定 19.3. NETWORK 19.4. メモリー 19.5. 小さいファイルのパフォーマンスの強化 19.6. レプリケーション 19.7. ディレクトリーの操作

19.8. RED HAT GLUSTER STORAGE の LVM キャッシュ パート

パート VI. SECURITY 第

第20章章 『『CONFIGURING NETWORK ENCRYPTION IN RED HAT GLUSTER STORAGE』』 20.1. 証明書の準備 20.2. 新しい信頼済みストレージプールのネットワーク設定 357 359 361 363 363 364 365 365 365 366 369 369 374 375 376 376 377 380 383 384 388 389 389 392 398 398 399 416 418 420 425 426 430 430 430 439 439 440 442 442 443 448 449 449 452

. . . . . . . . . . . . . . . . . . . . . . . . 20.4. 管理暗号化の有効化 20.5. ボリュームの拡張 20.6. 新しいクライアントの承認 20.7. クライアントの認証解除 20.8. ネットワーク暗号化の無効化 パート パート VII. トラブルシューティングトラブルシューティング 第 第21章章 一般的な問題の解決一般的な問題の解決 21.1. ロックされたファイルを特定し、ロックをクリアします。 21.2. GLUSTER ボリュームからのファイルパスの取得 21.3. GLUSTERD クラッシュの解決 21.4. デッド/失敗したブリックの再起動 21.5. グループ設定の非アクティブ化 パート パート VIII. 付録付録 第 第22章章 GLUSTERD サービスの起動と停止サービスの起動と停止 第 第23章章 ファイルの分割ブレインの手動リカバリーファイルの分割ブレインの手動リカバリー 付録 付録A 改訂履歴改訂履歴 455 457 460 464 465 468 469 469 472 475 476 476 477 478 479 484

第

1章 プリフェイス

1.1. RED HAT GLUSTER STORAGE の製品ページ

Red Hat Gluster Storage は、ソフトウェアのみのスケールアウト型のストレージソリューションで、 柔軟でアジャイルな非構造化データストレージを企業に提供します。

Red Hat Gluster Storage は、データストレージとインフラストラクチャーの統合、パフォーマンスの 向上、可用性および管理性の向上を実現する機会を新たに提供し、組織のストレージの課題とニーズの 広いセットに対応します。 この製品は、オンプレミスまたはパブリッククラウドにインストールされ、管理できます。

1.2. GLUSTERFS について

GlusterFSは、ネットワーク相互接続を介してさまざまなストレージサーバーを 1 つの大きな並列ネッ トワークファイルシステムに集約します。スタック可能なユーザー空間設計に基づいて、ワークロード に対して優れたパフォーマンスを実現し、Red Hat Gluster Storage の主要ビルディングブロックとな ります。POSIX と互換性のある glusterFS サーバーは、ディスクにデータを保存する XFS ファイルシステムを 使用し、Network File System(NFS)や Server Message Block(SMB)(CIFS としても知られています) などの業界標準のアクセスプロトコルを使用してアクセスできます。

1.3. オンプレミスインストールについて

Red Hat Gluster Storage for On-Premise を使用すると、物理ストレージを仮想化、スケーラブルで、 一元管理されたストレージプールとして使用できます。

Red Hat Gluster Storage はコモディティーサーバーにインストールできるため、強力な、非常にス ケーラブルで高可用性 NAS 環境が可能になります。

第

2章 アーキテクチャーおよび概念

本章では、Red Hat Gluster Storage のアーキテクチャーとストレージの概念の概要を説明します。

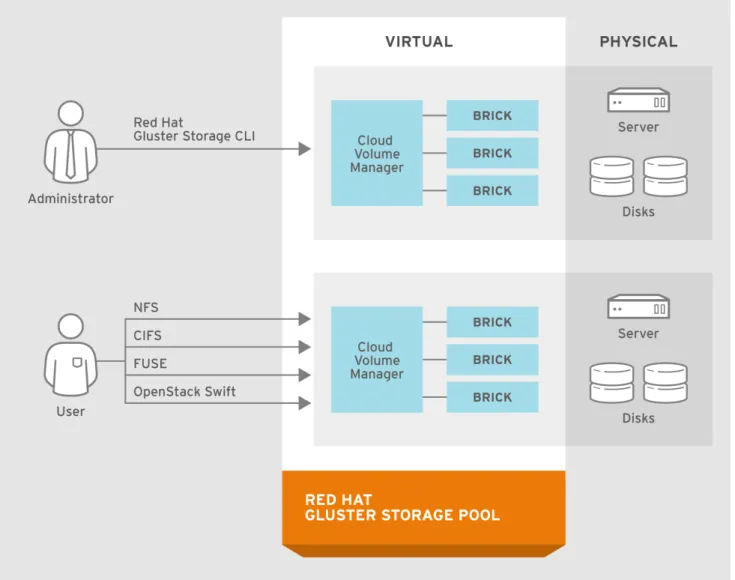

2.1. アーキテクチャー

Red Hat Gluster Storage の設計の中核となるのは、ストレージを設計する全く新しい方法です。その 結果、スケーラビリティーが非常に高く、非常に回復性があり、パフォーマンスを提供します。 スケールアウトしたシステムでは、データとメタデータの論理的および物理的な場所を追跡することが 最大の課題の 1 つです。ほとんどの分散システムは、データおよびメタデータの場所を追跡するために メタデータサーバーを作成してこの問題を解決します。従来のシステムでは、より多くのファイル、 サーバー、またはディスクを追加すると、中央メタデータサーバーはパフォーマンスのボトルネックと なり、中央の障害点となります。

他の従来のストレージソリューションとは異なり、Red Hat Gluster Storage はメタデータサーバーを 必要としず、Elastic ハッシュアルゴリズムを使用してファイルをアルゴリズム的に特定します。この no-metadata サーバーアーキテクチャーにより、パフォーマンス、線形のスケーラビリティー、および 信頼性が向上します。

図

図2.1 Red Hat Gluster Storage Architecture

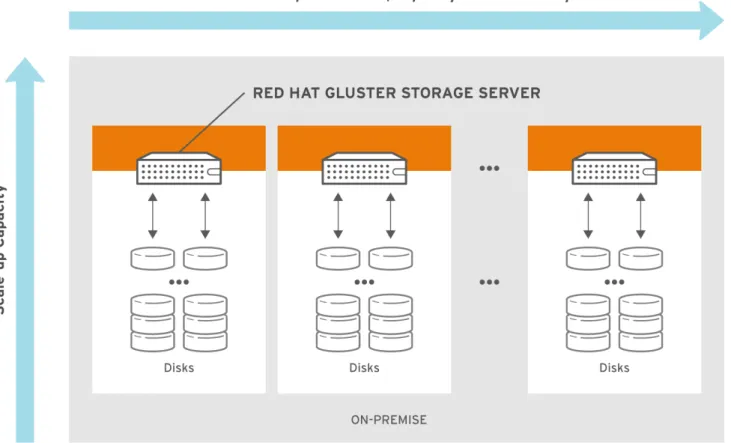

2.2. オンプレミス型アーキテクチャー

Red Hat Gluster Storage for オンプレミスでは、汎用ストレージハードウェアを使用して、仮想化、ス ケーラブルで集中管理されたストレージプールとして物理ストレージを処理できます。 共有ストレージ上の論理ボリュームにユーザーまたはグループをパーティション分割することで、マル チテナンシーをサポートします。これにより、高コストでモノリシックなストレージアレイへの依存を なくし、減らしたり、管理したりできます。 各種ワークロードで容量を数分で追加できますが、パフォーマンスに影響を及ぼすことはありません。 ストレージはさまざまなワークロードで一元管理できるため、ストレージ効率が向上します。 図

図2.2 オンプレミス型アーキテクチャー向けのオンプレミス型アーキテクチャー向けの Red Hat Gluster Storage

Red Hat Gluster Storage for オンプレミスは、glusterFS をベースとしています。これは、モジュール 型でスタック可能な設計を備えたオープンソースの分散ファイルシステムであり、固有の no-metadata サーバーアーキテクチャーです。この no-metadata サーバーアーキテクチャーにより、パフォーマン ス、線形のスケーラビリティー、および信頼性が向上します。

2.3. ストレージの概念

以下は、『Red Hat Gluster Storage Administration Guide 』 で使用されているファイルシステムおよび ストレージに関する一般的な用語です。 ブリック ブリック glusterFS の基本ストレージユニット。信頼済みストレージプール内のサーバーのエクスポートディ レクトリーによって表されます。ブリックは、以下の形式でサーバーとエクスポートディレクト リーを組み合わせることで表現されます。 SERVER:EXPORT 例:

myhostname:/exports/myexportdir/

ボリューム ボリューム

ボリュームは、ブリックの論理的なコレクションです。Red Hat Gluster Storage の管理操作の大半 は、ボリュームで行われます。 translator トランスレーターは、1 つ以上のサブボリュームに接続し、それらのサブボリュームで何かを行い、 サブボリューム接続を提供します。 サブボリューム サブボリューム 1 つ以上の翻訳者が処理した後のブリックです。 volfile

ボリューム(vol)ファイルは、Red Hat Gluster Storage の信頼済みストレージプールの動作を決定す る設定ファイルです。高いレベルでは、GlusterFS にはサーバー、クライアント、および管理デーモ ンの 3 つのエンティティーがあります。これらのエンティティーのそれぞれに独自のボリューム ファイルがあります。サーバーおよびクライアントのボリュームファイルは、ボリュームの作成時 に管理デーモンによって生成されます。 サーバーおよびクライアント POWER ファイルは /var/lib/glusterd/vols/VOLNAME ディレクトリー にあります。管理デーモン vol ファイルの名前は glusterd.vol、/etc/glusterfs/ ディレクトリーに置 かれています。

警告

警告

Red Hat は管理デーモンで生成されていない vol ファイルをサポートしないた め、/var/lib/glusterd 手動で vol ファイルを変更することはできません。 glusterd glusterd は、信頼されるストレージプールのすべてのサーバーで実行する必要がある glusterFS 管理 サービスです。 クラスター クラスター リンクされたコンピューターの信頼できるプールで、1 つのコンピューティングリソースと同様にな ります。Red Hat Gluster Storage では、クラスターは信頼できるストレージプールとも呼ばれま す。 Client ボリュームをマウントするマシン(サーバーでもある可能性があります)。 ファイルシステム ファイルシステム コンピューターファイルを保存し、整理する方法。ファイルシステムは、コンピューターのオペ レーティングシステムによるストレージ、操作、取得のためにファイルをデータベースに整理しま す。

Source:─ ─ 分散ファイルシステム 分散ファイルシステム 複数のクライアントが、信頼済みストレージプール内のサーバー/ブランチ全体に分散されている データを同時にアクセスできるようにするファイルシステム。複数の場所間で共有されるデータ は、すべての分散ファイルシステムに不可欠です。 仮想ファイルシステム 仮想ファイルシステム(VFS) VF は、標準の Linux ファイルシステムに関連するすべてのシステムコールを処理するカーネルソフ トウェア層です。これは、さまざまなファイルシステムに共通のインターフェースを提供します。 POSIX Unix 用の移植可能なオペレーティングシステムインターフェース(POSIX)は、アプリケーションプ ログラミングインターフェース(API)や、UNIX オペレーティングシステムのバリアントと互換性の あるソフトウェアのシェルおよびユーティリティーインターフェースを定義するために IEEE で指定 された関連標準ファミリーの名前です。Red Hat Gluster Storage が完全にエクスポート POSIX 互 換性のあるファイルシステム。 metadata メタデータは、他のデータに関する情報を提供するデータです。 FUSE ユーザー空間のファイルシステム(FUSE)は、Unix のようなオペレーティングシステム用のロード 可能なカーネルモジュールで、特権のないユーザーがカーネルコードを編集せずに独自のファイル システムを作成できるようにします。これは、ユーザー空間でファイルシステムコードを実行する ことで実現されます。 FUSE モジュールは、カーネルインターフェースに「bridge」のみを提供し ます。 Source:─ ─ geo-Replication geo レプリケーションは、ローカルエリアネットワーク()を介した、あるサイトから別のサイト への継続的、非同期、および増分レプリケーションサービスを提供します。LAN)、Wide Area Networks(WAN)およびインターネット。 n-way Replication

通常、アベイラビリティーゾーンまたは Amazon Web Services アベイラビリティーゾーン全体にデ プロイされるローカル同期データレプリケーション。 Petabyte Petabyte は、1 バイトまたは 1000 テラバイトに等しい情報の単位です。Petabyte の単位記号は PB です。接頭辞の Peta-(P)は、1000 のべき乗を表します。 1 PB = 1000,000,000,000 B = 1000^5 B = 10^15 B "pebibyte" という用語(PiB)は、バイナリー接頭辞を使用し、対応する(1024 のべき乗)に使用さ れます。 Source:─ ─ RAID

Redundant Array of Independent Disks(RAID)は、冗長性によりストレージの信頼性を向上させる 技術です。複数の低コストで信頼性が低いディスクドライブコンポーネントを、アレイ内のすべて のドライブが互いに依存する論理ユニットに統合されます。 RRDNS ラウンドロビンドメインネームサービス(RRDNS)は、アプリケーションサーバー間で負荷を分散 する方法です。RRDNS DNS サーバーのゾーンファイルに、同じ名前と異なる IP アドレスを持つ複 数のレコードを作成して実装されます。 Server データが保存されるファイルシステムをホストするマシン(仮想またはベアメタル)。 Block Storage ブロック特殊ファイル(ブロックデバイス)は、システムがブロックの形式でデータを移動するデ バイスに対応します。これらのデバイスノードは、多くの場合、ハードディスク、CD-ROM ドライ ブ、メモリー領域などのアドレス可能なデバイスを表します。Red Hat Gluster Storage 3.4 以降で は、ブロックストレージは Container-Native Storage(CNS)および Container-Ready Storage(CRS) のユースケースのみをサポートします。ブロックストレージは、gluster-block コマンドラインツー ルを使用してこのユースケース用に作成して設定できます。詳細は、「 『Container-Native

Storage for OpenShift Container Platform』 」を参照してください。 スケールアップストレージ スケールアップストレージ ストレージデバイスの容量を 1 つのディメンションで増やします。たとえば、信頼済みストレージ プールにディスク容量を追加する場合などです。 スケールアウトストレージ スケールアウトストレージ 単一ディメンションのストレージデバイスの機能を強化します。たとえば、同じサイズのシステム を追加するか、信頼済みストレージプールの CPU、ディスク容量、およびスループットを増加する 信頼済みストレージプールにサーバーを追加します。 信頼済みストレージプール 信頼済みストレージプール ストレージプールは、ストレージサーバーの信頼済みネットワークです。最初のサーバーを起動す ると、ストレージプールはそのサーバーのみで構成されます。 namespace 一意の識別子またはシンボルの論理グループを保持するために作成された抽象コンテナーまたは環 境。Red Hat Gluster Storage の信頼済みストレージプールはそれぞれ 1 つの namespace を POSIX マウントポイントとして公開します。これには、信頼できるストレージプール内のすべてのファイ ルが含まれます。 ユーザースペース ユーザースペース ユーザー空間で実行しているアプリケーションは、ハードウェアと直接対話するのではなく、カー ネルを使用してアクセスを緩和します。ユーザー空間アプリケーションは、一般的にカーネル領域 のアプリケーションよりも移植性があります。glusterFS はユーザー空間アプリケーションです。 分散ハッシュテーブル用語 分散ハッシュテーブル用語 ハッシュ化されたサブボリューム ハッシュ化されたサブボリューム ファイルまたはディレクトリー名がハッシュされる分散ハッシュテーブル変換サブボリューム。

キャッシュされたサブボリューム キャッシュされたサブボリューム ファイルの内容が実際に存在する分散ハッシュテーブル変換サブボリューム。ディレクトリーの場 合は、cached-subvolume の概念には関連しません。これは、ハッシュ化/サブボリュームではない サブボリュームの意味を緩やかに使用します。 Linkto-file 新たに作成されたファイルでは、ハッシュ化されたサブボリュームとキャッシュされたサブボ リュームは同じになります。ファイル内のデータ全体を新しいハッシュ化されたサブボリュームに 移動する代わりに、名前変更などのディレクトリーエントリー操作(ファイルの名前やファイルサ ブボリュームの変更が可能)が実行されると、新たにハッシュされたサブボリュームに同じ名前の ファイルが作成されます。このファイルの目的は、データが存在するノードへのポインターとして のみ動作することです。このファイルの拡張属性では、キャッシュされたサブボリュームの名前が 保存されます。新たに hashed-subvolume のこのファイルは linkto-file と呼ばれます。linkto ファイ ルは、ディレクトリー以外のエンティティーにのみ関連します。 ディレクトリーのレイアウト ディレクトリーのレイアウト ディレクトリーレイアウトは、gluster ボリュームのファイルを保存する場所を特定するのに役立ち ます。 クライアントがファイルを作成またはリクエストすると、DHT トランスレーターはファイルのパス をハッシュ化して整数を作成します。gluster サブボリュームの各ディレクトリーは、特定の範囲の 整数を持つファイルを保持します。そのため、指定されたファイルでは、gluster ボリューム内の特 定のサブボリュームにハッシュがマッピングされます。ディレクトリーレイアウトは、すべてのサ ブボリュームで指定のディレクトリーに割り当てられる整数範囲を決定します。 ディレクトリーのレイアウトは、ディレクトリーの初回作成時に割り当てられ、ボリュームでリバ ランス操作を実行して再割り当てできます。ディレクトリーの作成時にブリックまたはサブボ リュームがオフラインの場合、リバランスが実行されるまでレイアウトには含まれません。 ボリュームをリバランスして、ボリュームにブリックを追加した後にディレクトリーレイアウトを 再計算する必要があります。詳細は「ボリュームのリバランス」 を参照してください。 修正レイアウト 修正レイアウト リバランスプロセス中に実行されるコマンド。 リバランスプロセス自体は 2 つのステージで構成されます。 1. 追加または削除されたサブボリュームに対応するために、ディレクトリーのレイアウトを修 正します。またディレクトリーを修復し、レイアウトが連続していないかどうかを確認し、 必要に応じて拡張属性でレイアウトを永続化します。また、ディレクトリーにすべてのサブ ボリュームで同じ属性があることも保証します。 2. キャッシュされたサブボリュームから hashed-subvolume にデータを移行します。

第

3章 RED HAT GLUSTER STORAGE における考慮事項

3.1. ファイアウォールおよびポートアクセス

Red Hat Gluster Storage が適切に機能するには、複数のポートへのアクセスが必要です。に従って、 ポートアクセスが利用可能であることを確認し「ポートアクセス要件」 ます。

3.1.1. ファイアウォールの設定

ファイアウォール設定ツールは、Red Hat Entperise Linux 6 と Red Hat Enterprise Linux 7 では異なり ます。

Red Hat Enterprise Linux 6 の場合は、以下の iptables コマンドを使用してポートを開きます。 # iptables -A INPUT -m state --state NEW -m tcp -p tcp --dport 5667 -j ACCEPT

# service iptables save

Red Hat Enterprise Linux 7 では、デフォルトのポートが他のサービスで使用されていない場合、通常は ポートを開くのではなくサービスを追加する方が簡単です。

# firewall-cmd --zone=zone_name --add-service=glusterfs

# firewall-cmd --zone=zone_name --add-service=glusterfs --permanent

ただし、デフォルトのポートがすでに使用されている場合は、以下のコマンドで特定のポートを開くこ とができます。

# firewall-cmd --zone=zone_name --add-port=port/protocol

# firewall-cmd --zone=zone_name --add-port=port/protocol --permanent 例:

# firewall-cmd --zone=public --add-port=5667/tcp

# firewall-cmd --zone=public --add-port=5667/tcp --permanent

3.1.2. ポートアクセス要件

表 表3.1 すべてのストレージサーバーで次のポートを開きます。すべてのストレージサーバーで次のポートを開きます。 接続ソース 接続ソース TCP ポートポート UDP ポートポート 以下で推奨されま以下で推奨されま す。 す。 用途 用途 有効な SSH キーを 持つ認証ネット ワークエンティ ティー 22 - すべての設定 geo レプリケー ションを使用した リモートバック アップ認証されたネット ワークエンティ ティー。他の RPC サービスと競合し ないように注意し てください。 111 111 すべての設定 RPC ポートマッ パーと RPC バイン ド 承認された SMB/CIFS クライ アント 139 および 445 137 および 138 SMB/CIFS を使用 したストレージの 共有 SMB/CIFS プロト コル 承認された NFS ク ライアント 2049 2049 Gluster NFS また は NFS-Ganesha を使用したスト レージの共有 NFS プロトコルを 使用したエクス ポート Samba-CTDB ク ラスターのすべて のサーバー 4379 - SMB および Gluster NFS を使 用したストレージ の共有 CTDB 認可されたネット ワークエンティ ティー 24007 - すべての設定 glusterd を使用し た管理プロセス 認可されたネット ワークエンティ ティー 24009 - すべての設定 Gluster イベント デーモン NFSv3 クライアン ト 662 662 NFS-Ganesha お よび Gluster NFS を使用したスト レージの共有 statd NFSv3 クライアン ト 32803 32803 NFS-Ganesha お よび Gluster NFS を使用したスト レージの共有 NLM プロトコル マウント要求を送 信する NFSv3 ク ライアント - 32769 Gluster NFS を使 用したストレージ の共有 Gluster NFS MOUNT プロトコ ル マウント要求を送 信する NFSv3 ク ライアント 20048 20048 NFS-Ganesha を 使用したストレー ジの共有 NFS-Ganesha MOUNT プロトコ ル 接続ソース 接続ソース TCP ポートポート UDP ポートポート 以下で推奨されま以下で推奨されま す。 す。 用途 用途

NFS クライアント 875 875 NFS-Ganesha を 使用したストレー ジの共有 NFS-Ganesha RQUOTA プロトコ ル(クォータ情報 の取得) pacemaker/corosy nc クラスターの サーバー 2224 - NFS-Ganesha を 使用したストレー ジの共有 pcsd pacemaker/corosy nc クラスターの サーバー 3121 - NFS-Ganesha を 使用したストレー ジの共有 pacemaker_remot e pacemaker/corosy nc クラスターの サーバー - 5404 および 5405 NFS-Ganesha を 使用したストレー ジの共有 corosync pacemaker/corosy nc クラスターの サーバー 21064 - NFS-Ganesha を 使用したストレー ジの共有 dlm 認可されたネット ワークエンティ ティー 49152 - 49664 - すべての設定 ブリックな通信 ポート。必要な ポートの合計数 は、ノード上のブ リック数によって 異なります。マシ ン上のブリックご とに 1 つのポート が必要です。 接続ソース 接続ソース TCP ポートポート UDP ポートポート 以下で推奨されま以下で推奨されま す。 す。 用途 用途 表 表3.2 NFS-Ganesha およびおよび Gluster NFS ストレージクライアントで以下のポートを開きます。ストレージクライアントで以下のポートを開きます。 接続ソース 接続ソース TCP ポートポート UDP ポートポート 以下で推奨されま以下で推奨されま す。 す。 用途 用途 NFSv3 サーバー 662 662 NFS-Ganesha お よび Gluster NFS を使用したスト レージの共有 statd NFSv3 サーバー 32803 32803 NFS-Ganesha お よび Gluster NFS を使用したスト レージの共有 NLM プロトコル

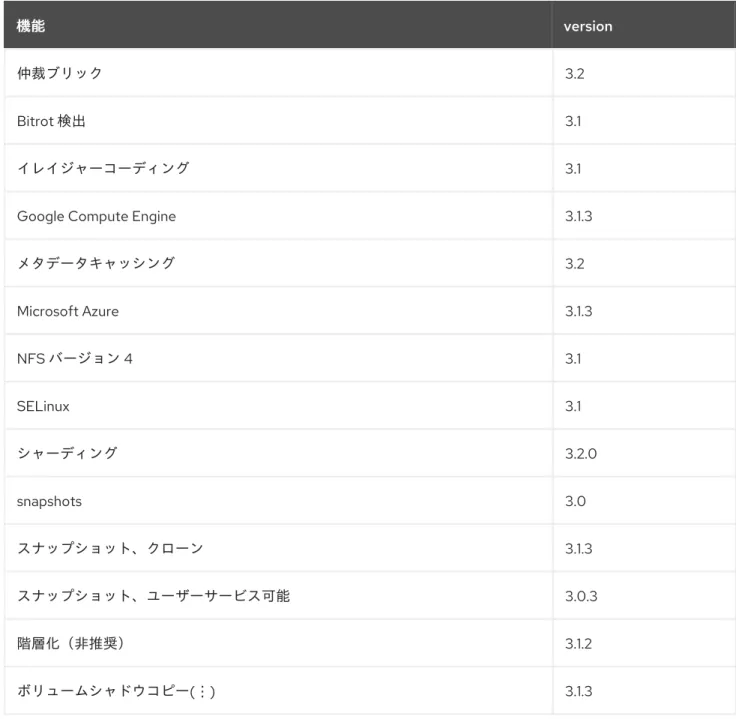

3.2. 機能互換性サポート

Red Hat Gluster Storage は、多くの機能をサポートします。ほとんどの機能は他の機能でサポートさ れていますが、一部の例外があります。本セクションでは、Red Hat Gluster Storage デプロイメント のプランニングに役立ちます。

注記

注記

Internet Protocol Version 6(IPv6)のサポートは、Red Hat Hyperconverged Infrastructure for Virtualization 環境でのみ利用可能で、Red Hat Gluster Storage スタンドアロン環境 では利用できません。

以下の表の機能は、指定バージョン以降でサポートされます。 表

表3.3 Red Hat Gluster Storage バージョンでサポートされる機能バージョンでサポートされる機能

機能

機能 version

仲裁ブリック 3.2

Bitrot 検出 3.1

イレイジャーコーディング 3.1

Google Compute Engine 3.1.3

メタデータキャッシング 3.2 Microsoft Azure 3.1.3 NFS バージョン 4 3.1 SELinux 3.1 シャーディング 3.2.0 snapshots 3.0 スナップショット、クローン 3.1.3 スナップショット、ユーザーサービス可能 3.0.3 階層化(非推奨) 3.1.2 ボリュームシャドウコピー(⋮) 3.1.3 表 表3.4 ボリューム種別でサポートされる機能ボリューム種別でサポートされる機能

ボリューム ボリューム 種別 種別 シャーディ シャーディ ング ング 階層化(非 階層化(非 推奨) 推奨)

quota snapshots geo-Rep Bitrot

Arbitrated-Replicated ◯ いいえ ◯ ◯ ◯ ◯ Distributed (分散) いいえ ◯ ◯ ◯ ◯ ◯ Distributed-Dispersed いいえ ◯ ◯ ◯ ◯ ◯ Distributed-Replicated ◯ ◯ ◯ ◯ ◯ ◯ Replicated (レプリ ケート) ◯ ◯ ◯ ◯ ◯ ◯ シャード N/A いいえ いいえ いいえ ◯ いいえ 階層化(非 推奨)

いいえ N/A 限定的[a] 限定的[a] 限定的[a] 限定的[a]

[a] 詳細は、『 『Red Hat Gluster Storage 3.5 Administration Guide』』 の「Tibing Limitations 」を参照してください。

表 表3.5 クライアントプロトコルがサポートする機能クライアントプロトコルがサポートする機能 機能 機能 FUSE Gluster-NFS NFS-Ganesha SMB Arbiter ◯ ◯ ◯ ◯ Bitrot 検出 ◯ ◯ いいえ ◯ dm-cache ◯ ◯ ◯ ◯ 暗号化(TLS-SSL) ◯ ◯ ◯ ◯ イレイジャーコーディング ◯ ◯ ◯ ◯ export サブディレクトリー ◯ ◯ ◯ N/A geo-replication ◯ ◯ ◯ ◯ quota ◯ ◯ ◯ ◯

RDMA(非推奨)

警告

警告

Red Hat Gluster Storage 3.5 では、RDMA をトランスポー トプロトコルとして使用する ことは非推奨とみなされま す。Red Hat では、その使用 を推奨せず、Red Hat Gluster Storage 3.5 での新規デプロイ メントをサポートしません。 Red Hat Gluster Storage 3.5 にアップグレードする既存の デプロイメントは引き続きサ ポートされます。 ◯ いいえ いいえ いいえ snapshots ◯ ◯ ◯ ◯ スナップショットのクローン作成 ◯ ◯ ◯ ◯ 階層化 ◯ ◯ N/A N/A 機能 機能 FUSE Gluster-NFS NFS-Ganesha SMB

第

4章 信頼済みストレージプールへのサーバーの追加

ストレージプールは、ストレージサーバーのネットワークです。 最初のサーバーが起動すると、ストレージプールはそのサーバーのみで構成されます。ストレージプー ルにストレージサーバーを追加する場合は、実行中の信頼済みストレージサーバーから probe コマンド を使用します。重要

重要

信頼済みストレージプールにサーバーを追加する前に、指定したポートが開いて3章Red Hat Gluster Storage における考慮事項 いることを確認する必要があります。Red Hat Enterprise Linux 7 では、以下のコマンドを使用して、ランタイムモードおよび 永続モードのアクティブなゾーンで glusterFS ファイアウォールサービスを有効にしま す。 アクティブなゾーンの一覧を取得するには、以下のコマンドを実行します。 # firewall-cmd --get-active-zones アクティブなゾーンでファイアウォールサービスを許可するには、以下のコマンドを実 行します。

# firewall-cmd --zone=zone_name --add-service=glusterfs

# firewall-cmd --zone=zone_name --add-service=glusterfs --permanent

『ファイアウォールの使用方法は、『 『 Red Hat Enterprise Linux 7 セキュリティーガイ ド』』 の「ファイアウォールの使用』 」を参照してください https://access.redhat.com/documentation/en-US/Red_Hat_Enterprise_Linux/7/html/Security_Guide/sec-Using_Firewalls.html。

注記

注記

2 つの gluster コマンドが同じボリュームで同時に実行されると、以下のエラーが表示さ れます。 別のトランザクションが進行中です。 別のトランザクションが進行中です。Red Hat Gluster Storage におけるこの動作により、複数のコマンドが同時にボリューム 設定を変更できないため、結果として一貫性がなくなる可能性があります。このような 実装は、Red Hat Gluster Storage Console や Red Hat Enterprise Virtualization Manager などのモニタリングフレームワークがある環境で一般的に使用されます。たとえば、4 つの Red Hat Gluster Storage Trusted Storage Pool では、このメッセージが 2 つのノー ドから同時に gluster volume status VOLNAME コマンドを実行すると確認されます。

4.1. 信頼済みストレージプールへのサーバーの追加

この gluster peer probe [server] コマンドは、サーバーを信頼されたサーバープールに追加するために 使用されます。

注記

注記

低いバージョンの Red Hat Gluster Storage ノードのプローブには対応していません。 信頼済みストレージプールへの 信頼済みストレージプールへの 3 つのサーバーの追加つのサーバーの追加 ボリュームを構成する 3 つのストレージサーバーで構成される信頼済みストレージプールを作成しま す。 前提条件 前提条件 glusterd サービスを、信頼できるストレージプールに追加する必要があるすべてのストレージ

サーバーで実行している必要があります。service start コマンドおよび stop コマンドについて は、22章glusterd サービスの起動と停止 を参照してください。

Server1信頼されたストレージサーバーが起動している。

ターゲットサーバーのホスト名は、DNS で解決できる必要があります。

1. サーバー 1 gluster peer probe [server] から実行して、追加のサーバーを信頼済みストレージ プールに追加します。

注記

注記

自己調査では、デフォルトで信頼さ Server1 れるストレージプールの一部で あるため、エラーが発生します。 ピアプローブは、デバイスに割り当てられた IP/ホスト名を使用して実行す る必要があります。# gluster peer probe server2 Probe successful

# gluster peer probe server3 Probe successful

# gluster peer probe server4 Probe successful

2. 以下のコマンドを使用して、すべてのサーバーからのピアステータスを確認します。 # gluster peer status

Number of Peers: 3 Hostname: server2

Uuid: 5e987bda-16dd-43c2-835b-08b7d55e94e5 State: Peer in Cluster (Connected)

Hostname: server3

Uuid: 1e0ca3aa-9ef7-4f66-8f15-cbc348f29ff7 State: Peer in Cluster (Connected)

Hostname: server4

Uuid: 3e0caba-9df7-4f66-8e5d-cbc348f29ff7 State: Peer in Cluster (Connected)

重要

重要

既存の信頼済みストレージプールに geo レプリケーションセッションがある場合、新規 サーバーを信頼済みストレージプールに追加した後に、に記載の手順を実施し「新規に 追加された Brick、ノード、またはボリュームでの Geo レプリケーションの開始」 ま す。注記

注記

以下のコマンドを実行して、すべての Gluster ノードで時刻が同期されていることを確 認します。# for peer in `gluster peer status | grep Hostname | awk -F':' '{print $2}' | awk '{print $1}'`; do clockdiff $peer; done

4.2. 信頼済みストレージプールからのサーバーの削除

警告

警告

信頼できるストレージプールからピアをデタッチする前に、クライアントがノード を使用しないことを確認してください。backup-volfile-servers オプションを使用し てバックアップサーバーがマウント時に設定されていない場合は、信頼されるスト レージプール内の別のサーバーの IP アドレスまたは FQDN を使用して、クライア ントのボリュームを再マウントし、不整合を回避します。gluster peer detach server を実行して、ストレージプールからサーバーを削除します。

信頼済みストレージプールからの 信頼済みストレージプールからの 1 つのサーバーの削除つのサーバーの削除 信頼済みストレージプールから 1 つのサーバーを削除し、ストレージプールのピアステータスを確認し ます。 前提条件 前提条件 ストレージプールから削除するために、glusterd サービスはターゲットのサーバー上で実行さ

れている必要があります。service start コマンドおよび stop コマンドについては、22

章glusterd サービスの起動と停止 を参照してください。

ターゲットサーバーのホスト名は、DNS で解決できる必要があります。

1. gluster peer detach [server] を実行して、信頼済みストレージプールからサーバーを削除しま す。

2. 以下のコマンドを使用して、すべてのサーバーからのピアステータスを確認します。 # gluster peer detach server4

Detach successful

# gluster peer status Number of Peers: 2 Hostname: server2

Uuid: 5e987bda-16dd-43c2-835b-08b7d55e94e5 State: Peer in Cluster (Connected)

Hostname: server3

第

5章 ストレージボリュームの設定

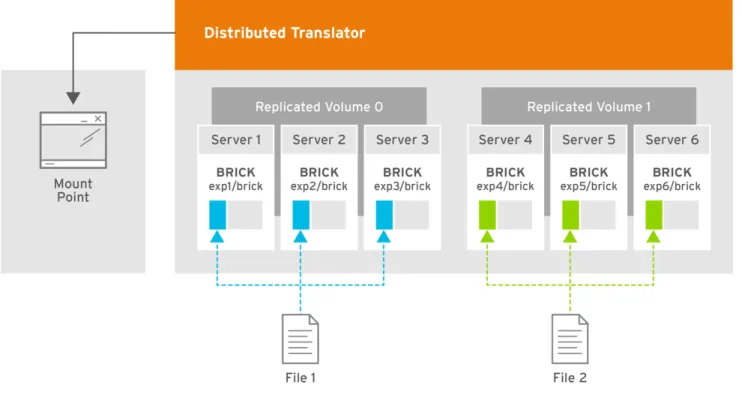

Red Hat Gluster Storage ボリュームはブリックの論理的なコレクションで、各ブリックは信頼済みス トレージプール内のサーバー上のエクスポートディレクトリーになります。Red Hat Gluster Storage Server の管理操作の大半は、ボリューム上で実行されます。パフォーマンスを強化する Red Hat Gluster Storage の設定に関する詳細は、を参照してください。 19章パフォーマンスチューニング

警告

警告

Red Hat は、ブリックへのデータを直接書き込むことはサポートしていません。ネ イティブクライアント、または NFS または SMB マウントを介してのみデータの読 み取りおよび書き込みを行います。注記

注記

Red Hat Gluster Storage は IPoIB(IPoIB)をサポートします。この機能をサポートするた めに、すべての Red Hat Gluster Storage サーバーおよびクライアントに Infiniband パッ ケージをインストールします。を実行し yum groupinstall "Infiniband Support" て Infiniband パッケージをインストールします。 ボリューム種別 ボリューム種別 Distributed(分散)(分散) ファイルをボリューム内のブリックに分散します。 スケーリングおよび冗長性の要件が重要ではない場合や、他のハードウェアまたはソフトウェア層 で提供されるボリューム種別を使用してください。 このボリューム種別「分散ボリュームの作成」 に関する追加情報は、を参照してください。 Replicated(レプリケート)(レプリケート) ボリューム内のブリック間でファイルを複製します。 高可用性と信頼性が高い環境で、このボリューム種別を使用します。 このボリューム種別「Replicated ボリュームの作成」 に関する追加情報は、を参照してください。 Distributed Replicated ファイルをボリューム内の複製されたブリック全体に分散します。 信頼性とスケーラビリティーが重要な環境で、このボリューム種別を使用します。このボリューム 種別により、ほとんどの環境で読み取りパフォーマンスが向上します。 このボリューム種別「分散複製ボリュームの作成」 に関する追加情報は、を参照してください。 調整済み 調整済み Replicated レプリカセット内の 2 つのブリック間でファイルを複製し、3 番目のブリックにメタデータのみを 複製します。

一貫性が重要ですが、基礎となるストレージ領域がプレミアムにある環境で、このボリューム種別 を使用します。 このボリューム種別「任意の複製ボリュームの作成」 に関する追加情報は、を参照してください。 dispersed ファイルのデータをボリューム内のブリック全体に分散します。 このボリューム種別は、領域が最小で設定可能な信頼性のレベルを必要とする場合に使用します。 このボリューム種別「分散ボリュームの作成」 に関する追加情報は、を参照してください。 分散分散分散型 分散分散分散型(Distributed Dispersed) ファイルのデータを分散サブボリューム全体に分散します。 このボリューム種別は、領域が最小で設定可能な信頼性のレベルを必要とする場合に使用します。 このボリューム種別「分散分散ボリュームの作成」 に関する追加情報は、を参照してください。

5.1. GDEPLOY を使用した GLUSTER ストレージボリュームの設定

gdeploy ツールは、ブリックの作成、フォーマット、およびマウントプロセスを自動化します。 gdeploy を使用すると、『セクション 5.4 フォーマットとマウント用ブリックとセクション 5.10』 『分 散分散ボリュームの間に一覧表示される手動の手順が』 自動化されます。 新しい信頼済みストレージプールを設定する際には、多くのコマンドを手動で実行するとエラーが生じ る可能性があるため、gdeploy が、信頼済みストレージプールの設定に推奨される選択肢となる可能性 があります。 gdeploy を使用してブリック作成を自動化する利点は以下のとおりです。 バックエンドを複数のマシンに設定することは、1 台のラップトップ/デスクトップから実行で きます。これにより、信頼されるストレージプールのノード数が増えると、時間節約とスケー ルアップが適切になります。 設定するドライブを選択する柔軟性。(sd、vd、...)。 論理ボリューム(LV)およびボリュームグループ(VG)の命名を柔軟に行うことができます。5.1.1. 使ってみる

前提条件 前提条件 1. 以下のコマンドを実行して、信頼済みストレージプールの一部であるノードにパスフレーズな しの SSH キーを生成します。 # ssh-keygen -t rsa -N '' 2. 以下のコマンドを実行して、gdeploy コントローラーとサーバー間の鍵ベースの SSH 認証アク セスを設定します。 # ssh-copy-id -i root@server注記

注記

Red Hat Gluster Storage ノードを外部ノードではなくデプロイメントノードと して使用する場合は、インストールを実行する Red Hat Gluster Storage ノード 用に鍵ベースの SSH 認証を設定する必要があります。

3. 以下のコマンドを実行して、Ansible のインストールに必要なリポジトリーを有効にします。 For Red Hat Enterprise Linux 8

# subscription-manager repos --enable=ansible-2-for-rhel-8-x86_64-rpms For Red Hat Enterprise Linux 7

# subscription-manager repos --enable=rhel-7-server-ansible-2-rpms 4. 以下のコマンド ansible を実行してインストールします。

# yum install ansible

5. また、以下も確認する必要があります。 デバイスが未使用である必要があります。

デフォルトのシステムロケールは、に設定する必要があります。 en_US

システムロケールの詳細は、『 『Red Hat Enterprise Linux 7 システム管理者 『 のガイド』 の「システムロケールの設定』 」を参照してください』。

複数のデバイスには、gdeploy 設定ファイルで複数のボリュームグループ、シンプール、

および thinvol を使用します。

詳細は、『 『Red Hat Gluster Storage 3.5 Installation Guide』の 「Installing Ansible to Support Gdeploy」を参照してください』。

gdeploy を使用すると、Red Hat Gluster Storage を以下の 2 つの方法でデプロイできます。 信頼済みストレージプールでのノードの使用

信頼できるストレージプール外部のマシンの使用 クラスター内のノードの使用

クラスター内のノードの使用

この gdeploy パッケージは、Red Hat Gluster Storage の初期インストールの一部としてバンドルされ ます。

信頼できるストレージプール外部のマシンの使用 信頼できるストレージプール外部のマシンの使用

Red Hat Gluster Storage が必要なチャンネルにサブスクライブされていることを確認する必要があり ます。詳細は、『 『Red Hat Gluster Storage 『3.5 Installation Guide』の「Subscribing to the Red Hat

Gluster Storage Server Channels」を参照してください』 』。 以下のコマンドを実行して gdeploy をインストールします。

インストールの詳細は、『 『Red Hat Gluster Storage 3.5 Installation Guide』 『 の「Installing Ansible

to Support』 Gdeploy」セクションを gdeploy 参照してください』。

5.1.2. 信頼済みストレージプールの設定

信頼済みストレージプールの作成は問題なく、信頼できるストレージプールのノードが大きくなるた め、より不注意になります。gdeploy を使用すると、設定ファイルのみを使用して、信頼できるスト レージプールを設定できます。gdeploy がインストールされると、設定ファイルのサンプルがに作成さ れます。 /usr/share/doc/gdeploy/examples/gluster.conf.sample注記

注記

信頼済みストレージプールは、バックエンドの設定、ボリュームの作成、ボリュームの マウントなどの各タスクを実行するか、または単一の設定として要約して作成できま す。 たとえば、3 x 3 の基本的な信頼済みストレージプールでは、ボリュームを複製すると、設定ファイル の設定詳細は以下のようになります。 3x3-volume-create.conf: # # Usage: # gdeploy -c 3x3-volume-create.conf ## This does backend setup first and then create the volume using the # setup bricks. # # [hosts] 10.70.46.13 10.70.46.17 10.70.46.21

# Common backend setup for 2 of the hosts. [backend-setup] devices=sdb,sdc,sdd vgs=vg1,vg2,vg3 pools=pool1,pool2,pool3 lvs=lv1,lv2,lv3 mountpoints=/rhgs/brick1,/rhgs/brick2,/rhgs/brick3 brick_dirs=/rhgs/brick1/b1,/rhgs/brick2/b2,/rhgs/brick3/b3 # If backend-setup is different for each host

# [backend-setup:10.70.46.13] # devices=sdb

# brick_dirs=/rhgs/brick1 #

# brick_dirs=/rhgs/brick{1,2,3} # [volume] action=create volname=sample_volname replica=yes replica_count=3 force=yes [clients] action=mount volname=sample_volname hosts=10.70.46.15 fstype=glusterfs client_mount_points=/mnt/gluster この設定では、指定の IP アドレスとバックエンドデバイスを持つ 3 x 3 のレプリカ信頼済みストレージ プールが /dev/sdb /dev/sdc、/dev/sdd ボリューム名で作成 sample_volname されます。

可能な値の詳細は、を参照してください。「設定ファイル」 設定ファイルを変更したら、コマンドを使用して設定を呼び出します。 # gdeploy -c txt.conf

注記

注記

にあるテンプレートファイルを参照して、新しい設定ファイルを作成でき /usr/share/doc/gdeploy/examples/gluster.conf.sampleます。新しい設定ファイルを起 動するには、gdeploy -c /path_to_file/config.txt コマンドを実行します。 バックエンドを only 設定する方法は、を参照してください。 「バックエンドの設定 」 ボリュームを only 作成するには、を参照してください。 「ボリュームの作成」 クライアントを only マウントする場合は、を参照してください。 「クライアントのマウント」5.1.3. バックエンドの設定

Gluster Storage ボリュームを設定するには、LVM thin-p をストレージディスクに設定する必要があり ます。信頼できるストレージプールのマシン数が大きすぎると、コマンドの数が大きくなり、注意しな い場合にはエラーが発生してしまうため、これらのタスクに時間がかかります。gdeploy を使用する と、設定ファイルだけを使用してバックエンドを設定できます。バックエンドは、新規信頼されたスト レージプールの設定時に設定されています。これには、ボリュームを作成する前にブリックを設定する 必要があります。gdeploy がインストールされると、設定ファイルのサンプルがに作成されます。 /usr/share/doc/gdeploy/examples/gluster.conf.sample バックエンドは、以下の 2 つの方法で設定できます。 [backend-setup] モジュールの使用

物理ボリューム(PV)、ボリュームグループ(VG)、および論理ボリューム(LV)を個別に作成

注記

注記

Red Hat Enterprise Linux 6 の場合は、gdeploy を使用してバックエンドのブリックを設 定する前に、xfsprogs パッケージをインストールする必要があります。

5.1.3.1. [backend-setup] モジュールの使用

モジュールの使用

バックエンドの設定は、特定のマシンまたはすべてのマシンで実行できます。backend-setup モジュー ルは、PV、VG、および LV を内部に作成し、デバイスをマウントします。thin-p 論理ボリュームは、 Red Hat のパフォーマンスの推奨事項に従って作成されます。 バックエンドは、以下のような要件に基づいて設定できます。 generic 特定の generic ディスク名がマシン全体で統一されている場合は、バックエンドの設定は以下のように記述できます。 バックエンドは、'hosts' セクションのすべてのホストに対して設定されます。 可能な値の詳細は、を参照してください。「設定ファイル」 設定ファイルの例: Backend-setup-generic.conf # # Usage: # gdeploy -c backend-setup-generic.conf ## This configuration creates backend for GlusterFS clusters # [hosts] 10.70.46.130 10.70.46.32 10.70.46.110 10.70.46.77

# Backend setup for all the nodes in the `hosts' section. This will create # PV, VG, and LV with gdeploy generated names.

[backend-setup] devices=vdb 特定の 特定の クラスター内のマシン間でディスク名が異なる場合、バックエンドの設定は特定のディスク名を持つ特 定のマシン用に記述できます。gdeploy は、1 つの設定ファイルで特定の設定をホストするのが非常に 柔軟です。 可能な値の詳細は、を参照してください。「設定ファイル」 設定ファイルの例: backend-setup-hostwise.conf

#

# Usage:

# gdeploy -c backend-setup-hostwise.conf #

# This configuration creates backend for GlusterFS clusters # [hosts] 10.70.46.130 10.70.46.32 10.70.46.110 10.70.46.77

# Backend setup for 10.70.46.77 with default gdeploy generated names for # Volume Groups and Logical Volumes. Volume names will be GLUSTER_vg1, # GLUSTER_vg2...

[backend-setup:10.70.46.77] devices=vda,vdb

# Backend setup for remaining 3 hosts in the `hosts' section with custom names # for Volumes Groups and Logical Volumes.

[backend-setup:10.70.46.{130,32,110}] devices=vdb,vdc,vdd vgs=vg1,vg2,vg3 pools=pool1,pool2,pool3 lvs=lv1,lv2,lv3 mountpoints=/rhgs/brick1,/rhgs/brick2,/rhgs/brick3 brick_dirs=/rhgs/brick1/b1,/rhgs/brick2/b2,/rhgs/brick3/b3

5.1.3.2. PV、

、

VG、および

、および

LV の設定によるバックエンドの作成

の設定によるバックエンドの作成

バックエンドの設定に対する制御がさらに必要な場合は、pv、vg、および lv を個別に作成できます。 LV モジュールは、VPC に複数の LV を作成する柔軟性を提供します。たとえば、「backend-setup」 モジュールはデフォルトで thin-pool を設定し、デフォルトのパフォーマンス推奨事項を適用します。 ただし、ユーザーが複数の LV を要求するユースケースが異なり、シンプールとシックプールの組み合 わせにより「backend-setup」はヘルプにはなりません。ユーザーは、PV、VG、および LV モジュール を使用してこれを実行できます。 可能な値の詳細は、を参照してください。「設定ファイル」 以下の例は、1 つのボリュームグループに 4 つの論理ボリュームを作成する方法を示しています。この 例では、thinpool と shipool LV の作成を混在しています。 [hosts] 10.70.46.130 10.70.46.32 [pv] action=create devices=vdb [vg1] action=create vgname=RHS_vg1 pvname=vdb[lv1] action=create vgname=RHS_vg1 lvname=engine_lv lvtype=thick size=10GB mount=/rhgs/brick1 [lv2] action=create vgname=RHS_vg1 poolname=lvthinpool lvtype=thinpool poolmetadatasize=200MB chunksize=1024k size=30GB [lv3] action=create lvname=lv_vmaddldisks poolname=lvthinpool vgname=RHS_vg1 lvtype=thinlv mount=/rhgs/brick2 virtualsize=9GB [lv4] action=create lvname=lv_vmrootdisks poolname=lvthinpool vgname=RHS_vg1 size=19GB lvtype=thinlv mount=/rhgs/brick3 virtualsize=19GB 既存の VG を拡張する例: #

# Extends a given given VG. pvname and vgname is mandatory, in this example the # vg `RHS_vg1' is extended by adding pv, vdd. If the pv is not alreay present, it # is created by gdeploy. # [hosts] 10.70.46.130 10.70.46.32 [vg2] action=extend vgname=RHS_vg1 pvname=vdd

5.1.4. ボリュームの作成

ボリュームのセットアップには、ホスト名/IP を選択し、慎重に順序を選択して長いコマンドを記述す る必要があります。これは、エラーが発生する可能性があります。gdeploy はこのタスクを簡素化する のに役立ちます。gdeploy がインストールされると、設定ファイルのサンプルがに作成されます。 /usr/share/doc/gdeploy/examples/gluster.conf.sample たとえば、3 x 3 の基本的な信頼済みストレージプールでは、設定ファイルの設定詳細を以下のように 複製します。 [hosts] 10.0.0.1 10.0.0.2 10.0.0.3 10.0.0.4 [volume] action=create volname=glustervol transport=tcp,rdma replica=yes replica_count=3 brick_dirs=/glus/brick1/b1,/glus/brick1/b1,/glus/brick1/b1 force=yes 可能な値の詳細は、を参照してください。「設定ファイル」 設定ファイルを変更したら、コマンドを使用して設定を呼び出します。 # gdeploy -c txt.conf 複数のボリュームの作成 複数のボリュームの作成

注記

注記

gdeploy 2.0 からのみ複数のボリュームを作成することをサポート。この設定を試す前 に、gdeploy バージョンを確認してください。 1 つの設定で複数のボリュームを作成する場合には、[volume] モジュールに番号を付ける必要がありま す。たとえば、2 つのボリュームがある場合は、[volume1]、[volume2] という番号が付けられます。 vol-create.conf [hosts] 10.70.46.130 10.70.46.32 10.70.46.16 [backend-setup] devices=vdb,vdc,vdd,vde mountpoints=/mnt/data{1-6} brick_dirs=/mnt/data1/1,/mnt/data2/2,/mnt/data3/3,/mnt/data4/4,/mnt/data5/5,/mnt/data6/6 [volume1] action=createvolname=vol-one transport=tcp replica=yes replica_count=3 brick_dirs=/mnt/data1/1,/mnt/data2/2,/mnt/data5/5 [volume2] action=create volname=vol-two transport=tcp replica=yes replica_count=3 brick_dirs=/mnt/data3/3,/mnt/data4/4,/mnt/data6/6 gdeploy 2.0 では、複数のボリュームオプションを設定してボリュームを作成できます。キーの数は、 値の数に一致する必要があります。 [hosts] 10.70.46.130 10.70.46.32 10.70.46.16 [backend-setup] devices=vdb,vdc mountpoints=/mnt/data{1-6} [volume1] action=create volname=vol-one transport=tcp replica=yes replica_count=3 key=group,storage.owner-uid,storage.owner-gid,features.shard,features.shard-block-size,performance.low-prio-threads,cluster.data-self-heal-algorithm value=virt,36,36,on,512MB,32,full brick_dirs=/mnt/data1/1,/mnt/data3/3,/mnt/data5/5 [volume2] action=create volname=vol-two transport=tcp replica=yes key=group,storage.owner-uid,storage.owner-gid,features.shard,features.shard-block-size,performance.low-prio-threads,cluster.data-self-heal-algorithm value=virt,36,36,on,512MB,32,full replica_count=3 brick_dirs=/mnt/data2/2,/mnt/data4/4,/mnt/data6/6 上記の設定では、複数のボリュームオプションが設定されている 2 つのボリュームが作成されます。

5.1.5. クライアントのマウント

クライアントをマウントする場合、マウントする必要があるすべてのクライアントにログインするので はなく、gdeploy を使用してクライアントをリモートでマウントできます。gdeploy がインストールさ れると、設定ファイルのサンプルがに作成されます。/usr/share/doc/gdeploy/examples/gluster.conf.sample 以下は、クライアントをマウントするための設定ファイルの変更例です。 [clients] action=mount hosts=10.70.46.159 fstype=glusterfs client_mount_points=/mnt/gluster volname=10.0.0.1:glustervol

注記

注記

ファイルシステムのタイプ(fstype)が NFS の場合は、と記載し nfs-versionます。デフォ ルトのバージョンはです 3。 可能な値の詳細は、を参照してください。「設定ファイル」 設定ファイルを変更したら、コマンドを使用して設定を呼び出します。 # gdeploy -c txt.conf5.1.6. ボリュームの設定

ボリュームは、設定ファイルを使用して設定できます。信頼できるストレージプールにログインせずに 設定ファイルを使用して、ボリュームをリモートで設定できます。設定ファイルのセクションおよびオ プションの詳細は、を参照してください。「設定ファイル」5.1.6.1. Brick の追加と削除

の追加と削除

設定ファイルは、ブリックを追加または削除するために変更できます。 ブリックの追加 ブリックの追加 設定ファイルの [volume] セクションを変更して、ブリックを追加します。例: [volume] action=add-brick volname=10.0.0.1:glustervol bricks=10.0.0.1:/rhgs/new_brick 設定ファイルを変更したら、コマンドを使用して設定を呼び出します。 # gdeploy -c txt.conf ブリックの削除 ブリックの削除 設定ファイルの [volume] セクションを変更して、ブリックを削除します。例: [volume] action=remove-brick volname=10.0.0.1:glustervolbricks=10.0.0.2:/rhgs/brick state=commit

他のオプション state は stop、start、および force です。

設定ファイルを変更したら、コマンドを使用して設定を呼び出します。 # gdeploy -c txt.conf 可能な値の詳細は、を参照してください。「設定ファイル」

5.1.6.2. ボリュームのリバランス

ボリュームのリバランス

設定ファイルの [volume] セクションを変更して、ボリュームのリバランスを行います。例: [volume] action=rebalance volname=10.70.46.13:glustervol state=start他のオプション state は stop および fix-layout です。

設定ファイルを変更したら、コマンドを使用して設定を呼び出します。 # gdeploy -c txt.conf 可能な値の詳細は、を参照してください。「設定ファイル」

5.1.6.3. ボリュームの起動、停止、または削除

ボリュームの起動、停止、または削除

設定ファイルは、ボリュームを起動、停止、または削除するために変更できます。 ボリュームの起動 ボリュームの起動 設定ファイルの [volume] セクションを変更して、ボリュームを起動します。例: [volume] action=start volname=10.0.0.1:glustervol 設定ファイルを変更したら、コマンドを使用して設定を呼び出します。 # gdeploy -c txt.conf ボリュームの停止 ボリュームの停止 設定ファイルの [volume] セクションを変更して、ボリュームを起動します。例: [volume] action=stop volname=10.0.0.1:glustervol 設定ファイルを変更したら、コマンドを使用して設定を呼び出します。# gdeploy -c txt.conf ボリュームの削除 ボリュームの削除 設定ファイルの [volume] セクションを変更して、ボリュームを起動します。例: [volume] action=delete volname=10.70.46.13:glustervol 設定ファイルを変更したら、コマンドを使用して設定を呼び出します。 # gdeploy -c txt.conf 可能な値の詳細は、を参照してください。「設定ファイル」