招待論文

広域分散ネットワークを活用したディザスタリカバリ技術の実用化

宮保 憲治

†a)鈴木 秀一

†上野洋一郎

†市原 和雄

†R&D of Disaster Recovery System Technology by Making Use of Wide Area Distributed Network

Noriharu MIYAHO

†a), Shuichi SUZUKI

†, Yoichiro UENO

†, and Kazuo ICHIHARA

†あらまし 現在の高度情報化社会では,ほとんどの社会情報活動が電子情報基盤上で実現され,地震や火災等 の自然災害発生時やテロ活動等の場合における社会基盤システムの脆弱性が指摘されている.この状況に鑑み,

電子データのバックアップを,経済的にかつ高いセキュリティのもとで実現するディザスタリカバリ技術が,社 会的に要請されている.本論文では,安全に,かつ低コストでファイルバックアップを実現するために,広域に 分散されたクラウドのストレージリソースに加え,PC,スマートフォン,携帯端末,ディジタルサイネージなど に含まれるストレージの一部を,広域分散ネットワーク,高速ストリーム暗号,シャッフリング技術及びしきい 値秘密分散技術等を活用して実用化したディザスタリカバリの概念と技術内容について述べる.

キーワード ディザスタリカバリ,広域分散,しきい値秘密分散,高速ストリーム暗号

1.

ま え が き現在の高度情報化社会では,ほとんどの情報活動が 電子情報基盤上に実現され,企業・社会・行政支援活 動に対する基盤情報である重要電子データに対して は,故障時の可用性の保証に留まらず,地震や火災等 の自然災害やサイバー攻撃等を受けた場合でも,重要 電子データを安全にバックアップできるセキュアーな ディザスタリカバリの要望が高まりつつある.従来か ら,データバックアップ事業の継続性

(BCP: Business Continuity Plan)

を可能にする技術として,伝送回 線の冗長化,データセンタの二重化,複数の通信事業 者への二重帰属などの対処がなされている.しかし ながら,これらの手段はコストが嵩む割には,災害(

ディザスター)

発生時の重要データの保全に関して 万全とは言い難い.この理由は,バックアップ場所を 高々2

〜3

箇所程度増やしただけでは,同時災害に遭 遇する可能性は無視できないことに起因する.このた†東京電機大学大学院先端科学技術研究科情報メディア工学専攻,印 西市

Graduate School of Advanced Science and Technology, In- formation, Communication and Media Design Engineering, Tokyo Denki University, 2–1200 Muzai Gakuendai, Inzai-shi, 270–1382 Japan

a) E-mail: miyaho@mail.dendai.ac.jp

め,各種災害やサイバー攻撃等に備え,ファイルバッ クアップを安全かつ経済的に実現するための多くの試 みが模索されている

[1]

〜[9]

.国内外の通信環境に着 目すると,広域分散されたクラウドストレージに加 え,個人,公共機関あるいは企業が保有するPC

,携帯 端末,スマートフォン,ディジタルサイネージ,NAS (Network Attached Storage)

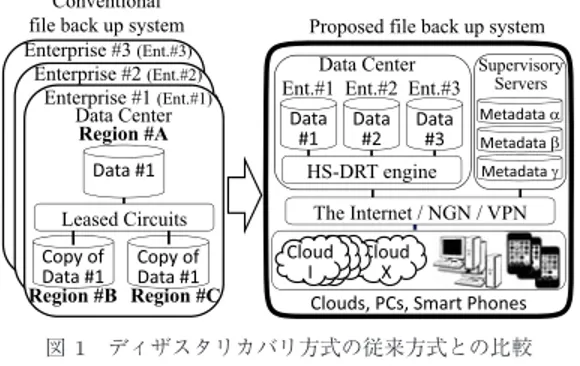

等の遊休メモリリソー スを分散ネットワークと高速ストリーム暗号を用いて 融合し,ネットワーク上のストレージ群を論理的に統 合できると考えられる.全体のストレージリソース群 を,大規模な仮想ファイルの一部として扱うことによ り,高信頼度のファイルバックアップ用システムと同 等の機能を低コストで実現することが可能である.こ の概念に基づいたファイルバックアップシステムのコ ンセプトを,従来の専用線システムと比較して図1

に 示す.このコンセプトは,高速ストリーム暗号ととも に,ファイルを一体化処理(

空間的に攪拌)

する技術と 分割・シャッフリング後にネットワーク上に分散転送 する技術を用いて,復号化に必要な暗号鍵のみをしき い値秘密分散[10], [11]

することにより機密性を保障で きる特徴をもつ(4. 2

参照)

.これら一連の技術を活用し,当該ファイルを暗号化 後に多数の断片ファイルに分割し,かつ,断片ファイ ルを異なる地域へ,再暗号化後に分散転送すること

図1 ディザスタリカバリ方式の従来方式との比較 Fig. 1 Comparison of the proposed system with a

conventional data backup system.

により,従来のバックアップサービスと比較して,飛 躍的に高い可用性と安全性を確保できるバックアップ サービスが実現可能になる.

一方,最近の無線技術の広帯域化が進展する中で,

映像情報を高速暗号化し,高いセキュリティで秘密に 伝送する需要は今後一層,高まりつつある.本論文で 述べる高信頼ファイルバックアップ技術の適用により,

秘密動画転送システムの実現も容易になる.実用化シ ステムの構成例は

7. 4

で述べる.2.

では,ディザスタリカバリの要求条件とサービス レベルを,3.

では,従来のディザスタリカバリシステ ムを,4.

では,ディザスタリカバリ技術の原理を,5.

では,計算量的安全性を,

6.

では,本方式における性 能評価を,7.

では,実用化システム例を述べ,8.

のむ すびでは,まとめと今後の課題を述べる.2.

ディザスタリカバリの要求条件とサービ スレベル世界中には,数

10

億台規模のPC

,携帯端末がネッ トワーク接続され,端末内蔵のメモリ容量は年々増 加し,32GB

〜64GB

程度のメモリ素子を実装したス マートフォンや大容量クラウドストレージが実現され ている.特にパブリッククラウドはユーザ宅に設置す る必要がなく,遠隔やオフィスから容易に活用できる ためBYOD (Bring Your Own Device)

としての利 用が進みつつある.ユーザにとっては,『安全なデータ 保管』と『確実な復旧』の二つの要求条件を満足させ る必要がある.安全なデータ保管の視点に関しては,第三者からの盗聴や改竄の危険性が無視できる手段を 提供することに配慮することが肝要である.更に,大 規模災害によるデータセンターの崩壊の事態に対して も,バックアップを保証できる条件を明確化する必要

がある.

ディザスタリカバリシステムの要求条件には,ユー ザのサービス要求レベルに見合った,セキュリティ上 の安全性と復旧時の確実性の保証を含める必要がある.

具体的には,ファイルのバックアップ処理時に,

1

セ キュリティ上の安全性のレベル2

復旧の確実性を保 証するレベルの二つのレベルを含む「サービスレベ ル」を設定した.これらは4.

で述べる本システムの動 作メカニズムの中では,ファイルデータの分割数と複 製数のパラメータ,及び分散地域等のパラメータを決 定することにより設定することが可能である.バック クアップサービスの提供事業者は,保管対象ファイル に対して,分割数,複製数を上述のサービスレベルに 基づいて適切に設定し,分割数の増減によりセキュリ ティレベルの高低を調整し,複製数の増減により,復 旧確率を向上させることが可能となる.分割数,複製 数,ストレージリソース(

断片データを保存するクラ イアント端末に対応)

の故障率をそれぞれ,m , n , p

と したとき,元データの復元には,分割された断片m

個 の各々に対して,それぞれがn

個複製された中から,どれか一つを回収できれば十分なため,ファイル回復 確率は次式

(1)

で求められる.ファイル回復確率

= (1 − p

n)

m(1)

ファイルバックアップ時の回復率(

可用性)

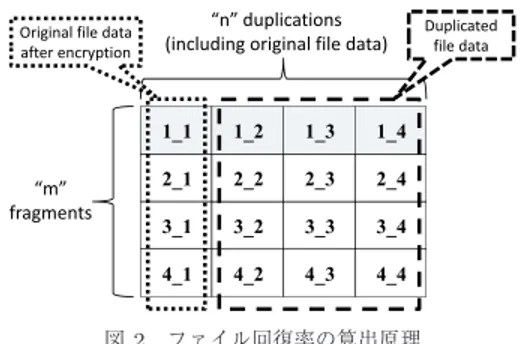

の算出原 理を図2

に示す.図2

では,m (

断片数)

とn (

複製 数)

をともに4

に設定し,各々の断片ファイル情報が 回収できない確率(

ファイル破損確率に対応) p

を安全 側で 15と見積った場合,各々の断片ファイル情報を回 復できる確率は,1 − p

n= 1 − p

4= 1 − (

15)

4 とな る.元のファイルはm (= 4)

分割されているので,元 の情報が全て回収できる確率(

ファイル回復確率)

は,(1 − p

n)

m= (1 − (

51)

4)

40 . 993615

と計算できる.本方式は断片数を増やすことにより,暗号強度を増す ことができ,一方,複製数を増やすことにより,回復 率を向上できる.分割数,複製数,故障率の値に着目 し,ユーザ個別の要求に基づいて,セキュリティ強度 やファイルの回復確率を,任意にカスタマイズできる ことが本方式の特徴である.クラウドストレージの可 用性については,現在

99.95%

や99.999999%

以上の 稼動率が報告されている.この状況に鑑みると,安全 側で近似したとしても,断片ファイルの故障率p

は1

1000程度を仮定しても十分と考えられる.クラウドス トレージが

4

台以上のとき,100

分割の場合でも回収図2 ファイル回復率の算出原理

Fig. 2 Principle of the arithmetical method for file back up.

確率は

0.9999999999

以上を達成でき,実用上,十分 に高い信頼性をもつシステムが実現できる.分割数を 変化させた場合のセキュリティレベルの一例として,ファイルデータを

30

分割し,かつ各々を30

複製した ときに,p =

15 の場合,元ファイルが回復できない確 率は,約10

−19( p

が101 の場合には10

−29)

のオーダ になる.このようにユーザがバックアップを要求する際の条 件を勘案し,サービス提供側としては,以下のような サービスメニューを設けることができる

[12]

.(

1

) サービスレベルの要求が最高度レベルのとき,通信事業者等の設定する品質基準では暗号強度を

AES

で400

ビット以上のレベルとし,回復確率を1 −10

−20 以上とする.このときは,分割数を80

,複製数を100

に決定する.(

2

) サービスレベルの要求が高度レベルのとき,通 信 事 業 者 等 の 設 定 す る 品 質 基 準 で は ,暗 号 強 度 を

AES128

ビット 以 上 の レ ベ ル と し ,回 復 確 率 を1 − 10

−19以上とする.このときは,分割数を40

, 複製数を30

に決定する.(

3

) サービスレベルが中高度レベルのとき,通信 事業者等の設定する品質基準では,暗号強度をAES128

ビット以上のレベルとし,回復確率を1 − 10

−12以上 とする.このときは,分割数を40

,複製数を20

に決 定する.例えば,暗号化されたファイルを

80

分割し,一様に ランダムに分散( 4. 2. 3

参照)

する効果は,鍵長が400

ビット程度のAES

と同等の安全性を実現することに 対応する.現在のAES

の鍵長の最大値は256

ビット であるため,本提案方式におけるファイルの暗号化・分割・再配置等を組み合わせた時系列処理により,容 易に高い安全性を達成できる.現時点で仮に

400

ビット程度以上の鍵長が不要であったとしても,

5.

で述 べるように暗号の危殆化[13]

は時間の問題であるとす る指摘もあるため,処理の複雑性や処理時間の長大化 を来たすこと無く,安全性を高められる方式を開発す る必要性がある.また合計100MB

のデータファイル を分割数20

で分割し,分割した5MB

のデータ断片 を10

複製する場合を考える.分散転送先のスマート フォンの故障率を安全側に見積もり,20%

とした場合,ファイル回復確率は

0.999998

となり,実用上は十分 な安全性を確保できる.一方,複製数m

の値を大きく すれば,ファイル回復確率は飛躍的に高まるが,所要 ネットワークリソースの増加により,保守コストは増 えるため,分割数及び複製数は,ユーザ要求条件と保 守コスト費用の双方を勘案して設定する必要がある.3.

従来のディザスタリカバリシステム ディザスタリカバリ技術は二種類の機能がある.一 つは,ディザスタが発生してもサービスを中断せず提 供し続けることを可能とする機能.もう一つは,サー ビスが一時中断するが,速やかに再構築してサービス の再開を可能とする機能である.前者は,サービスを提供する機構を多重化しつつ広 域に分散配置することで,ディザスタにより一部が欠 損しても残りの部分でサービスの継続を実現する.後 者は,サービスの再構築に必要な資源を日頃からバッ クアップ・確保しておくことで,サービス停止後に速 やかに再構築を実現する.

本論文では後者,特にソフトウェアとデータのバッ クアップとリカバリを対象とし,何等かのディザスタ が発生しない限りはリカバリ作業を実施しないと仮定 する.このようなディザスタリカバリシステムの機能 を以下に整理する.

•

重要データのスナップショット取得と保存.•

重要データの実時間複製(

レプリケーション)

•

重要データの更新ログの記録と保存ここでは,通信・移動中のセキュリティ確保,保存・

レプリケーション先でのセキュリティ確保,対象とし た災害発生時のリカバリ成功確率の向上とリカバリに 要する時間の短縮を考慮した保存・レプリケーション 先の数や場所の選定が要求される.

従来のディザスタリカバリは,セキュリティや

BCP

のコスト負担が可能な大企業を中心に活用された.古 典的には,データベースの更新ログを全てテープ媒体 に記録し,定期的にテープ媒体を地盤が安定した場所に建てられた金庫に運送・保管していた.データベー スのレプリケーションを複数の遠隔地にある専用の データセンターに作成しつつ,通信は複数の通信事業 者から借りた専用線で行う方式が一般的であった.

中小企業や個人レベルのディザスタリカバリも必要 性が高まっているが,安価ではあるもののセキュリティ 的には信頼性の面で課題の有るクラウドと,現状の計 算量的安全性に依存した暗号技術の組合わせで実現さ れるレベルに留まっている.

こ れ ら を 解 決 す る た め に ,し き い 値 秘 密 分 散 や

GRID

,クラウドを活用するディザスタリカバリ技 術が研究開発されてきた.しきい値秘密分散法に関し ては(2 , n )

あるいは(3 , n )

しきい値秘密分散(

ただし,n ≤ 7)

の分散・復元アルゴリズムを実装し,計算効率 の良いアルゴリズムを提示した実用例はある[10]

.し かしながら,数十M

バイト程度の機密文書データや ライブラリデータ等をしきい値秘密分散する技術のレ ベルに止まっている.一方,本方式では大容量のユー ザデータを暗号化・分割・分散する過程で必要となる,小容量のパラメータ

(

メタデータ)

のみを分離し,こ の小容量のメタデータは安全な通信経路を活用して 秘密分散し,データ量の大半を占めるユーザデータ は,安価なネットワークを活用して,経済性とセキュ リティを同時に達成できる.特に,大容量データを高 速暗号化後に分割・複製・分散転送する手法を適切な 順序で組み合わせることにより,重要データを広域分 散し,ディザスタ発生時のファイル回復確率を定量的 に評価した研究は,十分には行われていない状況であ る[14]

〜[17]

.更に,急速に普及しつつあるスマート フォンやデジタルサーネージのような通信機能と記憶 機能を兼ね備えた端末を積極的にディザスタリカバリ に活用することによりサービス品質の向上へ反映させ る取り組みも無かった.4.

ディザスタリカバリ技術の原理4. 1

基本アーキテクチャ本方式では,広域分散されたクラウドやスマート フォン端末群が備えるほとんど無尽蔵に近いストレー ジリソースの有効活用を考慮し,分散ネットワークと 高速暗号を活用する.一つまたは複数のデータセンタ を活用して,ユーザが秘密に保管すべきバックアップ 用ファイル情報を解読困難な状態に暗号化した後に,

ランダム分割し,その断片を複製後に異なる暗号鍵で 再暗号化する.その後,広域分散されたクラウドやス

トレージ機能をもつスマートフォン等の端末に保管す るメカニズムを活用することにより,セキュリティ強 度とファイル回復確率

(

可用性)

を同時に向上する特 性を備える.本技術はメカニズムの明確化を図るた め,HS-DRT (High Security Distribution and Rake Technology)

の呼称を使用する.本技術では,重要 データファイルに対して,暗号化前の平文に対して,毎回,異なる乱数を用いて,高速ストリーム暗号化を 行い,その後,一体化と称する空間的な撹拌を行う高 速暗号処理を行う.更に,ユーザの要求レベルに応じ て,ファイルの最適分割・複製・再暗号化を行い,冗 長化した断片ファイル群を作成する.次いで,この断 片ファイル群をネットワークに分散転送し,クラウド,

PC

,携帯,スマートフォン,ディジタルサイネージ等 の通信端末の遊休ストレージ内に分散保管する.ディザスタ発生時におけるデータ破損の場合には,

安全な場所に保管されている,前述の一連の暗号化・

分割処理に使用した時系列的に用いたパラメータ

(

以 後,“

メタデータ”

と呼称)

を活用して,元ファイルの 復号化に必要な断片データだけを効率的に回収する.この一連の処理用エンジンが本技術の核心である.断 片ファイル群を分散転送するメカニズムは,図

3

に示 すように,ユーザデータの暗号化された断片ファイル が広域分散されるクライアントノードへ転送されるト ラヒック処理過程と,秘密鍵を含むメタデータがしき い値秘密分散された監視センタへ転送されるトラヒッ ク処理過程とで構成できる.ユーザの元データファイ ルは,暗号化後に,断片ファイルに分割・複製され,更に断片ファイルはシャッフリングされ,再暗号化さ れた後にランダムに転送される.再暗号化する理由は,

同一の複製ファイルの第三者に対する識別を困難にし,

安全性を高めるためである.

図3 メタデータの監視センターへの転送原理 Fig. 3 Metadata transfer to the supervisory centers.

(

1

) 第1

の暗号化初期段階における疑似乱数による平文初期化後のスト リーム暗号処理化または

AES

等のブロック暗号を用 いた暗号化の処理.ストリーム暗号であれば,処理時 間は元データのサイズに比例する.(

2

) ファイルの一体化暗号化されたデータ全体を空間的に攪拌する処理.処 理時間は元データのサイズに比例する.

(

3

) 分割化(2)

の過程で一体化されたファイルのユーザごとに異 なるサイズへ分割する処理.処理時間は他の処理種別 と比べ,ほとんど無視し得る.(

4

) シャッフリング分割化された断片ファイルをシャッフリングし,ラン ダムに並び替える処理.実質的に再配置表の作成だけ なので,処理時間は分割数に比例する.

(

5

) 複製・再暗号化シャッフリングされ,再配置された各断片データを,

複製後,その同一性が判断できないようにするための 再暗号化処理.処理時間は元データのサイズと複製数 の積に比例する.

(

6

) ユーザデータの分散保管ユーザのデータファイルを暗号化・断片化し,異なる 場所へ分散保管する処理.

(

7

) メタデータの秘密分散保管秘密鍵を含むメタデータをしきい値秘密分散方式によ り,異なる場所へ秘密分散保管する処理.

以上の

(1)

〜(7)

がバックアップ処理の基本メカニズ ムである.(2)

のファイルの一体化の処理の前に,(1)

の第1

の暗号化によるデータのランダム化を行う理由 は,第三者が万が一,一体化後に分割化された断片化 ファイルを全て集め,元ファイルと同じ形態に並べ替 えることに偶然に成功した場合においても,当該デー タのビット列は依然として,ランダムデータ列にしか 見えず,正当な並べ替えに戻ったことを判断できない ようにするためである.当該のサービスを提供する事 業者のみがメタデータを用い,復号化に必要な断片化 ファイルの回収後の復元処理を正しく実施することが できる.処理対象のデータサイズは

(1)

〜(3)

は元データ全 体,(4)

は全ての断片ファイル,(5)

〜(7)

は個々の断 片ファイルとし,全体をパイプライン処理することで 高速処理が実現される.しかしながら,元データが主 記憶よりも大きな場合,(2)

と(3)

でパイプライン処理が不可能となり,著しい速度低下が予想される.そ のような場合,

(2)

と(3)

では,プログラムに用意さ れたバッファのサイズごとに処理を行うことで,パイ プライン処理が実現可能である.後述する一体化処理時の可逆演算の単位を

32

ビッ トとし,疑似乱数の初期設定値としては1024

〜2048

ビット程度を使用する.ソフトウェアの実行環境で使 用される疑似乱数は簡便ではあるが,物理乱数やシス テムクロック( ms

またはμs

単位)

の使用が安全性の 面からは望ましい.また,ストリーム暗号を使用する 代わりにブロック暗号を使用した場合でも,本方式の 特長が,損なわれることは全くなく,両方式の併用も 可能である.一方,一連の暗号化や分割転送の過程で 使用した暗号鍵,ファイルの分割番号,転送先のPC

のIP

アドレスやクラウド内の指定ファイル名等の,元ファイルの解読に必要となるメタデータの情報量は ユーザがバックアップすべき元データの情報量と比較 して

2

〜3

桁以上,小さいメモリ容量であることに着 目し,しきい値秘密分散保管を行い,バックアップシ ステム全体のセキュリティを向上させる必要がある.メタデータは通常はユーザデータの数百分の

1

から 数千分の1

以下で構成できるため,通信路としては安全な

IP-VPN

を活用し,大容量のユーザデータの保管にはインターネットのようなベストエフォート的で 経済的なネットワークを活用する.このように,経済 的なネットワーク上での広域分散化と並行して,メタ データをインターネットと分離した

IP

網(IP-VPN

やNGN

等)

で転送することにより,全体として経済的 でかつ安全性の高いバックアップシステムを実現でき る.将来,攻撃者の計算能力が高くなり,計算量的安 全性によって成立する公開鍵暗号等の保証ができない 場合に備えてしきい値秘密分散を行うことにより,例 えば同時に3

か所がハッキングされない限り,安全性 を担保できる方式としての運用も可能である.本方式 におけるしきい値秘密分散の適用法は4. 2

で述べる.本方式では,断片化されたデータを「どこから」「い くつ」集め,どのように「再結合」すべきかに関わる

「情報」の全てが同時に得られない限り,復号化は不 可能である.本方式は十分な「計算量的安全性」を備 えるとともに「情報理論的安全性」に比肩し得る暗号 技術に近づいた方式と考えることもできる.

5.

で詳細 を述べる.4. 2

基本となる要素技術4. 2. 1

ストリーム暗号と一体化技術の融合ファイルを安全にバックアップするための手段とし て,従来のブロック暗号方式を拡張する手段は,いず れは処理遅延時間の指数関数的な増加と所要メモリ量 の増加に耐えられない状況になると考えられる.また,

暗号のもつ安全性を計算量的な複雑さのみに依存する 従来の方式では,安全性は遅かれ早かれ,低下する暗 号の「危殆化」も論じられている.

本方式では,従来とは異なる方法で,安全性を確保 できる手段を用い,守るべきデータ容量が大規模化し た場合でも高速暗号処理が実現でき,かつ高いセキュ リティを容易に実現する.従来は,十分な評価がなさ れていなかった高速ストリーム暗号に新たな息吹を与 え,飛躍的に高速化が進むネットワーク環境とクラウ ド環境とを,効果的に融合させることにより,セキュ リティを飛躍的に向上できる可能性がある.ブロック 暗号もストリーム暗号方式も,どちらも単独で,

1

対1

通信を対象とした,ファイルデータの暗号化を実現す るが,暗号処理の高速化に関しては原理的にストリー ム暗号が有利である.しかしながら,ストリーム暗号 は,一般的には,他の処理技術との併用を実施しない 限りは,安全性の面での課題がある.この理由は,従 来のストリーム暗号では,1

対1

通信を前提として,秘密鍵をシードとして擬似乱数を生成し,平文と排他 的論理和

(XOR: Exclusive OR)

演算などの単純な可 逆演算を行うことにより,暗号文を生成するからであ る[18]

.復号化時には,同じシードから擬似乱数を生 成し,暗号文に対してXOR

演算を行うことにより,元の平文を容易に復元することができる.ここで,

1

対不特定多数通信を前提としてストリーム暗号を適用 する場合,演算種別はXOR

演算に限らず,2

進の加 減算等の可逆演算を行い,これらの演算を任意に組み 合わせ,かつ秘密鍵を毎回,変更する操作と,任意に 当該のデータを,不特定多数の受信者に向けて分割転 送する操作を組み合わせることにより,暗号強度を飛 躍的に高められる性質に着目する必要がある.なお,1

対不特定多数通信による分散転送を前提として,スト リーム暗号を適用する場合,ファイル一体化(ファイ ル内容の空間的な攪拌)と組み合わせることが有効で ある.この際に,一体化されたファイルをランダム分 割とシャッフリング処理により,分割データの受信先 を随時変更できる処理を組み合わせて,不特定多数の 受信者に転送することにより,文献[18]

で述べられる図4 ファイルデータの空間的撹拌アルゴリズム Fig. 4 Algorithm of spatial random scrambling.

ような再同期攻撃も適用できず,暗号強度を飛躍的に 高められる.ストリーム暗号は単純なビットストリー ム単位で発生するデータ処理に適しているので,処理 時間はブロック暗号に比べて極めて短く,リアルタイ ムで高速暗号化・復号化を実現できる特徴を備える.

したがって,ストリーム暗号特有の「解読」容易性の 課題を解決すれば十分なセキュリティを保証できる安 全で高速な暗号方式として甦らせることができる.課 題解決の鍵としては,「高速暗号化」

+

「ファイル一体 化(

空間的な撹拌処理)

」+

「分割」+

「シャッフリン グ」+

「複製」+

「再暗号化」+

「ランダム分散」と いう一連の処理を適切な順番で組み合わせる手法が有 効である.図4

にファイル一体化(

ファイルの空間的 撹拌)

のアルゴリズムを示す.一体化の基本処理は以 下のとおりである.n

要素の配列x [0 . . . n − 1]

におい て,最初はx[1] = x[1] + x[0]

,次にx[2] = x[2] + x[1]

というように順に小さい番号の要素から一つ大きな番 号の要素に可逆演算(図

4

の場合は排他的論理和)をx [ n − 1] = x [ n − 1] + x [ n − 2]

まで繰り返す.そして 最後にx [0] = x [0] + x [ n − 1]

の演算をすることで,n

要素の配列の内容を配列全体に広く撹拌する.一体化 処理をよりセキュアーにするためには,この基本処理 の繰り返し回数,可逆演算の種類,可逆演算を行う要 素間の距離等を可変にする方法があげられる.一連の時系列で実施される暗号化及びネットワーク 分散のメカニズムを用いて,元データに関わる必要な 断片データを全て集めた後に,復号化することが必要 となる.このメカニズムを知らない第三者が,復号化 に要する計算時間は,元データ容量の増加に伴い,分 割数を増すことにより,従来のブロック暗号方式に比

べて飛躍的に大きくできる.従来方式との本質的な違 いは,ファイルデータのサイズに応じて,分割数を大 きくすることにより,容易に安全性を高められるとい う特徴に加え,むしろ,分割数や分散保管場所などの 情報を秘密にすることにより,従来とは異なる概念で 可用性と安全性を同時に確保できることである.従来 の暗号では暗号鍵の長さを増やすことにより暗号強度 を高めていたが,本技術ではファイル分割数を増やし,

ランダムに分散化を図ることにより,計算量的な検証,

すなわち

(

ファイル分割数)!

個の総あたり組み合わせ 検証に加え,ファイル保存場所の探索処理が新たにが 必要となる.しかしながら,第三者が偶然に元の組み 合わせ配置に一致した状態を実現した場合において も,そのビット配列は,第三者にとっては相変わらず,ランダムビット情報配列に過ぎず,復号化の進み具合 を検証するための判断基準が存在しない特質をもって いる.この理由は,正しく組み合わせられたファイル データのビット列でさえ既にファイル全体に渡り,空 間的な攪拌

(

一体化)

処理が施されているためである.4. 2. 2

メタデータと秘密分散技術先に述べたように,メタデータは

HS-DRT

の暗号 化,一体化,分割,シャッフリング,複製,転送先情報 等の多くの情報で構成される.そのため,一般的な暗 号の暗号鍵と比較すると多くの情報量が必要になる.メタデータの一般的な構成と所要情報量の概算を表

1

に示す.表

1

から分かるように,メタデータの大きさはバッ クアップする重要データの大きさではなく,サービス レベルに応じて設定した分割数( m )

や冗長数( n )

に よって決まり,特に複製後の断片ごとの情報(Informa- tion associated with m × n fragmented files)

部分が メタデータのほとんどを占める.ファイル情報(File name . . . )

のサイズは,送信先のFQDN

に,送信先で のパス名とファイル名やキー名をURL

形式で表現し たものを想定しているので,可変長で長くなる可能性 がある.このファイル情報を含めた複製後の断片ごと の情報の合計を概算で2K[Byte]

と仮定すると,2.

で 例示した3

個のサービスレベルごとに計算すれば,最 高レベルで16M[Byte] ( 2 K [ Byte ] × 80 × 100)

,高 度レベルで4M[Byte] ( 2 K [ Byte ] × 40 × 50)

,中高 度レベルで1.6M[Byte] ( 2K[Byte] × 40 × 20)

とな る.数十G[Byte]

以上のデータをバックアップする場 合には,メタデータの情報量は元データの3

桁以上小 さい値であることが分かる.HS-DRT

の特長は,重要表1 メタデータの構成と情報量 Table 1 Metadata format and its information

amount.

Information associated with bytes

the original file (maximum)

Hash value 64

File name (including URL information) variable

First encryption key 512

ID number regarding with the spatial 4 scrambling algorithm

Number of spatial scrambling processing 4

Number of the divided files (m) 4

Number of the replicated files (n) 4

Fragments size table 8×m

Fragments sequence table 4×m

Information associated with bytes

m×nfragmented files (maximum)

Sequential number (after shuffling) 4

Second encryption key 512

Hash value (After second encryption) 64

Destination IP address 16

Destination ID 8

Transmission Date 8

File name (including URL information) variable

データ

(

容量X[Byte])

を,第三者が解読不可能な分割 数(m) ×

複製数(n)

個の断片(

総容量n × X[Byte])

と,数M[Byte]

程度の重要なメータデータに分けて転 送・保存することである.断片データはクラウドに分 散保管し,重要なメタデータだけを専用線やIP-VPN

等を用いて信頼度の非常に高い複数のサーバに分散保 管する.このメタデータの保管においては,単純な複 製ではなく,( k, n )

しきい値秘密分散法を適用した後,n

箇所の管理主体や地理的位置の異なるサーバに保管 することが望ましい[12], [19]

.例えば,メタデータに

(3, 5)

しきい値秘密分散法を 適用して,5

台の地理的,管理的に異なるサーバに当 該データを格納する場合を想定する.何等かのディザ スタにより,5

台中2

台迄のサーバに格納された情報 が失なわれても,残りの3

台の情報からメタデータは 復元可能である.また,悪意をもった者がメタデータ を盗もうとしても,管理主体の異なるサーバを3

台以 上クラックしない限り,メタデータが漏洩することは ない.4. 2. 3

シャッフリング技術A.

フィッシャー・イェーツ・シャッフル一様分布性を証明できるシャッフリングアルゴリズ ムはフィッシャー・イェーツ・シャッフル

(

以下FYS

と 呼称する) [20], [21]

以外は知られていない.ランダム サンプリングを実現するための有効なシャッフリングアルゴリズムとして,文献

[21]

では,FYS

のみが紹 介されている.この状況に鑑み,断片データをランダ ムに再配置するためのアルゴリズムとして,FYS

を用 いることとした.ディザスタリカバリシステムは,一体化したデータ を分割することにより強力な秘匿性能を実現できる.

分割したデータを事実上,ランダムに再配置できる 根拠は以下のとおりである.再配置暗号

[22], [23]

では 多くの再配置表を鍵として使用するため,FYS

が一様 分布する事実は重要な意味をもつ.FYS

を何度か繰り 返し使用すると,通常の擬似乱数生成器を用いた場合 でも偏りのない再配置表の集合を得ることができる.以下に示すように

“ FYS ”

アルゴリズムを定義し,RNG

は適当な擬似乱数生成器とする.procedure FYS;

begin

for i := m-1 downto 1 do begin

a:=RNG mod (i+1);

b:=x[i];

x[i]:=x[a];

x[a]:=b;

end;

end;

配列

x[i]

を上記のアルゴリズムで攪拌したとき配 列に格納されている値を確率変数X

m,iと記す.X

m,iは以下の定理

1

に示すように一様分布に従う.定 理

1.

任意の

i, j ∈ Ω = { 0 , 1 , 2 , · · · , m − 1 }

に対して,P ( X

m,i= j ) = 1

m

が成立する.(

証明は付録1 )

B.

擬似乱数生成器の統計的な検定本節で

FYS

に基づく擬似乱数生成器の統計的な検 定を以下のように定義する.m

を配列x[i]

の長さと し,n

を試行の回数,r

をFYS

の繰り返し回数とし,f

i,j( i, j = 0 , 1 , 2 , · · · , m − 1)

を2

次元度数分布表の 配列とする.ここでf

i,j= N ( X

m,i= j )

とする.た だし,N

は度数を示す.定理

1

によって,適合度の検定の帰無仮説を以下の ように設定することができる.H

0(m, n, r, j)

c:

度数分布表f

·,jは一様分布に従う.H

0(m, n, r, i)

r:

度数分布表f

i,· は一様分布に従う.また次のように対立仮説を設定することができる.

表2 帰無仮説が棄却される度数分布表の個数 Table 2 The number of rejected hypotheses

frequency tables.

RNG r h1c h1r RNG r h1c h1r

ANG 1 192 128 MT 1 13 16

ANG 2 13 16 MT 2 14 11

ANG 3 15 13 MT 3 15 11

H

1(m, n, r, j)

c:

度数分布表f

·,j は一様分布に従わ ない.H

1(m, n, r, i)

r:

度数分布表f

i,· は一様分布に従わ ない.大きな

m

に対して検定統計量はχ

2分布に従うの で,あるf

·,j はH

0cを満たし,また別のあるf

·,jはH

1cを満たすであろう.そこでH

1cを満たすj

を数え 上げる.すなわちh

1cをH

1(m, n, r, j)

cが成立する場 合の数,h

1rをH

1( m, n, r, i )

r が成立する場合の数と 定義する.C. RNG

の適合度の検定こ こ で 二 つ の 擬 似 乱 数 生 成 器 を 検 定 す る .一 つは

Additive number generator (

以下ANG

と呼 称 す る) [24]

,も う 一 つ はMersenne twister (

以 下MT) [25]

である.こ こ で 検 定 の 有 意 水 準 を

0.05

と し ,m = 256, n = 1000000

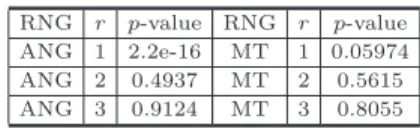

とする.検定結果は表2

のようになった.表

2

は乱数の一様性を検定した結果ではなく,FYS

が扱う再配置表の一様分布性を検定した結果である.FYS

は真正乱数を用いたとき再配置表の一様分布を 保証している(

定理1)

.ここで,m = 256

,検定の有 意水準が0 . 05

であるので,真正乱数の場合でもh

1c,h

1rの値は12.8(= 256 × 0.05)

程度が期待できる.こ の結果,ANG

は表2

において1

ラウンド( r = 1)

では真正乱数でない(192 > 128 12 . 8)

と判定さ れた.また,ANG

であっても,複数ラウンドの繰り 返しを行った場合には真正乱数と判定できた.一方,MT

は表2

では1

ラウンドから真正乱数と判定され た(11 ∼ 16 12 . 8)

.実際,1

回のFYS

をadditive

generator

で生成された擬似乱数で攪拌した再配置表 は偏りが検出された.しかしr > 1

と設定した場合 には,additive generator

で攪拌した場合でも,偏り のない再配置表が得られた.256 × 0.05 = 12.8

なの で,表2

で得られた結果から,r > 1

の場合はどち らの擬似乱数生成器でも検定統計量は自由度255

のχ

2分布に従うはずである.再配置表が一様分布すれ ば,この検定統計量は自由度255

のχ

2 分布に従う表3 χ2分布することの検定

Table 3 Test of goodness of fit forχ2statitics.

RNG r p-value RNG r p-value ANG 1 2.2e-16 MT 1 0.05974 ANG 2 0.4937 MT 2 0.5615 ANG 3 0.9124 MT 3 0.8055

はずである.適合度の検定をした結果,表

3

を得た.ここで,

m = 256, n = 1000000

である.表3

にお いては,1

ラウンドでは真正乱数とは認め難い傾向が 現れたが,複数ラウンドシャッフルすると,この状態 は改善された.表3

はH

1( m, n, r, j )

cの場合である.H

1( m, n, r, i )

rの場合も同様の結果が得られた.表2

, 表3

で得られた検定結果からANG

よりMT

のほう が真正乱数に近いと言える.これらの結果から,

FYS

を複数回実行した場合,ANG

を用いても再配置表は一様分布していることが 検証できたと考えられる.以上述べたように,

DRT

では,データを分割し,ラ ンダムに配布する方式を採用しているが,一様分布に 従うスケジュールが容易に実現可能である根拠を得る ことができた.5.

計算量的安全性インターネットを含めた多様な通信サービスを受け られる環境で安全性を定義する場合には,攻撃者が目 標を達成するために必要とされる処理量や計算時間に 関する適切な仮定を設ける必要がある.解読を行うた めの計算時間を推定したときに,現時点から将来に渡 り十分長い,解読困難な時間を保証できる性能は,計 算量的安全性とよばれる.現時点で,計算量的安全性 が保証されている場合でも,計算機の急速な進展によ り,暗号解読がなされ,攻撃者の目標が達成される可 能性がある.例えばインターネット上のセキュリティ システムで広く利用されている

RSA

暗号,ElGamal

暗号,だ円曲線暗号などの暗号方式の多くは,データ を保存する通信宛先は,一つ若しくは特定の複数の宛 先に限られている.すなわち,データの保存場所の特 定は容易である場合が多く,解読されるべき情報の探 索は,極めて容易であると考えられる.近い将来,量 子コンピュータに適した高速分析アルゴリズムや計算 処理能力の急速な向上により,素因数分解や離散対数 問題が短時間では解けないことを,唯一の拠り所とす る従来の方式は,計算量的安全性が保証できなくなる可能性があると考えられる.例えば,量子コンピュー タ上で実行される

Grover

のアルゴリズム[26]

を用い ると,古典的なコンピュータでO ( N )

の計算量となる 計算をO ( √

N )

で計算できる.そのため,標準的に使 用されている暗号の多くは安全とは言えなくなる.ま た128

ビットの鍵を使用するAES

は64

ビットの鍵空 間の全数探索程度の計算量で破ることが可能になる.これに対して本方式では,ファイルを安全にバック アップするために,複数の処理を時系列的に組み合わ せて一体化し,分割し,ネットワーク上に,広域分散 転送する「

1

対不特定多数」通信の方式を採用してい る.広域分散転送のランダム性は既に述べたシャッフ リング技術によっている.この技術が情報取得を試み る攻撃者に対して,どの程度,安全となるかを計算量 的安全性の観点から以下に明確化する[22]

.データを

n

分割し,ランダムに再配置後に分散する 場合を考える.古典的コンピュータに対してN = n!

が,極めて安全である場合に,本方式を適用し,

2 n

分 割後においてGrover

のアルゴリズムで攻撃したとし ても量子コンピュータでの計算量は,十分に大きいこ とを保証することができる.その理由は次式(2)

が成 り立つからである.(∀n ∈ N) : n! <

(2n)! (2)

このことは,本方式ではデータを

n = 100

分割すれ ば古典的コンピュータの攻撃(100! 10

158通りの組 み合せ探索)

に対して安全であるところを,2 n = 200

分割することで,量子コンピュータによる攻撃を更に 無効化できることを意味している.ここで,本方式に おける分割数を2

倍にした場合の処理時間は元の処理 時間と比してほとんど増加しないことに着目する必要 がある.一方,だ円曲線暗号やAES

の場合は鍵長を2

倍にすると処理時間は2

倍以上に増加する.一方,情報理論的に安全な暗号方式が,次世代の暗 号方式として注目されている.しかしながら,この暗 号方式は,一般には安全に記録するための必要情報量 が膨大になるという欠点がある.例えば,情報量的に 安全な共通鍵暗号方式を実現するためには,メッセー ジ長と同じ長さの鍵が必要なことを想定すると,現実 的な暗号方式とは言い難い.本方式は上述したように,

天文学的に長い時間をかけても,ほとんど第三者から の攻撃は成功し得ない特質を備えることができ,従来 方式と比べてより高い計算量的安全性を有する方式の 候補と考えられる.

6.

性 能 評 価6. 1

基本性能の評価本節では,広域分散ネットワーク制御技術のうち,

暗号化と一体化並びに分割とシャッフリングの部分の 基本性能の評価結果を示す.

性能評価を行ったテストベンチを図

5

に示す.このテ ストベンチは,2

台のPC

,4

台のNetwork Attached Storage (NAS)

と1000base-T

のネットワークで構成 されている.2

台のPC

,PC1

とPC2

の基本仕様を 表4

に示す.PC1

に実装したHS-DRT encryption core module

は三つのスレッドと,スレッド間のデー タの受け渡しをする四つのバッファから構成されてい る.三つのスレッドは,受信スレッド,暗号化スレッ ド,送信スレッドの異なる役割をもつ.暗号化スレッ ドは,図5

に示すように,第1

の暗号化(1st encryp- tion)

,一体化(spatial scrambling)

,分割・シャッフ リング(fragmentation & shuffling)

,再暗号化(2nd encryption)

の処理を行う.データの複製は本テスト ベンチでは行っていない.暗号化には総当たり攻撃に 強くなるように乱数の初期値が4096

ビットのANG

によるストリーム暗号を用い,再配置表を作るための 乱数生成は速度性能を重視し初期値が32

ビットのMT (mt19937ar)

を用い,シャッフリングはFYS

を3

回 繰り返すようにプログラムを実装した.このHS-DRT encryption core module

はストリーム暗号を用い,圧 縮処理は行わないため,データのパターンに依存す る性能の変化は生じない.PC2

に実装したdummy data generator

もMT

を用いて乱数データを高速生 成し,1000base-T

の実効帯域112[MB/sec]

で,PC1

にデータを供給する.NAS

を4

台使用し,2

台ずつ 別々に1000base-T

の回線に収容する理由は,PC2

か らPC1

に供給される112[MB/sec]

と同等以上の帯域 でPC2

からNAS

に送信できるようにし,PC2

からNAS

への書き込み速度が112[MB/sec]

を下回らない ようにするためである.ネットワークへ

(

から)

の送(

受)

信もHDD

への読 み書きも行わず,純粋な暗号化・一体化・分割・シャッフ リング性能に限定して測定した結果,168[MB/sec]

の 処理性能を検証した.この結果,2GHz

程度以上のク ロック周波数で動作するプロセッサを用いれば完全に ソフトウェアベースで動作させた場合でも1000base-T

の帯域以上の性能が発揮できることを検証した.次に,

PC2

で生成したランダムデータをネットワー図5 基本性能評価用テストベンチ Fig. 5 The performance evaluation bench.

表4 テストベンチのPC基本仕様 Table 4 PC specifications in the test environment.

PC1 PC2

Encryption core module Data generator CPU Core2 Quad Q6600 2.40GHz Memory 8GB (DDR2-800) 4GB (DDR2-800)

RAID 0 (striping)

HDD SATA 500GB SATA 250GB

7200rpm x4 7200rpm

OS Fedora 12 x86 64 Fedora 10 i686

ク経由で

PC1

が受信し,暗号化・一体化・分割・シャッ フリングをした後,4

台のNAS

にftp

プロトコルで 送信した場合の性能を述べる.PC1

が1GB

のデータ を処理するのに必要なレイテンシは13.2[

秒]

であり,3

スレッドでの並列処理により,データ処理性能のス ループットは112[MB/sec]

を確保できることを検証 した[27]

.6. 2

パブリッククラウドの活用パブリッククラウドを利用し,

DRT

エンジンを実 装したアプライアンス(特定の用途向けに設計,開発 された機器)であるDRTbox (

後述)

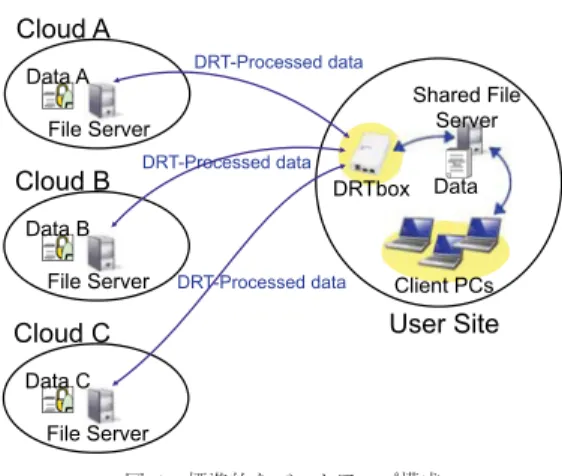

を利用したバッ クアップシステム構成を図6

に示す.本システムの性 能評価を,図6

の測定実験用のタイムチャートを用い て行った結果を以下に述べる.DRTbox

内で処理すべきデータを認識したタイミングを図

7

の左端のファイルに示す.制御部はバック図6 標準的なバックアップ構成

Fig. 6 Standard file backup system configuration.

図7 HS-DRTデータ処理タイミング

Fig. 7 Timing chart of processing data of HS-DRT.

アップ対象となるファイルを検出後直ちに,クラウド 上の認証サーバへ端末自体の認証とサービスの認証及 びアクセス権限の確認を行う.これが図

7

の区間A

(

Section A

)に示す部分である.区間A

は,サーバ 上の認証(Authentication

)と承認(Authorization

) の動作及びネットワークの通信時間(

図7

でAuth Servers

とDRTbox Controller

の間の4

本の矢印の 部分)

からなる.端末,サービス,権限の認証及び承認 動作と並行し,DRTBox

は処理対象データ用のプリプ ロセスを起動するが,このプロセスは,通常は短時間 処理のため,上述の区間A

の時間が経過する前に完了 する.承認と認証が完了すると,実際のデータを複数 のクラウドへアップロードする動作が発生する.図7

に示す区間B

(Section B

)が,あらかじめ規定され たサイズで分割されたデータを送信する間隔である.表5 区間A内の処理時間(クラウド) Table 5 Processing time in the section A (Cloud).

Section A Authenti Authori Network -cation -zation (estimation) 282[msec] 98[msec] 62[msec] 122[msec]

表6 区間Bの経過時間と処理効率(クラウド) Table 6 Processing time of the section B and

efficiency (Cloud).

Section B CPU usage duration

min 44[msec] 20%

max 240[msec] 100%

average 144[msec] 68%

図

7

は,DRTbox

を異なる三つのクラウドサーバ へ分散してデータ保管を行う場合を示し,DRTbox

内 部ではそれぞれの送信ルーチンが個別のプロセスとし て同時に動作する.マルチコアの場合にはこれらのプ ロセスが適切に分散するよう実装(

コーディング)

し ているが,DRTbox

はシングルコアであるため,マル チコア実装時に期待できる性能改善は達成できていな い.なお,測定のために実コードにOS

が用意する時 刻測定関数gettimeofday()

を埋め込み,測定の際に はスワップとNTP

機能を停止している.表5

に区間A

における認証及び承認の測定平均値を示す.ネット ワークの通信時間(表5

のNetwork

)は,実測値では なく,区間A

全体の時間から認証と承認にかかった時 間を引いた値である.認証と承認のための時間につい てはクラウドサーバの処理性能と処理の混雑度合に依 存し,ネットワークについても契約するクラウドサービス及び

DRTbox

が存在するクライアント環境に依存する.これらの測定値は,一般的な光回線と比較的 廉価で信頼できるプロバイダが提供するクラウドサー ビスの環境における一例である.

表

6

に区間B

の測定値を示す.この試験測定では,分割された断片ファイルのサイズは

1Mbyte

を想定し た.実際の内部処理では1Mbyte

を更に64Kbyte

単 位で16

個に分割して処理を行うが,複数クラウドで 同期を確認し,他クラウドへの転送処理を行う単位は1Mbyte

である.三つのクラウドサーバへデータを送信する三つのプ ロセスについては,

TCP

セッションでの往復遅延が あるため,レート制御を行わない場合でも待ち合わせ 遅延時間が発生する.これらの遅延時間を適切にスケ ジューリング処理することにより,三つの単一のプロセス処理とほぼ同じ時間で送信処理を完了させること ができる.クラウド

B

とクラウドC

への送信処理を ダミーとして実際に送信を行わない場合でも,全体の 処理時間に大きな差異は見られなかった.CPU

の平 均使用率が約70%

程度であることを考慮すると,送信 レートの支配的要素はネットワーク性能であることが 判る.6. 3

オンプレミスでの運用表

7

に6. 2

のシステムをオンプレミスで運用した場 合の測定結果を示す.具体的にはクラウド上に設置し た保管サーバと同様のサーバをローカルに設置し,バッ クアップ先としてこのサーバ群を活用した.DRTbox

とローカルのサーバ間は1Gb/s

のイーサネット回線 で接続した状態で測定を行った.認証と承認に要する処理時間がクラウドを用いた場 合の測定値と比較して小さな値を示しているが,この 理由はオンプレミスによる優位性ではなく,むしろ,

クラウド上の仮想マシンよりも高い処理性能のサーバ をオンプレミスで使用したことによる.

一方,ネットワークの通信時間

(Network)

は611(=

2

122

)

程度に短縮されている.しかしながら区間A

の 部分は,各ファイルごとに一度発生するのみの処理で あるため,例えば10MByte

以上のファイルサイズの 場合には,全体の転送レートに対して大きな影響とは ならないことがわかる.一方,表

8

に示すデータ転送では,転送レートが1.5

倍ほどに改善された.この理由はクラウド上では ネットワークの遅延が支配的であったのに対し,オン プレミスでの運用では,DRTbox

の性能が支配的に なったためである.クラウドでの測定ではCPU

の平表7 区間A内の処理時間(オンプレミス) Table 7 Processing time of the section A

(on-premises).

Section A Authenti Authori Network -cation -zation (estimation) 42[msec] 18[msec] 22[msec] 2[msec]

表8 区間Bの経過時間と処理効率(オンプレミス) Table 8 Processing time of Section B and efficiency

(on-premises).

Section B CPU usage duration

min 92[msec] 92%

max 118[msec] 100%

average 102[msec] 97%

均使用率が約

68%

であったが,オンプレミスではほ ぼ100%

に近くになり,CPU

が限界まで動作してい ることを示している.クラウドでの測定結果である 表6

とオンプレミスでの測定結果と表8

を比較する と,SectionB

の所要時間の最小値はオンプレミスの 測定結果が,クラウドでの測定結果よりも大きな値と なっている.この理由としては,サーバ側のリソース 割り当て最適化による影響が考えられる.ファイルの 分割アップロードにはHTTPS

プロトコルを用いたが,オンプレミス上の

HTTP

サーバは,特にメモリのリ ソースを消費しないように実装できたのに対し,クラ ウド上のサーバは高速な仮想マシンを共有しているた め,測定中に処理負荷の状態に応じて,通常はCPU

リソースやI/O

バッファ(キャッシュ)の割り当てが 変化する.したがって,他の仮想マシンの負荷が軽い 場合や,ディスクI/O

に余裕がある場合には,保証性 能を上回る速度で,通信データの保存が実施される場 合があると考えられる.メモリリソースは仮想マシン 単位で管理され,平均的には契約された性能の範囲を 考えれば良い.しかしながら,前述の条件等を考慮す ると,短い時間単位では変動する場合もあり,これら の要因が遅延時間の変動に影響したものと考えられる.7.

実用化システム例上述したデータをバックアップするための仕組みを

「ファイル金庫システム」として実用化した.「ファイ ル金庫システム」には,

PC

にインストールするアプ リケーションベースのシステム,インストール不要な アプライアンスベースのシステム,アプライアンスを 仮想環境に適用した仮想マシンベースのシステムの三 つがある.各々のシステムの概要を以下に述べる.7. 1

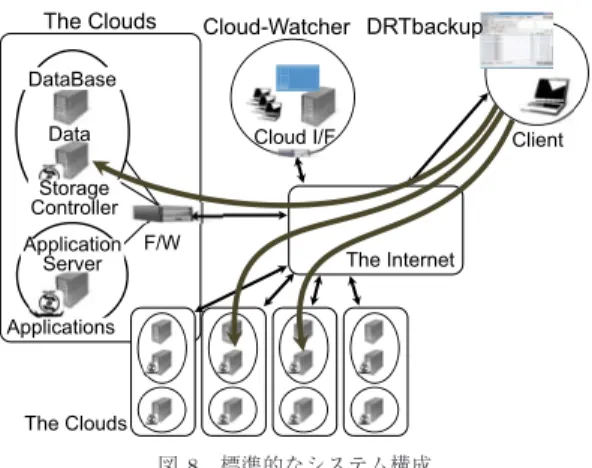

アプリケーションベースのシステムPC

にインストールし,PC

内のデータをフォルダ 単位でバックアップできる「DRTbackup

」は最初にDRT

エンジンを実装したソフトウェア製品である.DRTbackup

はWindows PC

とMacintosh

で稼働す るアプリケーションであり,指定したフォルダを監視 し,追加や更新のあったファイルをHS-DRT

で分散 して複数のクラウドサーバへ保管する機能を備える.図

8

はファイル保管を行う場合の標準的な構成であ り,複数のクラウドを監視エンジン(Cloud-Watcher)

により管理し,ファイル保管の都度,適切なクラウド サーバを選択できる機能を具備する.ユーザが設定を行うのはバックアップの対象となる

図8 標準的なシステム構成

Fig. 8 Standard structure of HS-DRT system.

フォルダの指定と,除外するファイルの指定,及びバッ クアップのインターバル等である.一度インストール して初期設定を行えば,利用者は重要データを当該 フォルダにコピーするだけで,クラウドへのバックアッ プがバックグラウンドで自動的に行われる.

7. 2

アプライアンスベースのシステム「

DRTbackup

」を活用する際,共有サーバのバック アップでは以下のような課題がある.ユーザのPC

に ソフトウェアのインストールが必要となること,イン ストールしたPC

が起動していない場合にバックアッ プが実施されないこと,更に専用機でないため動作保 証が困難なことである.これらの課題を解決するため,既存の

PC

へのイン ストール作業を不要とし,かつ24

時間稼働を実現し た低消費電力のアプライアンスとして「DRTbox

」を 開発した.「DRTbox

」は既存のユーザ環境を変更せず,追加デバイスとして設置でき,

24

時間連続してバック アップ処理を継続できる.DRTbox

にはARM

ベースのCPU

をもつ(株)ぷ らっとホーム製のOpenBlocksA6

を活用した.OS

にDebian

系のLinux

を採用しているため,後述する仮 想マシンベースのシステムとソースコードの共通化を 図ることができた.7. 3

仮想マシンベースのシステムDRTbox

の設計と並行して,当該装置の物理的な障害に対応するため,仮想マシン上に

DRT

エンジンを 実装した「DRTVM

」を開発した.DRTVM

は仮想マ シン上のLinux

にインストールできるDRT

エンジン であり,インストールの難易度は伴うものの,十分な 知識を有するサイト管理者のもとでは,ハードウェアの信頼性を重視せずに済むため,導入コストの低減化 が可能である.

仮想マシン上のアプリケーションは

DRTbox

で動 作するエンジンとほぼ同一のものである.DRTbox

の ファームウェアはLinux

のため,仮想マシンも同様に

Linux

のベースイメージを利用し,リソースの共通化を図った.

DRTbox

に実装したCPU

はシングル コアであるため,仮想マシンへの移植にあたってはマ ルチコアを検出し,処理を効果的に分散する機能を追 加した.仮想マシンへの実装に当たっては,Amazon

社のAWS (EC2)

とNTT Communications

社のBiz

Hosting

などの複数のクラウドサービスを活用して,本提案の暗号処理用エンジンを搭載した.

なお,一般的にはクラウド側からローカル環境の サーバにアクセスすることは推奨されないが,仮にこ の方法が実施できる場合は,プライベートクラウド環 境を構築するか,またはローカル環境側からクラウ ドサーバ側へセキュアーな接続を確立し,当該のアプ リケーションサービスを駆動することにより,クラウ

ド上の

HS-DRT

エンジンがオンプレミスのファイルサーバを監視することが可能になる.

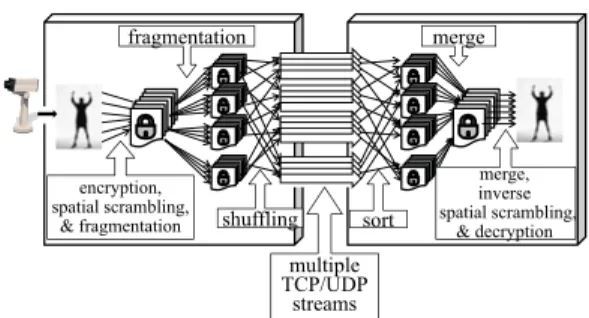

7. 4

秘密動画伝送システム前節まで述べたシステムは,

HS-DRT

技術をデータ の保管及び回復処理に適用したものであるが,新たな 応用システムとして,秘密動画伝送システムの開発を 進めている.図

9

に,HS-DRT

技術を動画伝送に応用した秘密 動画伝送システムの構成例を示す.送信側(

図9

の左 側)

は,動画像データを適切なバイト数ごと,例えばGOP (Group Of Pictures)

ごとに,暗号化,一体化,分割

(

図9

では4

分割)

を行う.更に各分割画像の断 片を再分割(

図9

では4

分割)

することで,多数の動 画像データの断片(

図9

では16

断片)

を生成する.こ れらの多数の断片を,断片数と同数のTCP/UDP

ス トリームを用いて送信を行う.このとき,断片とスト リームの対応関係や送信処理の順序は,シャッフリン グテーブルを用いて攪拌する.受信側(

図9

の右側)

は,断片をシャッフリングテーブルを用いて並べ替え て結合した後,逆一体化と復号処理を行って,元の動 画像データを復元する.この実装では,秘密鍵やシャッ フリングテーブルを含むメタデータは,送信側と受信 側で同一のものを共有する必要がある.配信する動画情報に対して,より強固なセキュリ ティを必要とするニーズが増えつつあり,複数のサー