近年,歌声合成技術が注目を集めている.ニコニコ動 画などの動画サイトでは VOCALOID に代表される歌声合 成ソフトウェアを使い,アマチュアのクリエータが作詞・ 作曲したオリジナル曲があふれている.そして特に若い 年代がそういった楽曲を好んで聞いている.音楽の新し い楽しみ方が生まれつつあるともいえよう.本稿では筆 者が開発に携わった歌声合成ソフトウェア VOCALOID を 簡単に紹介し,そしてどのようにして開発を行ってきた かについて述べる.

歌声合成ソフトウェア VOCALOID

VOCALOIDは歌詞と音符を入力するだけで,人間の声に 近い歌声を合成するソフトウェアである.その構成を図 1 に示す(実際のソフトウェアでは,音楽制作がしやすいよ うな各種機能も実装されているが,簡単のためここでは基 本的な機能に絞って説明する). ユーザは(a)VOCALOID Editor を用いて音符と歌詞 を入力する.そして実際の人間の声から集めた歌声の素片 (断片)を集めた(b)歌声ライブラリから合成に必要な素 片を選択し,(c)合成エンジンで接続することで歌声とし て出力する. 当初から,歌声ライブラリはヤマハとライセンス契約 を結んだパートナー企業が開発し,ヤマハがソフトウェア (VOCALOID Editor と合成エンジン)をライセンスすると いう形でビジネスを行ってきたが,2011 年に発売開始と なった VOCALOID3 から,ソフトウェアについてはヤマ ハから直接販売し,パートナー企業は歌声ライブラリを単 体で販売するというビジネス形態になっている. 以下,図中の各構成要素について説明する. (a)VOCALOID Editor 音符と歌詞の入力の際には,歌詞の音節と音符との対 応関係を分かりやすく表示し,編集できるようになって いる必要がある.VOCALOID Editor のスクリーンショッ トを図 2 に示す. 音符はいわゆる「ピアノロール」になっている.高さ 方向が鍵盤上の各音に対応し,横方向で音符の開始タイ ミングと音符の終了タイミングを表す.五線譜で表示及 び入力ができれば特に初心者には分かりやすいかもしれ ないが,歌声の場合,音符の長さや前後の音符との接続 状況が重要なため,それらが分かりやすく表示されるピ アノロールを採用している. 歌詞は対象となる言語で通常用いられる書き文字で入 力するのが良いとは限らない.例えば,日本語の場合は 例えば「あの女」と書いて「あのひと」と読ませるなど, 歌詞の実際の発音にはばらつきがある.しかし,だから といってユーザに発音記号の直接入力を強いるわけには ヤマハ株式会社剣持秀紀

Hideki Kenmochi

歌声合成ソフトウェア

VOCALOID の開発

(a)VOCALOID Editor (c)合成エンジン 合成用 管理情報 素片選択 接続 (b)歌声 ライブラリ 歌声 音符・歌詞 図 1 VOCALOID 構成図 図 2 VOCALOID Editorま え が き

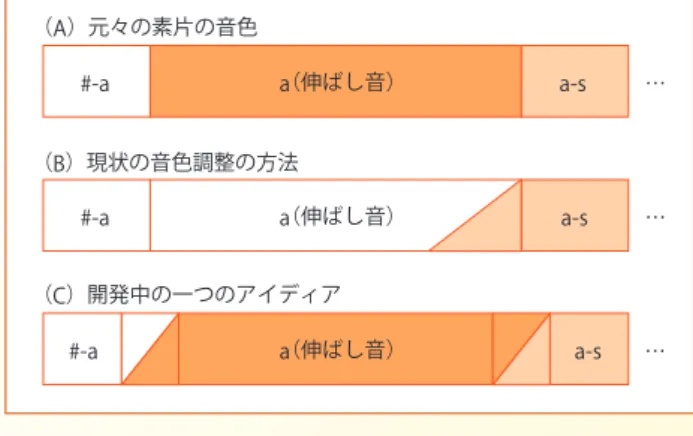

いかない.そこで書き文字の入力として許容範囲と思わ れる平仮名,片仮名及びローマ字を使用している.中国 語についてはピンイン,韓国語についてはハングル入力 に対応している.これらの入力では表せない細かな発音 上の差(例えば日本語における母音の無声化など)を表 現するために,ユーザが発音記号を直接操作できるよう になっている.英語については,日本語の平仮名に相当 するものが存在しないので,通常の書き文字を入力とし て,内蔵の発音及び音節区切りの辞書を用いて発音記号 に変換する.ただし,同じ綴りで発音が違うような単語(例 えば“read”の原形と過去形)については一つの読みだ けを採用し,ユーザが発音記号を直接操作することで対 応するようになっている. 音符と歌詞以外にも,様々なパラメータ(例えば,ダ イナミクスやピッチ(音の高さ)の細かな変化など)を 時変的にコントロールできるようになっている. (b)歌声ライブラリ 歌声ライブラリは,実際の人間の歌声から取り出した 素片をまとめたものである.素片は C(子音)-V(母音), V-Cそして V(母音の伸ばし音)を基本としている(言語 によってはC-Cという素片も用いる).例えば「アサ(a-sa)」 という歌詞の歌声の場合,#-a,a(伸ばし音),a-s,s-a a(伸 ばし音),a-#という素片が用いられる(ただし#は無音 を表す).母音の伸ばし音を持っているところが歌声合成 ならではの特徴である. 歌声ライブラリの開発に当たっては,対象とする言語 で可能性のある全ての C-V,V-C,C-C という素片を集め なければならない.できるだけ効率的に品質の良い素片 を録音するために,特別に設計した楽譜を使用する.録 音時間は収録するピッチの数などにもよるが,日本語の 場合でも少なくとも 2 ~ 3 時間は必要である. 録音は音素セグメンテーション(どこからどこまでが どの音素かを区切る作業)を行った後,どの部分を使用 するかを決める.この作業は半自動化されているが,最 終的には人間の目と耳で綿密にチェックする必要がある. 日本語の場合,この処理は 3 か月程度かかる. (c)合成エンジン (a)VOCALOID Editor で指定された歌詞と音符に従 い,(b)歌声ライブラリから適宜素片を取り出し,接続 して歌声にするのが合成エンジンの役割である.もちろ ん,単に波形をペタペタと貼り付けただけでは歌にはな らない.それは,歌声ライブラリ中の素片のピッチと楽 譜で指定されるピッチが違うことの他に,素片の境界で の音色の微妙な違いがノイズとして聞かれるからである. 例えば,前述の「アサ(a-sa)という歌詞を例に取ると,#-a の最後の部分の音色と a(伸ばし音)の最初の部分の音色 が違うと,いくらピッチを合わせ込んでも音色の違いが ノイズとして聞こえることになる.つまり素片を接続す る際には,ピッチを変換すると同時に,素片の境界部分 での音色の違いをなくすような工夫が必要となる. VOCALOIDでは,この一連の処理を周波数ドメインで 行っている.処理のブロック図を図 3 に示す. 図 3 での処理を簡単に説明する.素片中の波形データ に対して FFT を行う.音符で指定されるピッチと素片の ある時点のピッチ(あらかじめ解析しておく)を比較し, ピッチの変換量を求め,それに従って周波数軸上でスケー リングすることでピッチ変換を行う.また , 倍音に相当す るスペクトル上のピークの強さを調整することで音色の 合わせ込みを行う. 音色は,先ほどの「アサ」の例では,#-a の最後の部 分の音色を a(伸ばし音)の区間でもずっと適用し,その 最後で a-s の最初の音色に向けて補間していくことで,そ れぞれの時点での音色を求めている(図 4).伸ばし音 a については,素片の音色自体は用いずに,そこに含まれ るピッチや音色の微妙な揺らぎを加算することで,人間 の声に近づけるようにしている. Waveform FFT Peak Marking Sample Pitch (Pre-analyzed) Pitch conversion rate Scaling IFFT & Windowing &Overlapping Amplitude Modification

STFT: short-time Fourier transform

Target Pitch

(from Score) SynthesisOutput STFT

STFT

Spectral Envelope

図 3 ピッチ変換と音色の調整

#-a a(伸ばし音) a-s … (A)元々の素片の音色

(B)調整後の音色

#-a a(伸ばし音) a-s … 補間

るためのソフトウェア)で音符を打ち込み,外部ハード ウェア音源に MIDI 信号を送り,外部音源を鳴らして制作 を行うことが一般的になっていた.商業音楽でもこのよう にいわゆる「打込み」で作られた音楽が大半を占めるよう になってきていた.一方,コンピュータの CPU は 1999 年に発表された Pentium Ⅲが主流であり,クロックも Coppermineコアによってようやく 1 GHz を達成したとこ ろだった.こうしたコンピュータの性能の発達により,外 部音源を使わずにソフトウェアの形で音源を構成すること (ソフトウェアシンセサイザ)も普及し始めていた.1999 年に NemeSys Music Technology 社から発表された Giga Samplerは,それまでハードウェアが主流だったサンプラ (楽器として用いるために音を取り込み,再生するための 機器)さえもパーソナルコンピュータ(以下 PC)上のソ フトウェアとして実現したものである.このように,音楽 制作環境がプロ,アマチュアを問わず,外部音源を使用す る環境から,PC のみで音楽制作環境を実現できるように なりつつあったのが 2000 年頃である. しかし,このような状況であったのにもかかわらず, 唯一「打込み」とは無縁の楽器があった.それが歌声で ある.商業音楽でも,メインボーカルやバックコーラス にかかわらず,歌声だけはスタジオで歌手が歌い,それ を収録したものを使用するという状況が続いていた.ア マチュアの音楽制作でも,歌だけはコンピュータでの打 込みではなく,マイクを使って制作者自身が歌うか,知 人に頼んで歌ってもらうかしないと自分の作品を完成さ せることができなかったわけである.このような状況を 鑑みて,将来必ず歌声も「打込み」の対象となる時代が 来るであろうと考え,開発を始めた. ただし,もちろん VOCALOID 以前にも歌声合成技術 は存在していた.1961 年にベル研究所の Kelly らは, IBM704を使って音声合成技術を開発し(2),そのデモン ストレーションとして,Daisy Bell という歌を歌わせた. これが世界初のコンピュータによる合成歌唱だといわれ ている* 1.その後も,音声合成技術の発達とともに,歌 声合成についても様々なものが提案されてきた.その中 には商品化されたものもある.例えば,ヤマハも 1997 年 に PLG-100SG(3)という歌声合成機能を持った音源ボー このような方法を採用している理由は「合成の仕組み を考える」で詳しく述べる.

VOCALOID 開発ストーリー

■ VOCALOID の広がり 2007年にクリプトン・フューチャー・メディア株式会 社が企画・開発し発売された「初音ミク」(歌声合成シス テムとして VOCALOID2 を利用)は,発売されるや否や これを用いた楽曲が「ニコニコ動画」などの動画サイト に次々と投稿されるようになった.ごく初期にはいわゆ るカバー曲(既存の楽曲を歌わせるもの)も多かったが, しだいにクリエータが自ら作詞・作曲を行ったオリジナ ル曲も増えてきた.人気の楽曲は大手レコード会社から CDとして発売されたり,カラオケとして配信されるよう になってきている.そういった楽曲の中にはオリコンで 1位になるようなものも出てきている.今や,日本の音 楽シーンは合成歌唱音声を抜きには考えられない状況と なっている. 2012年春にアスキー総研が女子中学生・女子高校生を 対象に行った調査(1)によると,女子中学生の 71%,女子 高校生の 61%が「VOCALOID を知っている」と答え,女 子中学生の 54%,女子高校生の 44%が「VOCALOID の 曲が『とても好き』もしくは『好き』」と答えている.今 後この世代が消費の中心となったときに,日本の音楽シー ンはどのようになっているだろうか. この動きの中で特筆すべきは,従来のようにプロの作 詞・作曲家が作った楽曲コンテンツを消費者が楽しむの ではなく,もともとアマチュアだったクリエータ(ある いは現在もアマチュアのクリエータ)が作った楽曲コン テンツを消費者が楽しんでいるという構図である.音楽 の提供のされ方,消費のされ方そのものが変化している ともいえる. ただし,筆者が開発を始めた当時にこのような状況は 全く予想していなかった.そういう意味でも最近の動き は驚きの連続である.「開発を始めた背景」では,どのよ うにしてこのソフトウェア・技術を開発してきたかにつ いて振り返ってみたい. ■開発を始めた背景 VOCALOIDの開発は 2000 年に開始した.当時の状況 を振り返ってみたい.音楽制作の現場では,コンピュータ でシーケンサのソフトウェア(演奏データを自動再生す * 1 ちなみに, VOCALOID の開発中の社内のプロジェクト名は, この Kelly らの成果に敬意を表し, “Daisy プロジェクト”とし ていた. VOCALOID という名前が決まったのは 2003 年 2 月の 発表の直前である.ド(MIDI 音源に挿入して拡張音源として使用する)を発 表している. しかしながら,過去の歌声合成技術(及びその応用商品) は,楽曲中のいわば「飛び道具」として使用される場合 はあったが,音楽制作で広く使われるまでには至ってい なかった.VOCALOID の開発にあたっては,「音楽制作 の現場で使って頂けること」ということを目標に掲げた. この目標をブレークダウンし,以下の三つの要件が必要 であると考えた. (a )了解性:歌詞が聞き取れること.少なくともあら かじめ歌詞が与えられれば聞き分けられること. (b )自然性:伸ばし音でもブザー音のようにはならず, できるだけ人間の歌声に近いこと. (c )操作性:歌詞と音符が関連付けられた形で効率的 に入力できる環境. もちろん,現在もこれらの要件は完全に達成されてい るとは言い難い.今後も追求していかなければならない と考えている. ■合成の仕組みを考える 開発を始めた当初は,歌声を合成する手法について何 もないところから考えなければならなかった.開発はス ペインの Pompeu Fabra 大学(バルセロナ)との共同研 究の一環として行われた.一般に「共同研究」というと 特に日本の企業の場合は委託研究に近い場合も多いが, この共同研究は役割分担を決めて協力しながら一つのも のを開発していくという真の意味での共同研究であった. もともと Pompeu Fabra 大学が周波数領域での信号処理 に関する経験があったため,基本的な処理は周波数ドメ インの処理で行うことにして,実際に歌声を合成すると ころとアプリケーションとしての実装は,お互いに知恵 を絞って考えた. もちろん,物理モデルによる歌声合成も考えなかった わけではなかった.しかし物理モデルは夢があるが,実 用レベルのクオリティと計算量の歌声合成システムに至 る見通しが少なくとも当時は全く予想できなかったため, こちらは早々と断念した.また,最近のテキスト音声合 成の世界で一般的となっている大規模コーパスを利用し た合成手法も当時広まりつつあったが,歌声の場合は音 符の長さと高さと歌詞の組合せは無限にあり得るので, 大規模コーパスを用いた手法は非現実的だと考えられた (今でもそう考えている).結果的にテキスト音声合成で 古くから用いられている C-V,V-C といった diphone(素 片音と音のつながり部分)を接続する方法でいくことに 決まった. 簡単な素片を接続する方法でいくことになったが,実際 に素片をどのように接続していったら高品質の歌声を作り 出せるかは,まさに試行錯誤の連続であり,「(c)合成エン ジン」で述べた方法にたどり着くまでにはかなりの時間を 要した.音色の調整方法での試行錯誤の一例を紹介する. 「歌声合成ソフトウェア VOCALOID」で説明したよ うに,現状では図 4(B)のように,#-a という素片の最 後の音色を伸ばし音のところで引き伸ばし,伸ばし音の 最後のところで次の a-s という素片の最初の音色に補間を 行っている.開発中には様々な方法を試みたが,例えば 図 5 の(C)のような方法,つまり#-a という素片の区間 内から a という伸ばし音に,また a という伸ばし音から a-sという素片の区間内にかけて音色を合わせ込む方法を 試したことがある.しかしこの方法では,歌詞の了解度 があまり良くないという結果になった.これを基に,人 間はどうやら音そのものを聞いているのではなく,変化 する部分を聞いているのではないか,という仮説を立て た.その仮説に従うと,変化するエッセンスが入った部 分(音素と音素の変化する部分)は,できるだけそのま ま用い,別の部分でつじつま合わせを行えば良いという ことになり,最終的に図 5(B)の現行の手法に行き着いた. この手法では,#-a,a-s という音素遷移部分の音色の変 化は,元々の素片に含まれるものがそのまま用いられる だけでなく,素片の接続時の音色の不整合も起こらない. もちろんこれが best な方法ではないかもしれないが,試 行錯誤の末にたどり着いた better な方法である. 歌声の合成においては,タイミング合わせも重要な問題 である.例えば簡単のために,「サササ」という歌詞を考え,

#-a a(伸ばし音) a-s … (A)元々の素片の音色

(B)現状の音色調整の方法

#-a a(伸ばし音) a-s …

#-a a(伸ばし音) a-s … (C)開発中の一つのアイディア

「サ」一つが音符一つに割り当てられている状態を考えてみ る.このときに,音符の開始時に合わせて「サ」という音 節の発音(すなわち[s]という子音の発音)を開始すると, 遅れて聞こえる.これは人間が歌の場合に音節の母音の開 始位置を音符の開始位置として認識しているからである. 特に[s]などの無声摩擦音の場合はその長さが 200 ms 程 度まで長くなる場合もあり,大きな問題となる.図 6 のよ うに,「サ」の母音開始位置が音符の開始位置に合うように タイミング合わせを行わなければならない. ところがこれを現状の MIDI の枠組みの中で表現する ことは非常に難しい.なぜならば,MIDI では音符の開始 位置は Note On メッセージ* 2として,音符の発音を開 始すべき時刻にリアルタイムで入力機器側(例えばキー ボードなど)から音源側に送られてくることを想定して いるからである.もし通常の MIDI で実装しようとすると, Note Onメッセージが送られてきたら,時間を遡って子 音の発音を開始するという因果律に反することを行わな ければならない.これを解決するために,あらかじめ作 成しておいた楽曲データ(シーケンス)を再生するとい う用途に限定し,Note On/Off による発音タイミングコ ントロールは諦め,Note On/Off に相当するものも含め, 全てのイベントを NRPN(Non Registered Parametric Number)で表現し,先送りすることにした.すなわち, 先送り時間 D を決めておき(例えば 500 ms),音符に相 当する NRPN メッセージが到着してから D 後にその音符 の開始位置が来る(すなわち D 後に母音の開始位置が来 る.子音はそれよりも前に発音を開始する)というよう に内部で制御するようにしている(図 7.もちろんユーザ はほとんどこのことは意識する必要はない.合成エンジ ン内部の処理の話である). もちろん,代替案としては,内部的に合成エンジンに あらかじめ音符情報を全て渡しておいて合成するという 方法も考えられる.しかし,他の音楽制作ツール(シー ケンサや DAW(Digital Audio Workstation)など)との 連携や親和性を考えたときに,シーケンサ部分(演奏デー タの送信部分)と音源部分を論理的に分離し,演奏デー タの伝達に何らかの形で MIDI を使用し,リアルタイムに 合成できるようにした方が良いと考えたため,このよう な実装になっている. このように各種試行錯誤を繰り返し,合成する仕組み(ア ルゴリズム)を考えると同時に,入力のための GUI(つま り VOCALOID Editor)のプロトタイプの開発を行った. 2003年 2 月に,ニュースリリースで対外的に公にして, 同年 3 月の Frankfurt Musikmesse(世界最大の楽器ショ ウ)で技術発表を行った. ■ 製品発表後の展開∼現在まで 2004年に最初の製品がイギリスの Zero-G 社から販売さ れた.日本ではクリプトン・フューチャー・メディア株式 会社が日本語ライブラリの「MEIKO」を発売した.一部の 新しいもの好きのクリエータには使って頂いたが,残念な がら当初の目標である「音楽制作の現場で使って頂けるこ と」は達成されたとはいえない状況だった.しかし 2007 年に VOCALOID2 を用いたクリプトン・フューチャー・メ ディア株式会社の「初音ミク」が発売された以降の状況は 「VOCALOIDの広がり」で述べたとおりである. その後も合成品質やユーザインタフェースの改良を重 ね,2011 年には VOCALOID3 という新バージョンを発表 した.更に合成品質がリアルになっただけでなく,音楽 制作の効率を上げられるような各種機能と,初心者でも 簡単に始められるような工夫を行っている. その一方で,VOCALOID の合成の仕組みを PC ソフト ウェアだけでなく,別のプラットホームにも応用する試 みも行っている. 2010年には VOCALOID の合成エンジンを iOS に移植 し,iVOCALOID という商品名で発売している.iPhone/ iPadで音符と歌詞を入力するだけでなく,リズムパター サ サ サ s a ♪ ♪ ♪ s a s a s a s a s a 䚛OK 䚛NG 図 6 タイミング合わせ t NRPN メッセージ 「今から D 後に『サ』という 歌詞で音符を発音せよ」 a s D 図 7 NRPN による実装 * 2 MIDI では音楽の演奏情報が楽器や音源にメッセージとして送 られる.Note On メッセージは「音を鳴らす命令」であり,音符 の開始位置(すなわち鍵盤楽器ではキーを押したタイミング)を 示す.「音を止める命令」は Note Off である.

剣持秀紀 1967 生まれ.1993 京大大学院工学研究 科電気工学第二修士了,同年,ヤマハ株 式会社入社.1996 エル・アンド・エイチ・ ジャパン株式会社出向.1999 ヤマハ株式 会社に復職.以降,歌声を含む音声信号 処理に関する研究開発に従事. ンだけではあるが簡単な伴奏も付けられるようになって いる(図 8).また,ピッチの動きや音節の長さを自由自 在にコントロールできるという VOCALOID 合成エンジン の特質を生かし,しゃべり声に近い簡単なフレーズ(例 えば「おはよー」や「かんぱーい」等)を作って遊ぶア プリケーション VocaloWitter も発売している.作ったコ ンテンツは YouTube に投稿したり,その内容を Twitter でつぶやいたりという SNS 連携機能も備えられている. 一 方 で,VOCALOID の 合 成 エ ン ジ ン を サ ー バ 上 で 動 作 さ せ, ネ ッ ト 上 で の サ ー ビ ス と し て 提 供 す る NetVOCALOIDと呼ばれるサービスも行っている.クラ イアント(PC やスマートフォン等)で簡単に歌詞や音符 を入れるだけで,合成処理にかかる負荷を気にすること なく歌声合成を使用することができる.これまでに,様々 な企業のキャンペーンサイト等で実際に用いられている. 例えば,五・七・五の音節数で詩を作って入力すると, キャンペーンソングのメロディーに合わせて替え歌とし て歌ってくれるようなサービスである.

これからの歌声合成

―新しい音楽と新しい楽器― 「歌声合成ソフトウェア VOCALOID」で述べたように, 歌声合成によって新しい音楽が生まれ,新しいスタイル の音楽制作・消費活動が行われるようになってきている. VOCALOIDを用いて作られ,動画サイトに上げられた楽 曲を聞いてみると,玉石混交ながらも光るものも多い. 歌声合成技術によって,「歌を含む楽曲は必ず歌手が必要」 という制約から解き放たれ,まるで楽器のように自由に 歌詞やメロディーを作っているクリエータが多い.筆者 は特に楽曲の歌詞に注目している.今までの商業音楽で はあり得なかったような斬新な歌詞の楽曲も多い.いわ ゆる「中二病」的な,あまりの「青臭さ」ために人間の 歌手が歌うのを躊躇するような歌であっても,ひとたび 合成音声によって歌声として聞かれると,それは新しい 表現としてリスナーの心に突き刺さり,愛聴されていく うちに新しい表現として許容されていく.「VOCALOID の広がり」で述べたように特に若い世代が「ボカロ曲 (VOCALOID を使った楽曲)」を好んで聞いているという 背景には,商業音楽には存在しない新しい表現が魅力的 だからということもあるのではないか. 音楽の歴史を振り返ると,過去にエレキギターやシン セサイザが登場したときにも同様の動きがあった.従来 の音楽側からは「これは音楽ではない」といわれつつも 多くの人の共感を得て一般化していったように,歌声合 成技術も音楽の中の一ジャンルとして,また音楽制作の 上での定番のツールとなっていくのではないかと,期待 を込めながら予想をしている.これからも新しい音楽に よって多くの人々が豊かな音楽的な経験を味わえるよう に,微力ながら筆者も尽力していきたい. 文 献 ( 1 ) http://research.ascii.jp/elem/000/000/066/66458/ ( 2 ) J. Kelly and C. Lochbaum,“Speech Synthesis,” Proc.4th Int. Congress on Acoustics, pp. 1-4, 1962.

( 3 ) http://jp.yamaha.com/product_archive/ music-production/plg100-sg/ 図 8 iVOCALOID PC スマートフォン 各種クライアント インターネット フロントエンド サーバ NetVOCALOID サーバ 完成した楽曲コンテンツ 歌詞など 歌詞・音符 合成結果 歌詞とメロディーの割当, 伴奏付加など 古池や 蛙飛び込む 水の音 ♪古池や… 図 9 NetVOCALOID サービス