特集●サーベイ論文

創作過程の分類に基づく自動音楽生成研究のサーベイ

松原 正樹 深山 覚 奥村 健太 寺村 佳子 大村 英史

橋田 光代 北原 鉄朗

本論文では創作過程の視点に基づいて自動音楽生成に関するサーベイを行う.Shneiderman の創作過程の枠組みに よれば,創作過程は Collect, Relate, Create, Donate の 4 つのフェーズからなる.計算機システム,ユーザ,シス テム設計者の 3 者全体を 1 つのトータルシステムと捉えると,創作においてそれぞれの要素が 4 つのフェーズをど う分担するか考えることができる.我々は既存の自動作曲・自動編曲・演奏表情付けシステムに対してこの観点から 分析を行った.分類結果より各システムにおける 4 つのフェーズの共通項や差異を比較することができるようにな り,音楽生成研究の進むべき方向性を示すことができた.

In this paper, we present a survey of automatic music generation systems from the viewpoint of creative process framework. According to Shneiderman’s framework, a creative process consists of four phases: Col-lect, Relate, Create, and Donate. Regarding a system, a user, and a system designer as a total system, we investigate which of them achieves each of the four phases and how in existing music generation systems, especially music composition, arrangement, and performance rendering systems. Our investigation shows common and different parts in the four phases among the systems, which implied a direction to future music generation studies.

A Survey of Automatic Music Generation Systems based on Creative Process Framework.

Masaki Matsubara, 慶應義塾大学大学院理工学研究科, Graduate School of Science and Technology, Keio University.

Satoru Fukayama, 東京大学大学院情報理工学系研究科, Graduate School of Information Science and Tech-nology, the University of Tokyo.

Kenta Okumura, 名 古 屋 工業 大 学大 学 院 工学 研 究科, Graduate School of Engineering, Nagoya Institute of Technology.

Keiko Teramura, 京都大学大学院情報学研究科, Gradu-ate School of Informatics, Kyoto University. Hidefumi Ohmura, JST, ERATO, 岡ノ谷情動情報プ

ロジェクト, Japan Science Technology Agency, ER-ATO, Okanoya Emotional Information Project. Mitsuyo Hashida, 相愛大学音楽学部, School of Music,

Soai University.

Tetsuro Kitahara, 日本大学文理学部, College of Hu-manities and Sciences, Nihon University.

コンピュータソフトウェア, Vol.30, No.1 (2013), pp.101–118. [解説論文] 2012 年 3 月 31 日受付.

1 はじめに

音楽に関わる行為は,一般に作編曲・演奏・鑑賞の 3つに分けることができる.作編曲は演奏する内容を 想起し創出する行為,演奏はそれを聴取者に音として 届ける行為,鑑賞はそれを聴取する行為である.本論 文ではこれらのうち作編曲と演奏を総称して「音楽創 作」と呼ぶ†1.そうした音楽創作活動を人間を介さず に機械によって自動化する試み(以下「音楽生成」と 称する)は,古くはオルゴールから始まり研究対象と して取り上げられてきた.音楽生成が研究される背景 には,(1)ゲームや映像作品のBGMへの利用など, 新規楽曲への需要があり,作編曲や演奏の人的コスト の削減が求められていること,(2)音楽創作行為の形 式的なモデル化を通じて創作行為の解明や理解が進 †1 演奏は創作に含まないという考えも存在するが,通 常,演奏時には演奏者が独自の演奏表情を付加し,演 奏表情の付加という行為が作編曲と共通した特徴を持 つため,本論文では便宜上「創作」という言葉を作編 曲と演奏の総称として用いる.むと期待されていること,などが存在する. 音楽を創作するという行為が才能のある者が無か ら何かを閃くような神秘的な行為なのかというと,必 ずしもそうではない.様々な作品を鑑賞して,その特 徴を自分なりに解釈し,その解釈に独自の表現を加 えて再構成するといった方法で音楽を創作する場合 も十分に考えられる.この場合,創作行為は,(1)既 存の作品の鑑賞・体験・学習,(2)当該作品の分析・ 解釈,(3)独自の表現の探求,(4)当該表現の外在化, の4つのフェーズからなると解釈できる.実際,創 作行為をこのようなフェーズに分けて解釈できるこ とはすでに知られており,例えば,Shneidermanは 創作行為を,(i) Collect,(ii) Relate,(iii) Create,

(iv) Donateの4つのフェーズに分けて議論しており, この4つのフェーズは前述の(1)∼(4)に対応してい る[73].音楽創作を情報処理過程と考え,その自動化 の現状と今後の展開を把握する上でこの考え方は有 効である. 本論文ではこれまでの音楽生成システムについて, ユーザやシステム設計者もシステムの一部とみな した上で,システムがどのようにCollect,Relate, Create,Donate (以下「C-R-C-D」と称する)を実現 しているかを俯瞰する.従来にも自動作曲システムや 演奏生成システムについてサーベイを行った論文はい くつか存在した[14] [27] [50] [96]が,この論点から考 察したものは存在しなかった. 以下,まず2章で音楽生成研究の調査の視点につ いて述べる.3章では自動作曲についてC-R-C-Dの 観点からこれまでの研究を俯瞰する.4章では自動編 曲について,5章では演奏表情付けについて3章と同 様に俯瞰する.6章では自動作編曲と演奏表情付けに ついて共通点と相違点を述べたあと,これからの自動 音楽生成研究が進むべき道について,著者らの考えを 記す.最後に7章でまとめをする.

2 研究調査の視点

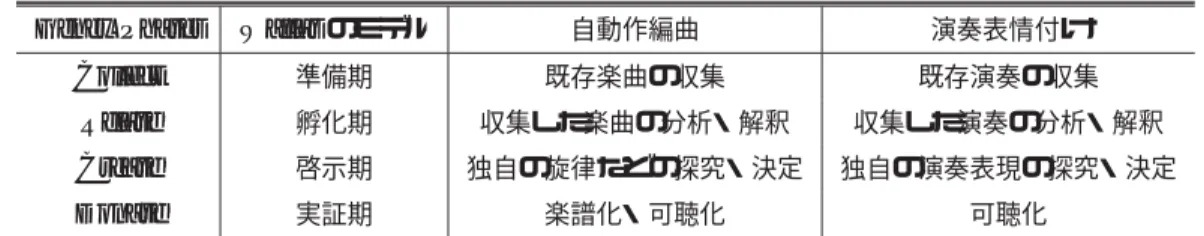

本節では音楽生成研究の調査のための視点につい て述べる. 2. 1 音楽生成タスクの分類 作編曲と演奏は不可分な一連の行為として行われ てきたが,16世紀の印刷技術と五線譜の発明をきっ かけに楽譜が普及したことにより,特に西洋音楽にお いて,作編曲と演奏を分けて考えることができるよう になった[100].ジャズの即興演奏や通奏低音のリア ライズのように,旋律や和音を作りながら演奏する行 為も存在するが,これは作編曲と演奏を同時に行って いると解釈できる. 計算機が発明されてからは,作編曲や演奏を自動化 し代替する研究がなされるようになった. 作編曲の自動化の研究は1959年に計算機によって 「イリアック組曲」[45]が初めて作曲されてから広まっ た.この要因は他の芸術分野に比べて,音楽における 楽譜という離散的な表現形式が情報処理と親和性が 高いからであろう.ユーザが歌詞や曲調などの入力を もとに確率モデルに基づいて楽曲を生成するシステ ム(例えば [36])や,メロディや伴奏など既存の楽曲 を編曲するシステム(例えば[118])など,目的別に多 様なアプローチで研究が行われてきた.本論文では, 便宜上,作編曲システムを作曲システムと編曲システ ムに分けて考える.歌詞や曲調などの入力をもとに楽 曲を生成するシステムを作曲システムと呼び,メロ ディや伴奏など音楽的な要素を入力としてそれを加工 して楽曲を生成するシステムを編曲システムと呼ぶ. 一方で,演奏の自動化(演奏生成)の試みは計算機 が誕生する以前からなされており,18世紀末のオル ゴールを始め,19世紀以降も演奏生成のための装置 は継続して開発された[11] [53].しかし,それらが備 えていたのは主に発音機構のみで,発音タイミング や音の強弱などの楽譜とのずれ(演奏表情)を自動的 に調整する機構はなかった.その後,1980年代に入 りMIDI(Music Instrument Digital Interface)が提 案されると,発音タイミングや音の強弱などのコン トロール情報を異なる機器間でやりとりできるよう になった.これにより,発音タイミングや音の強弱な どの演奏情報を決定する部分(演奏表情付けと呼ぶ) を,物理的な発音機構を制御したり電子的に楽音を合 成して音を出す部分(楽音合成と呼ぶ)から分離でき るようになった[79].楽音合成はすでにPCM音源な表 1 創作過程の分類と自動音楽生成との関係

Genex Phases Wallasのモデル 自動作編曲 演奏表情付け

Collect 準備期 既存楽曲の収集 既存演奏の収集 Relate 孵化期 収集した楽曲の分析・解釈 収集した演奏の分析・解釈 Create 啓示期 独自の旋律などの探究・決定 独自の演奏表現の探究・決定 Donate 実証期 楽譜化・可聴化 可聴化 図 1 Genex Phases(Shneiderman 2000) ど技術として確立されており実用段階に来ているが, 演奏表情付けは多様なアプローチで研究が行われて いる [50]. 2. 2 創作過程の分類 1章で述べたように人間の創作行為には様々な作品 を鑑賞して,その特徴を自分なりに解釈し,その解釈 に独自の表現を加えて再構成するといった側面が存 在する.そのような創作過程を説明したものとして Wallasの4つの過程(準備期,孵化期,啓示期,実 証期)[91]や,ShneidermanのGenex Phases[73]が 挙げられる.Genex Phasesは計算機による人間の創 作支援という観点からWallasのモデルを改良し再定 義したものであるといえ,図1に示すように4つの フェーズから構成されている. 以下に各フェーズについてShneidermanの一般的 な創作活動における定義を述べる. Collect: ライブラリやWeb上などにある既存の 作品から学ぶ.作品やデータの数が多い場合は検 索や順序付け,可視化による整理など必要な処理 を施して作品やデータにあたる. Relate: 同僚や指導者に相談し,データから特 徴を捉え自分なりの解釈や創作の方向性を見い だす. Create: 創作のための解を探究し,方針を決定 する. Donate: 実際に作品を創作し外在化させ,ライ ブラリやWeb上に普及させる. Shneidermanの定義では各段階は必ずしも順次的 に行うわけではなく,直前やそれ以前の段階へ戻って 反芻を行うのを認めている.またC-R-C-Dの4段階 はループ構造を取っており,創作の最終段階である Donateの結果が次の新しい創作におけるCollectに 貢献している. 作編曲や演奏の行為の過程とShneidermanや Wal-lasのモデルとの関係性を表1に示す.これによる と,作編曲や演奏の前に手本となる既存の事例を集 め(Collect),そこからルールや特徴を分析し解釈を 見いだす(Relate)フェーズが存在する.一方,実際 の作編曲や演奏には,楽曲や演奏表現を頭の中で想起 するフェーズ(Create)とそれを楽譜化・可聴化(演 奏や再生)して外在化するフェーズ(Donate)に分け られる.Donateは,頭の中に描いた構想が狙い通り かどうか聴いて判断するフェーズであり,必要に応じ て前のフェーズに戻ることになる. 2. 3 システム,ユーザ,システム設計者の 3者における創作過程の分担 通常,音楽生成システムについて議論するときに は,何らかのデータが入力されてしかるべきデータが

出力されるまでの一連の計算機処理について議論す ることが多い.本論文では,計算機システムのみなら ず,ユーザ,さらにはシステム設計者をも含めて,こ の3者全体をトータルシステムとしてとらえて議論を すすめることとする.つまり,単にC-R-C-Dのどの フェーズを自動化するかではなく,システム,ユーザ, 設計者がC-R-C-Dをどう分担するかという観点で議 論する.こう見ることで,C-R-C-Dの特定のフェー ズが自動化されていない例に対して,それをユーザ が行っているのか,あらかじめシステム設計者が行っ た結果をハードコーディングしているのかを区別する ことができる.

3 自動作曲

本節では自動作曲技術をC-R-C-Dの枠組みから概 観する. 3. 1 自動作曲システムの用途と要件 自動作曲システムには主に次の3点の用途が存在 すると考えられる. 用途(1) 作曲技術を持たない一般のユーザが,手 軽に新規楽曲を得るために使用する. 用途(2) システム設計者が作曲家であり,システ ム設計者自身が,自分には困難な表現を探求する ために使用する. 用途(3) システム設計者以外の作曲技術を持つ者 が,他者などからの要求に合った楽曲を手間をか けずに得るために使用する. 用途(1)は,誰でも簡単に楽曲を生成できることを 目指したシステムにおける典型的な用途である.用途 (2)は,人手だと膨大な手間や時間のかかる表現や, 自身が慣れない表現,もしくは計算機ならではの新規 的な表現を探求するなどが考えられる.用途(3)は, 商業的な場面で大量の楽曲を短期間で用意しなけれ ばならない場合などが考えられる. これらの用途に応じて,次に挙げる3つの要件の うち,どれが重要視されるかが異なる. 要件(A) 新規な音楽を創出できること 要件(B) 聴衆に馴染みのある音楽スタイルを踏 襲していること 要件(C) ユーザの制作意図を反映できること 用途(1)のように一般ユーザを対象とする場合には 要件(B)が重要視され,用途(2)のように作曲技術を 持つ人がユーザである場合はむしろ要件(A)が重要 視されると考えられる.つまり,用途(1)の場合には 生成される楽曲の新規性よりも,作曲技術を持たない ユーザに代わって音楽として不自然でないものを生成 する必要があるため,要件(A)より(B)が重視され る.一方,用途(2)の場合には,楽曲が特定の音楽ス タイルを踏襲しているかどうかはユーザ自身の音楽 能力をもって判断できることが多いため,むしろ自身 では実現困難な新規的表現を実現できるかどうかと いう要件(A)が重要である. また,用途(3)のように,想定されているユーザが システム設計者以外の者であり,作るべき楽曲の性質 がある程度決められている場合,要件(C)が最重要 になると考えられる.用途(1)のように想定ユーザが 一般人の場合,必ずしもユーザにはっきりした制作意 図を持っていない可能性がある.用途(2)のようにシ ステム設計者自身がユーザとなる場合には,制作意図 はシステム設計時に組み込むことができる.一方,用 途(3)では制作意図がある程度明確にあり,それをシ ステム設計時に組み込むことができないからである. このように作曲システムはその用途と要件につい て多様性があるため,以下サーベイをするにあたり, 3つの要件のどれに着眼しているかという観点から分 類を行う.この分類をもとに,各々の作曲システムに おいてGenex Phasesの各過程を「システム」「ユー ザ」「システム設計者」の3者がどのように役割分担 しているかについて分析する. 3. 2 要件(A)に対する工夫 楽曲の新規性を指向するシステムでは,それぞれ生 成したい楽曲の性質に応じて,計算機のために形式化 された作曲技法が用いられている.計算機による楽 曲生成の黎明期に,Stochastic Music Program[98],Project 1 [52],POD[89] があり,これらはいずれ もこの目的のためのシステムである[68].Stochastic Music Programは楽音を確率的に扱う作曲理論に基 づいて設計されている[98].Project 1は決定論的な

技法と偶然性に基づいた技法の折衷を実現するため に設計されている[52].PODでは時間–周波数平面 において確率分布に従って楽音を散布するという確率 的手法に加え,楽音合成機能をも持っている[89]. 新規的な作風は数理的な手法に基づいて創出が試 みられていることが多い.具体的には,マルコフモデ ル[2],カオス[66],進化論的計算[88],セル・オート マトン[9],フラクタル [7]などを用いてシステム設 計が行われている[68]. 楽曲の新規性を指向するシステムでは,システム 設計者は,既存の楽曲や音楽理論の特徴をよく理解 し,その特徴を逸脱するようにシステムを設計する. これは,既存曲を収集(Collect)してその特徴を抽出 (Relate)した結果から外れるようにCreateしている 点が特徴的で,3. 3で述べるシステムが,Collectおよ びRelateの結果にできるだけ適合するようにCreate しているのとは対照的である. 同様の試みは,セリエリズムなど,計算機が普及す る前から試行されていた[68].しかし,例えば音高の 出現確率が一様分布になるように音を選ぶなど,煩 雑な計算が強いられるため,計算機の登場によってこ のようなアプローチが広く試されるようになった.実 際,Stochastic Music Pro [98]のように多数の音を 確率分布に応じて生成するのを,人間が自身の感覚 を頼りに行うのは事実上不可能であり,その意味で, Createのフェーズに一切人手を介入させないところ に特徴がある. 一方,このようなシステムは,作曲家が自身の作 曲のために使うことを想定している場合が多く,その 場合,生成された楽曲が自身の要求に適合している かどうかは,ユーザが自分で判断できる.そのため, Donate,すなわち,生成された楽曲を聴いて完成か どうかを判断する過程は,ユーザが担当するものと考 えることができる. 3. 3 要件(B)に対する工夫 聴衆に馴染みのある音楽スタイルを踏襲すること を重視するシステムでは,音楽スタイルをいかに計 算機に実装し,それに基づいて生成するかが焦点で ある.以下,その実現方法を「ルールベース」,「事例 ベース」,「確率モデルベース」に分けて議論する. 3. 3. 1 ルールベース ルールや制約条件群の設計に基づいたアプローチ である.計算機によって初めて生成された「イリアッ ク組曲」は,音高のマルコフ連鎖と乱数生成に基づい て音高列を生成するモジュールと,生成結果が妥当な 結果であるかを判定するモジュールを交互に用いて楽 曲が生成されている.生成された音高列が妥当であ るかの判断は,対位法に基づくルール,音高同士のぶ つかり回避のためのルールに基づいて自動で行われ る[45].Levittは種々の音楽スタイルの分析に基づい た制約条件群を用いて,音楽スタイルに対応した制約 条件のセット“style templates”を準備し,その制約 条件のもとで制約充足問題を解いて楽曲を生成して いる[55].Ebcioglu はJ. S. Bachの作品の分析に基 づいて,四声体和声を生成する上での350個のルー ルをまとめ,それらルールを満たす結果を生成して いる[31].また対位法に基づいたルールを用いた楽曲 も生成されている[29] [72].与えられた制約条件の下 でのもっともよい結果を探索するための方法として, 進化論的計算も用いられている.ジャズのソロを進化 論的計算に基づいて生成するシステムがある[10]. ルールベースのシステムでは,ルールを人手で記 述し,システムはそのルールを実行することで楽曲 を生成する.ルールは,既存の楽曲を分析して設計す るか,対位法などの音楽理論に基づいて設計される. 前者の場合,CollectおよびRelateはシステム設計 者が行っていると解釈できる.後者の場合,音楽理論 は既存の楽曲を分析することにより構築されるので, 音楽学者によるCollect,Relateを通じて確立された 音楽理論を,システム設計者が計算機に実装可能な ルール群の形に翻訳していると解釈できる.ただし, イリアック組曲の場合,楽曲生成自体は乱数生成によ り行い,その取捨選択に音楽理論に基づいたルールを 用いている.生成された楽曲を評価し取捨選択する 過程はDonateに相当するので,このシステムの場合 は,CollectおよびRelateの結果をDonateのフェー ズで用いていると考えることができる.

3. 3. 2 事例ベース

品の断片などの事例を部分的に用いて生成する方法 も行われている.D. Cope のシステムでは,既存曲 のスタイルを模倣した楽曲を生成するために楽曲の 断片を収集・整理し,接続するという方法がとられ, バッハ,モーツァルト,ショパン,シェーンベルクな ど過去の作曲家やCope自身の作品のレプリカを生成 している[25].このアプローチでは,ユーザまたはシ ステム設計者が収集した事例集に対して,整理をシス テムが行っており,Collectをユーザまたはシステム 設計者,Relate以降をシステムが担っていると考え ることができる. 3. 3. 3 確率モデルベース 音楽の知見を確率モデルによって定式化し,既存楽 曲の情報を確率パラメタとして扱い,確率最大や尤度 最大を規準として最適化を行って楽曲を生成するア プローチも行われている.PachetらのContinuator では,ユーザの旋律の演奏データを元にそのスタイ ルをN-gramと木構造生成によって学習し,その結 果を生成結果に反映している [64].対位法による楽 曲生成を確率モデルを用いて行う方法も提案されて いる[77][110].歌詞を入力として歌唱曲を生成できる Orpheusでは,旋律の確率モデルに基づいて歌詞の 韻律に従う確率最大の解を動的計画法で求めること で楽曲を生成している[36].近年では統計的機械学 習手法の1つである,ノンパラメトリックベイズの 枠組みでの自動生成も行われている.白井らは階層 Pitman-Yor言語モデルを用いて既存楽曲から旋律の 特徴を学習し,旋律の生成を行っている[111]. 確率モデルを用いる場合,確率パラメタを人手で 与える場合と事例から学習する場合とがある.人手 で与える場合は,通常,システム設計者が自身の音楽 的経験や音楽理論に基づいて決定するので,Collect とRelateを設計者が行っていると考えることができ る.音楽理論の場合は,音楽理論を作り上げた過去の 音楽学者がCollect,Relateを行ったと考えることが できる.事例から学習する場合は,事例を集める過程 (Collect)は設計者が行う.ただし,学習に用いる事 例をユーザが取捨選択する仕組みがあれば,ユーザも Collectに参加できるということになる.Relateおよ びCreateはシステムが行うことになる. ルールベース,事例ベース,確率モデルのいずれ の場合であっても,イリアック組曲以外のほとんどの 研究について,一度楽曲を生成したらMIDIなどの 形式で出力して終了するので,システムはDonateを 行わず,ユーザが出力データを再生して判断するしか ない. 3. 4 要件(C)に対する工夫 ユーザの意図を反映させる工夫において重要な課 題の1つが,楽曲生成のための制約条件をユーザが 記述し,システムがそれを汲み取れるようにするこ とである.想定される(必ずしも音楽知識があるわけ ではない)ユーザが記述でき,システムがその内容を 理解できるような制約条件の記述方式を実現するこ とは,決して簡単ではない.このような課題に取り組 んだ研究としては,Backtracking Specification Lan-guage[30],Constraint Logic Programming[43] [90],

Constraint Satisfaction Techniques[63]などが挙げ られる.これは,どのような楽曲を作るかをユーザが 考え,それをシステムに伝えてシステムが楽曲を作 るという意味で,Createをユーザとシステムが共同 で行っていると解釈できる.また,Roadsのシステ ム[68]は,楽曲中に用いる楽音の特徴の内挿や外挿 をGUIによりできるようになっている. ユーザの作曲意図を完全に記述し,それを十分に満 たす楽曲を1回で生成するのが難しいことに着目し, CreateとDonateを繰り返すことでユーザの意図を 反映させるようにしたものも存在する.対話的進化 計算(IEC)による作曲[24] [99]は,その典型例であ る.これは,システムが生成した楽曲をユーザが評 価(Create & Donate)し,評価が最大化されるよう に最適化する手法である.また,北原らは,和声進行 に対する旋律生成と旋律に対する和声づけを,途中 人手で編集を加えながら繰り返して楽曲を完成させ ることのできるシステムを提案している[51].ユーザ とシステムが共同でCreateとDonateを繰り返すの はIECと共通であるが,ユーザも編集に参加できる ようになっており,必要に応じてユーザがCreateに 関与できる点が異なる.同様に,ユーザとシステムが 共同でCreateとDonateを繰り返すことで音楽を創

作するシステムとして,Cypher [69]も挙げられる.

4 自動編曲

本節では,自動編曲技術をC-R-C-Dの枠組みから 概観する. 4. 1 自動編曲システムの用途とアプローチ 前節の自動作曲では,作曲技術を持たない一般の ユーザが手軽に新規楽曲を得るために使用する場合 と,作曲技術を持つ人が自身に実現困難な表現を探求 する場合,他者からの要求に合った楽曲を手間をかけ ずに得る場合,の3つがあると述べた.自動編曲の 場合,ほとんどが編曲技術を持たない人向けである. 例えば主旋律だけは自分で思いつくがそれに伴奏を 付与することができない人,主旋律だけが記述された 譜面をピアノなどで伴奏付きで演奏したい人などが 考えられる.そのため,自動作曲で見られたように, 新規な表現を追及する研究はあまり見られず,既存の 音楽スタイルを踏襲した編曲を指向する研究がほと んどである. アプローチとしては,3. 3節で述べたものと同じよ うに,「ルールベース」,「事例ベース」,「確率モデル ベース」に分けることができる.以下,この3分類に したがって議論する. 4. 2 ルールベース ルールベースは,その名の通り,編曲のための各種 音楽知識をルール(特にif-thenルール)の形に翻訳 し,それを順次適用することで編曲を行うアプローチ である.音楽理論や和声学などの形で音楽に関する 再利用可能な知識が膨大にあるため,これらを利用 できることは大きなメリットである.例えば三浦,江 村らはポップススタイルの旋律に和声をつけるため, 和声法の知見をルールベースで導入し,制約を満たす 解を求めることで和声を生成している[103] [104].新 妻らは,通奏低音の慣例を整理しコストによる制約 条件群として扱い,コスト最小の解を求めることで 伴奏を生成している[61].また,GTTM(Generative Theory of Tonal Music) [54]に基づいて設計された ルールを用いて,旋律の補完や楽曲の要約を行うこと も行われている[113]. このアプローチとC-R-C-Dとの関係は,自動作曲 の場合(3.3.1節)と同様である.システム設計者が ルール群を注意深く設計する必要があるので,Collect およびRelateのフェーズは,設計者によって行われ ていることになる. 4. 3 事例ベース 事例ベースは,入力された条件と合致する事例を探 索し,その事例に付与されている編曲を適用する方法 である.「ハービー君」は,入力されたコード進行に対 して事例集から最長一致したコード進行を検索し,そ れに付与されていたヴォイシングを入力コード進行の 当該箇所に付与するシステムである[102].この場合, 最長一致したコード進行区間内では編曲の一貫性は保 たれるが,別々の事例(楽曲断片)からヴォイシング が付与された隣接するコード進行区間の間では,編曲 の一貫性は保たれない可能性がある.「パーピープン」 は,この問題を解決するため,ケーデンスの階層的な 連なりであるケーデンス木を定義し,この部分木に対 してヴォイシングを行い,ヴォイスリーディングの円 滑さを表す指標も導入している[114].ただし,ケー デンス木を自動的に推定するのは難しいため,ユーザ が入力する必要がある.その他,Band-in-a-Boxは, 与えられたコード進行に合った旋律を生成する機能を 持つ[65].このシステムでは,様々な楽曲のスタイル があらかじめ準備されており,それを選ぶことで旋律 を自動生成する(ただし,スタイルの内部仕様が不明 なため,「スタイル」がルール集として定義されてい るのか,事例集として定義されているのかは明らかで はない). このアプローチでは,自動作曲の場合(3.3.2節)と 同様に,事例を集める過程(Collect)はユーザまたは システム設計者が行い,Relate以降をシステムが行 う.ただし,ケーデンス木をユーザが入力する部分な どは,Relateにユーザが関与していると解釈するこ とができる. 4. 4 確率モデルベース 確率モデルベースは,主旋律と副旋律,コード進行などの依存関係を確率モデルとして表し,確率最大 化規準または尤度最大化規準により編曲を行う.例え ば,旋律にコード進行を付与する自動和声付けの問 題では,和音の状態遷移ネットワークから旋律中の各 音が出力される隠れマルコフモデルが用いられてい る[67][109].ニューラルネットワークを用いて編曲や 和声付けを行う研究[44][58],ボルツマンマシンを用 いて和声づけを行う研究[8][105]も存在する.北原ら は,ベイジアンネットワークを用いてコードネーム からメロディを考慮しつつヴォイシングを行うシステ ムを提案している[118].深山らは,隠れマルコフモ デルによるコードネーム系列の生成モデルによって, コードネーム系列が所与のときの四声体和声を逆問 題を解くことで生成している[36].鈴木らは,ベイジ アンネットワークを用いて音楽における縦と横の依存 関係をモデル化することで,コードネームを与えるこ となく,ソプラノの音符列から四声体和声を生成する 手法を提案している[120]. このアプローチについても,C-R-C-Dの位置づけ は自動作曲の場合(3.3.3節)と同様である.確率モデ ルのパラメタを事例から学習するもの(例えば[118]) は,Collectをシステム設計者またはユーザが行い, Relate以降をシステムが行う.一方,パラメタを人手 で与えるもの(例えば[120])は,CollectおよびRelate はシステム設計者があらかじめ行っていると解釈する ことができる.

5 演奏表情付けの自動化

本節では演奏表情付けに関連する研究をC-R-C-D の枠組みから概観する.演奏表情に関連する研究にど のようなものがあるかを全体から述べた後,個々の研 究をその共通する特徴から分類して紹介する. 5. 1 演奏表情付けシステムの三大アプローチ 演奏表情付けに関する研究の最大の目的は,機械な どの装置に人間がするような表情豊かな演奏を自動 的にさせることである.楽譜を解釈して楽器を操作す るために人間の演奏者が持つ技術や知識の使い方を 計算機上で表現するため,多様なアプローチに基づ く手法が提案されている[27][50][96].その具体例にお いて採用されている手法を大枠で捉えると,「ルール」 「事例」「学習」をベースとする3種類に分類するこ とができる.ルールベースは音楽に関する知識をルー ルとして列挙し,それらを組み合わせて演奏表情を 生成する手法である.事例ベースは実際に人間が演 奏した事例を出力の演奏に直接転写する手法である. 学習ベースは事例ベースと同様に人間が演奏した事例 を利用するが,直接転写ではなく確率モデルの推定に 用いる手法である.以下ではそれぞれの登場順に従っ て紹介しながら,3章と同様に各研究で「システム」 「ユーザ」「設計者」のそれぞれがC-R-C-Dにおいて どのような役割を担っているかについても言及する. また,演奏表情付けを行っている訳ではないが,演奏 表情付けへの利用や応用が可能な研究もある.それら についても個別の節で紹介する. 5. 2 ルールベースのアプローチ 演 奏 表 情 付 け 研 究 の 初 期 か ら 存 在 す る 手 法 は ル ー ル ベ ー ス の も の で あ る [13][22][23][33]– [35][41][56][57][84]–[87][101].演奏表情を自動的に出力 するシステムとして最初期に提案されたのは, Sund-bergらによるDirector Musicesである[35][74].こ の手法は音楽家から聴取によって取得した演奏表現の ためのルールを組み合わせることで表情を出力する. この手法はその後も音楽的知見からルールの追加や 改善が検討されており[13],ルールベースの典型とし て後進の研究にも影響を与えている[34][50].その一 例として挙げられるToddの手法 [84]–[87]は,演奏 表現を階層的放物線モデルとして近似するものであ る.これはDirector Musicesに含まれるテンポ曲線 のルールに類似した考え方を持つが,同時に音楽理論 の取り入れも試みられており,GTTMのタイムスパ ン還元理論[54]による楽曲の階層的解析を反映した 放物線方程式によってテンポ変動を表す曲線が生成さ れる. 音楽家からの聴取以外にもルールの取得方法が試み られている.Clynesは拍や小節など楽譜中の各階層 の演奏指示におけるテンポや音量比の組合せについて 作曲者毎に特徴的な組合せを分析し,それをルールと して表情の出力を行うシステムを提案した[22].その後,ビブラートなどの表現を加えて様々なパターンを 試聴できるツールの開発・商品化を行っている[23]. 一方Mazzola は,音楽は発音のタイミング・音高・ 音長を座標とする抽象的で幾何学的な空間で表現でき ると仮定し,数学的に音楽の表現を試みる手法を提案 した[57].楽譜はこの空間内に存在し,演奏表情はこ の空間から演算子によって別の空間へと写像する事に よって生成される.そこに左右の手における独立した テンポ変動などMazzola独自の理論がルールとして 加えられたのがRubatoモデルで,先述のDirector Musicesにおけるルール型手法を一般化したものと見 なすことができる. 一般に,このアプローチでは設計者が演奏に関す る知識を収集し,ルールとして記述している.これ は,設計者が予め行ったCollectとRelateの結果を システムに組み込んでいると解釈することができる. CollectおよびRelateの方法としては,演奏の専門 家に聴取するもの[34][35][74]のほか,統計的調査に 基づく知識を用いるもの[22][23]や,数学的理論を用 いるもの[57]などがある. このアプローチの主要な問題点は演奏のノウハウ をルールの形で網羅的に記述するのが困難なことで ある.一方,一旦ルールとして記述できてしまえば, 各ルールがどのような振舞いをするのかをユーザが 把握するのは比較的容易である.そのため,ユーザが ルールの取捨選択や重み付けを行えるようになってい るシステムが比較的多い[34][57].これによってユー ザは理想的な演奏を得られるまで試行錯誤ができるよ うになった.これはユーザが指定した演奏方法に従っ てシステムが演奏を生成し,それをユーザが聴いて再 調整している過程と考えられる.従って,Createと Donateのループをユーザとシステムが共同で回して いると解釈できる. 先述したMazzolaのRubatoモデルでは表情付け ルールを制御するためのパラメタ操作を行えるGUI が構築されており[56],ユーザはシステムが出力する 演奏表情を容易な操作によって事前に制御できる.そ してこのようなパラメタ操作を演奏中に行えるイン タフェースを備えたのが,先述のDirector Musices を発展させたpDMである [33].これらは,Create とDonateを並行処理しながら音楽の進行中に先述 のループを回していると考えることができる.プロ フェッショナルな音楽家が自身の演奏音を聴きながら 演奏方法を調整していることは間違いないところで あり,特にpDMはユーザとシステムが1つになるこ とでこれを実現したと解釈することができる. 一方,橋田らによるMixtract[41]は,Relateを主 にユーザ自身が行う研究として特徴的である.これ はユーザが考える理想的な演奏における楽曲構造や 演奏表現を自身で作り込みたいという需要を想定し ており,事例として過去の名演奏を参照できた前身 のPop-E[101]に,保科が提唱したフレーズ表現理 論[117]の定式化を加えたものである.演奏における 実例と理論を音楽的知識としてユーザに示すことで, ユーザによるRelateを支援する仕組みが提供されて いる. 5. 3 事例ベースのアプローチ ルールベースの後に提案されるようになったのが 事例ベースのアプローチである[3]–[6][46][75][76][80]– [83][92]–[94][97][106].ArcosらのSaxEx[3]–[6]は,楽 譜の情報をGTTMや暗意実現モデル[59][60]で抽象 化し,類似した旋律の探索を容易化したデータベース を持ち,そこから事例ベースの推論によって適切な事 例を抽出している.ユーザは演奏表情の雰囲気を表す 形容詞(tender, aggressive, sad, joyfulなど)を選択 して,演奏事例の表情を対象楽曲に付与することがで きる.鈴木らのKagurame[75][76][106]は,対象曲や 対象事例を様々な長さの旋律断片に分割したデータ ベースを持ち,旋律断片を対象として参照すべき事例 を探索する.小規模な演奏事例を効率的に利用するた め旋律を細かな断片に分割することで多数の事例とし て扱う一方,個々の検索も短い単位で行うことで類似 旋律の抽出精度を高めている.この研究でもユーザは 演奏に付与したい表情の特徴を雰囲気を表す形容詞 で入力する.平田らのHa-Hi-Hun[46]も同様に事例 ベースの推論によって適切な事例を抽出しているが, 設計者によってGTTMで解析された事例が自然言語 と紐付けられたデータベースを持つ点が特徴である. これによってユーザは付与したい表情の意図を自然言

語で指示することができ,それをシステムは音符列に 直接付与される指示(音符の発音タイミングや音量の 変化など)に対応付けることができる. 一般にこのアプローチでは設計者が演奏の事例を 収集し,ユーザがそのどれを使うか選択していると考 えることができる.この過程はCollectに相当し,設 計者とユーザが共同で行っていると解釈できる.シス テムはそれらの事例の中からフレーズ構造などの音 楽的に類似した事例を演奏に適した事例として検索 する.Relateに相当すると解釈できるこの過程では 先述のような音楽的知識が用いられている場合があ る[3]–[6][46].これは,設計者が(形容詞から表情へ の反映ルールの記述の為にCollectおよびRelateを 行ったことで得られた知識を基に,ユーザがシステム と共同で再度Collectを行い,残った事例をシステム がRelateしていると考えることができる. ルールベースと異なり,事例ベースのアプローチは 演奏表現を制御するためのルールを全て網羅的に記 述する必要が無いのがメリットである.しかし転写を 行うには最適な事例を選択するための何らかの基準 が必要となる.このアプローチではユーザがシステ ムへの要求を形容詞などの簡単な言葉で指定する研 究が多い.これによってユーザは煩雑なパラメタ操作 を行う必要が無くなり,深い音楽知識などがなくても Collectに関与できるようになっている. 次節で述べる学習ベースのアプローチでも事例ベー スと同様に事例が用いられるが,事例を設計者とユー ザのどちらが用意するかは研究に依存する.また,ど ちらのアプローチでも事例を集める作業(Collect)は 必要であるが,その要件はアプローチによって異な る.事例ベースの場合は同一楽曲中に属性の大きく異 なる事例が連続して適用される場合があるため,事例 集の特徴にある程度の一貫性を担保する必要がある. 一方,学習ベースの場合は事例の量をなるべく多く確 保することが重要である.また,特定の演奏者の特徴 を捉えた演奏を生成するにはその演奏者の特徴的な 部分を反映する必要があるが,それを象徴するような 事例は数多く確保できない場合が多い.そのような事 例の特徴は,学習ベースの場合は学習過程で平滑化さ れる可能性がある.一方,事例ベースの場合は該当す る事例が選択されればそのような特徴をそのまま反 映することができる. 5. 4 学習ベースのアプローチ 近年は機械学習技術の進展に伴い,演奏の特徴を数 理的なモデルに近似し学習を行う手法が発展してき た[12][15]–[21][32][47]–[49][78][107][108].学習ベースは 演奏に関するルールやそれらを制御するパラメタな どを事例から学習することで,処理過程の自動化を目 指すアプローチである.このアプローチで用いられる アルゴリズムは多岐にわたるが,このような手法をこ こではまとめて学習ベースと呼称する.

片 寄 ら の Music Interpretation System (MIS) [47][48][107][108]は楽譜の内容と演奏表現の表情と を線形回帰モデルで対応付けている.演奏表現の振舞 いを説明するためのルールを既存の演奏から抽出す ることを目的としており,その抽出を動的計画法を用 いて音響データから行う点が特徴的である.MISと 同様に音響データを用いて線形モデルの学習を行う CanazzaらのCaRo[16]–[21]は,線形モデルの学習 要素とする2種類のパラメタをムードマップとして 組織化し,表情付けを行うユーザの意図を反映するイ ンタフェースとしている. MISは事例ベースと同様にユーザと設計者が共同 でCollectを行うが,ユーザが任意の意図を演奏に反 映することは設計の目的に無いため,その他の段階 は専らシステムが行う.それに対し,CaRoの場合は ユーザが演奏のムードを2次元空間上で任意の点を 指示することで容易かつリアルタイムに演奏のタイミ ング・音量を変化させることができる.Collectは設 計者とユーザ,Relateはシステムが行う点はMISと 同様だが,ユーザがシステムと一体となってCreate とDonateを並行処理している点はルールベースとし て先述したpDM [33]と同様と言え,MISとは明確 にスタンスが異なるシステムである.しかし多様な演 奏表情の創出が困難である点が難点として指摘され ており[50],より複雑なモデルの使用が検討されるよ うになっている.

BresinらのANN Piano[12]では,音量とタイミ ングなどの事例と先述のDirector Musicesと同様の

音楽的知識を示すルールを入力として,タイミング や音量を出力とするニューラルネットワークを構築 している.設計者とユーザが事例やルールのCollect を行い,Relate以降はシステムが行うと解釈できる. 一方この研究に先述のCaRoが持つ2次元のムー ド空間の概念を付加したと言えるのがCamurriの Emotional Flute [15]である.ユーザとシステムが CreateとDonateを並行処理すると解釈できる. 演奏の振舞いを制御するルールを見出す試みは Widmerらによっても行われており,そのようなルー ルの選別をデータマイニングなどの機械学習手法を 用いた手法で試みている[80]–[83][92]–[94][97].また, カーネル法を用いた学習手法であるDorardのKCCA Piano[28]は,テンポと強弱の2次元要素の相関を最 大化する値をカーネル正準相関分析により推定する ことで,未知の楽譜の任意の部分において尤もらし い演奏表情として取るべき2次元空間上の位置を獲 得するモデルとなっている.これらはどちらもシステ ム・ユーザ・設計者の関係はMISに近い. ダイナミックベイジアンネットワークに含まれる 各種モデル化手法を用いた研究もこのアプローチで は一般的である.Grindlayらが提案したESP Piano

は楽曲がフレーズと音符の2階層で構成されるとい う仮定に基づき,演奏に含まれる表情とその楽譜上 での発生条件をHierarchical HMMに近似する[37]. 音符ごとの演奏特徴とフレーズの切れ目を含む基本的 な楽譜の情報を対応付け,2階層のHHMMとして学 習を行う.FlossmanらのYQX[32][95]では,楽譜情 報と演奏表情の関係を動的線形ガウスモデルで表現 する.人手で分析[59][60]された楽譜の情報を入力と し,その楽譜に対応した演奏情報を事後確率最大化推 定によって出力する.また,金らのPolyhymnia[49] では,条件付き確率場で楽譜内の旋律を表現してい る.これらの研究も全てCollectを設計者とユーザが 行い,RelateとCreateをシステムが行っていると解 釈でき,立ち位置はMISに近いと言える. 寺村らのUsapi[78]は,ガウス過程を用いて演奏 表情の学習と推定を行っている.既知楽譜と演奏の距 離と未知楽譜との距離に応じて重み付けを行いなが ら鍵盤操作に関する演奏表情を出力するモデルとなっ ている.これも前述した一般的なベイジアン・ネット ワークに基づく研究と同様に設計者やユーザが行う Collect以外は全ての段階をシステムによって自動化 しようという考えに基づいているが,それらに比べて 大量の事例を必要とする点が問題として指摘されて いる[32]. 演奏表情付けを行うに際して事例のオリジナリティ とユーザの意図のどちらを取り入れもう一方を排除 するかの点で,二極化の傾向が見られる.前者の目的 は主に事例の持つ演奏ルールの抽出やその特徴の正 確な転写であり,後者の主な目的はユーザに演奏生成 の新しい体験を提供することである.事例を活用する 手法が一般化してからは,特にRelate以降の段階を システムが行えるようになったことで前者を目的に掲 げた研究が増加し,両者の違いがより顕著に見えて きている.しかしいずれの場合もCollectをシステム のみで行うものは出てきておらず,事例は結局設計者 やユーザ(人間)が選んでいるのが現状である.事例 を参照して生成を行う以上,どのような事例を使用 するかが結果に影響するのは不可避である.今後は, この事例の取捨選択の自動化についても,研究の進展 が望まれる. 5. 5 演奏表情付けに応用可能な研究 演奏表情付けを行っている訳ではないが,演奏表情 付けへの利用や応用が可能な研究がある.それらは一 般に演奏におけるC-R-C-Dの一部のみに特化した研 究であると言える. 例えば楽曲分析(アナリーゼ)のための音楽理論, および,その計算機上での実現に関する研究が存在す る.これは,Relateに特化した研究と解釈できる.主 な具体例としてGTTM[54],暗意実現モデル[59][60], 保科理論[117]などが挙げられる.浜中らはこれらの 理論を汎用的なツールとして計算機に実装する取り 組みを進めている[38]–[40][119]. 演奏表情付けの自動化ではなく,名演奏家の特徴 を恣意性なく分析するために,計算機技術を活用し た研究も存在する.これらの研究も,演奏表情付け のRelateを担っていると考えることができる.Sapp は,同一楽曲における異なる演奏者による演奏を音響

信号の形式で入力し,その音響的特徴を比較可能な 形で可視化する手法を提案した[1][70][71].奥村らは, 生成モデルを用いて演奏の特徴を構造化する手法を 提案し,演奏者ごとや楽曲ごとの特徴の抽出を試みて いる[62]. その他,Collectを支援する試みとして演奏事例デー タベースの構築 [26][42],Donateを支援する試みと して演奏表情付けシステムの生成結果をコンテストス タイルで評価するRencon (Performance Rendering Contest)の実施[112][121]などが進められている.

6 考察

本章では,前章までに述べてきたタスク別のサーベ イを踏まえ,タスク間における共通の特徴について考 察する. 6. 1 C-R-C-Dのアプローチ別の状況 3章から5章までタスク別にC-R-C-Dの実現方 法を見てきたが,アプローチ別に見るとタスク間で ほぼ共通していることが分かった.アプローチ別に C-R-C-Dをまとめて表2に示す.ルールベースでは, システム設計者が設計したルールをシステムに組み込 み,事例を集めて分析するフェーズ(Collect,Relate) はルールを設計する際に必要になるので,システム設 計者が行っている.一方,事例ベースやモデル/学習 ベースでは,事例を集める(Collect)のは人間(ユー ザまたはシステム設計者)が行い,それを分析・学習 する(Relate)のはシステムの分担である.Collectを ユーザが行うのかシステム設計者が行うのかは実装 によってまちまちであるが,ユーザが行えるようにす れば,どのような事例を集めるかによって生成物を制 御することができる.ただし,事例を集めるのは時 間的にも金銭的にもコストがかかる場合が多いので, 実用上は,ある程度の事例をシステム設計者が用意し て,ユーザはそれを差し替えたり取捨選択できるよう になっている場合が多いと思われる. なお,Createをシステムが担う点,Donateをユー ザが担う点は各アプローチで共通である. 表 2 各アプローチと C-R-C-D の関係性 図 2 ユーザ・システムによる Create-Donate の ループ化 6. 2 ユーザ・システムによるCreate-Donateの ループ化 近年,単にシステムがコンテンツを自動生成する のではなく,ユーザが生成のためのパラメタなどを制 御しやすくすることで,ユーザの所望のコンテンツ を得やすくすることの重要性が認識されている.本 論文で取り上げた研究でも,ユーザが所望のコンテ ンツを得るまでパラメタなどを試行錯誤するのを行 いやすくするようにユーザインタフェースが工夫さ れている[16]–[21][33][51][56][69].これは,Createを 「ユーザによるコンテンツ生成に対する方針の指示」 と「システムによる計算・生成処理」に分け,Donate を「ユーザによる生成物の評価」とみなし,この3つ の処理を何度も繰り返すことに相当する(図2).中で も,pDM[33]やCypher[69]は音楽の進行中にこの ループを回せるようになっている.Shneidermanも各 段階は必ずしも順次的に行うわけでなく,直前やその 以前の段階に戻る場合があると述べており[73],その 意味でも,CreateとDonateがループするのは自然で あると言える.また,ここで述べたような,ユーザに とっての生成処理の制御性は,一部ではDirectability と呼ばれている[115][116].6. 3 自動化が未発達なフェーズ

表2を見ると,CreateやRelateと異なりCollect

やDonateは自動化されていないことが分かる.つま り,様々な機械学習技術が応用されている今日にお いても,ユーザまたはシステム設計者が学習データ セットを注意深く構築して与えないと,その後の学習 (Relate),生成(Create)が上手くいかない.また,生 成された結果が妥当なものかどうかを評価(Donate) する能力はないのが現状である.もしも今後,人間 による創作活動の完全自動化を目指すのであれば, CollectとDonateの自動化が大きな課題になると言 える.特に,システムが自律的にC-R-C-Dのループ を回してコンテンツの完成度を漸進的に高めていく といった処理を実現するのであれば,Donateを自動 化するのは必須である.今後,こういったアプローチ による研究についても発展が望まれる. 6. 4 タスク細分化による弊害 本論文では,音楽生成を作編曲と演奏に分け,作編 曲を作曲と編曲に,演奏を演奏表情付けと楽音合成に 分けた上で,作曲,編曲,演奏表情付けについて議論 を行った.このようなタスクの細分化は,各研究者が 取り組むべきタスクの範囲を限定し,限定されたタ スクに注力できるというメリットがあるものの,デメ リットも存在する. 1つ目のデメリットは,タスクを超えた議論をする 機会が減り,タスク横断的な音楽生成モデルの探求が しにくくなってしまうことである.実際,作曲,編 曲,演奏表情付けの各タスクにおいて採用されている 技術やアプローチは共通しているにも関わらず,タス クを超えた議論はあまり見られないのが現実である. 2つ目のデメリットは,タスク間の相互依存性を考 慮した研究が促進されにくくなることである.例え ば演奏生成の場合,聴取者にとって大事なのは,演奏 表情付けシステムが出力するMIDIデータではなく, 最終的に出てくる音である.そのため,本来,楽音 合成部が出力する音の特徴に合わせて演奏表情付け 部も振る舞いが変わってしかるべきである.つまり, 本来,演奏表情付けシステムは楽音合成結果を元に フィードバック制御する機構を持つべきだと考えられ るが,演奏表情付けと楽音合成が分業されている今, 必ずしも簡単ではない. 今後は,分業によるメリットを活かしながらも,研 究者や研究成果物の交流により,隣接するタスクとの 相互依存性をも考慮した形で研究が進んでいくこと が望まれる.

7 まとめ

本論文では音楽生成研究のうち主に自動作編曲と演 奏表情付けについて,歴史的経緯を述べShneiderman の提唱するC-R-C-Dの観点から俯瞰し調査を行った. その結果,タスクごとやアプローチごとにC-R-C-D の観点から比較分類を行うことができ,タスクによら ない共通点を見いだすことができた. 本論文で用いたC-R-C-Dの視点が適用できるのは 音楽だけではない.他の芸術分野や伝統技工,さらに はソフトウェア工学,もの創りに関しても,有効な視 点だと考えられる.ここであげたような様々な創作行 為の自動化システムの設計の際に,C-R-C-Dの視点 を活用できると考えられる. また,創作行為に計算機が関わる方法として,本 論文では自動化を取り上げたが,人間が主体的に行 う創作行為を計算機が支援するというアプローチも 存在する.この場合,人間が行うC-R-C-Dの各段階 を,場合によっては一部を計算機が代替しながら人間 を支援する方法を検討することになる.本論文で取り 上げた自動化技術は,支援においても鍵となる技術で はあるが,どういう立場やアプローチで支援するかに よって,自動化のあり方自体が変わってくる可能性が ある.今後は,創作支援の立場からC-R-C-Dを再整 理し,創作に関する自動化技術やインタラクション技 術を考察していきたい. 本論文をきっかけに,音楽をはじめとする各種創作 活動の自動化・支援の研究が,よりさかんになること を願っている. 謝辞 本論文を投稿するにあたり,北陸先端科学 技術大学院大学の東条敏教授,公立はこだて未来大学 の平田圭二教授,関西学院大学の片寄晴弘教授に貴重 な示唆を与えていただいたことを感謝する.参 考 文 献

[ 1 ] AHRC Research Centre for the History and Analysis of Recorded Music: Mazurka Project, http: //www.mazurka.org.uk.

[ 2 ] Ames, C.: The Markov Process as a Compo-sitional Model: A Survey and Tutorial, Leonardo, Vol. 22, No. 2(1989), pp. 175–187.

[ 3 ] Arcos, J. and de Mantaras, R.: An interactive case-based reasoning approach for generating ex-pressive music, Journal of Application for

Intelli-gence, Vol. 14(2001), pp. 115–129.

[ 4 ] Arcos, J. and de Mantaras, R.: The SaxEx system for expressive music synthesis: A progress report, in Proceedings of the Workshop on

Cur-rent Research Directions in Computer Music, 2001,

pp. 17–22.

[ 5 ] Arcos, J., de Mantaras, R. and Serra, X.: SaxEx: A case-based reasoning system for gener-ating expressive musical performances, in

Proceed-ings of International Computer Music Conference

(ICMC), 1997, pp. 329–336.

[ 6 ] Arcos, J., de Mantaras, R. and Serra, X.: SaxEx: A case-based reasoning system for gener-ating expressive musical performances, Journal of

Mew Music Research, Vol. 27, No. 3(1998), pp. 194–

210.

[ 7 ] Bartlett, M.: A microcomputer-controlled syn-thesis system for live performance, Computer Music

Journal, Vol. 3, No. 1(1979), pp. 25–37.

[ 8 ] Bellgrad, M. O. and Tsuang, C. P.: Harmoniz-ing Music the Boltzmann Way, Connection Science, Vol. 6(1994), pp. 281–297.

[ 9 ] Beyls, P.: The musical universe of cellular au-tomata, in Proceedings of International Computer

Music Conference, 1989, pp. 34–41.

[ 10 ] Biles, J. A.: GenJam: A Genetic Algorithm for Generating Jazz Solos, in Proceedings of

Interna-tional Computre Music Conference, 1994, pp. 131–

137.

[ 11 ] Boalch, D.: Makers of the Harpsichord and

Clavichord, 1440–1840, Macmillan, New York, 1956.

[ 12 ] Bresin, R.: Artificial neural networks based models for automatic performance of musical scores, Journal of New Music Research, Vol. 27, No. 3(1998), pp. 239–270.

[ 13 ] Bresin, R. and Friberg, A.: Rule-based emo-tional coloring of music performance, in

Proceed-ings of International Computer Music Conference

(ICMC), 2000, pp. 364–367.

[ 14 ] Buxton, W. A. S.: A Composer’s Introduction to Computer Music, Interface, Vol. 6(1977), pp. 57– 72.

[ 15 ] Camurri, A., Dillon, R. and Saron, A.: An periment on Analysis and Synthesis of Musical Ex-pressivity, in Proceedings of the 13th Colloquium on

Musical Informatics, 2000.

[ 16 ] Canazza, S., de Poli, G., Drioli, C., Roda, A.,

and Vidolin, A.: Expressive Morphing for Interav-tive Performance of Musical Scores, in Proceedings

of the 1st International Conference on WEB Deliv-ering of Music, 2001, pp. 116–122.

[ 17 ] Canazza, S., de Poli, G., Drioli, C., Roda, A. and Vidolin, A.: Modeling and Contol of Expres-siveness in Music Performance, in Proceedings of

IEEE 92, 2004, pp. 686–701.

[ 18 ] Canazza, S., de Poli, G., Drioli, C., Roda, A. and Zamperni, F.: Real-time Morphing among Dif-ferent Expressive Intentions on Audio Playback, in

Proceedings of International Computer Music Con-ference (ICMC), 2000, pp. 356–359.

[ 19 ] Canazza, S., de Poli, G., Roda, A. and Vi-dolin, A.: An Abstract Control Space for Commu-nication of Sensory Expressive Intentions in Mu-sic Performance, Journal of New MuMu-sic Research, Vol. 32(2003), pp. 281–294.

[ 20 ] Canazza, S., de Poli, G., Roda, A., Vidolin, A. and Zanon, P.: Kinematics-Energy Space for Ex-pressive Interaction on Music Performance, in

Pro-ceedings of the MOSART Workshop on Current Re-search Directions on Computer Music, 2001, pp. 35–

40.

[ 21 ] Canazza, S., Drioli, C., de Poli, G., Roda, A. and Vidolin, A.: Audio Morphing Different Expres-sive Intentions for Multimedia Systems, IEEE

Mul-timedia, Vol. 7(2000), pp. 79–83.

[ 22 ] Clynes, M.: Secrets of life in music, in

Proceed-ings of International Computer Music Conference

(ICMC), 1984, pp. 225–232.

[ 23 ] Clynes, M.: Microstructural musical linguis-tics: Composer’s pulses are linked most by the best musicians, COGNITION, International Journal of

Cognitive Science, Vol. 55, No. 3(1995), pp. 269–310.

[ 24 ] Conklin, D. and Witten, I. H.: Complexity-Based Induction, Machine Learning, Vol. 16, No. 3(1994), pp. 203–225.

[ 25 ] Cope, D.: Machine models of music, MIT

Press, 1992, pp. 403–425.

[ 26 ] CrestMuse Project, JST/CREST, J.: Crest-Muse PEDB, http://www.crestmuse.jp/pedb. [ 27 ] de Mantaras, R. L. and Arcos, J. L.: AI and

mu-sic: From composition to expressive performances,

The AI Magazine, Vol. 23, No. 3(2002), pp. 43–57.

[ 28 ] Dorard, L., Hardoon, D. R. and Shawe-Taylor, J.: Can Style be Learned? A Machine Learning Approach towards ‘Performing’ as Famous Pianists, in Proceedings of the Music, Brain and Cognition

Workshop in The Neural Information Processing Systems, 2007.

[ 29 ] Ebcioglu, K.: Computer Counterpoint, in

Pro-ceedings of International Computer Music Confer-ence, 1980, pp. 534–543.

[ 30 ] Ebcioglu, K.: Computer Counterpoint, in

Pro-ceedings of the 1986 Association for the Advance-ment of Artificial Intelligence (AAAI) Conference,

[ 31 ] Ebcioglu, K.: An Expert System for Harmoniz-ing Four-Part Chorales, Computer Music Journal, Vol. 12, No. 3(1988), pp. 43–51.

[ 32 ] Flossman, S., Grachten, M. and Widmer, G.: Expressive Performance Rendering: Introduc-ing Performance Context, in ProceedIntroduc-ings of Sound

and Music Computing (SMC) Conference, 2009,

pp. 155–160.

[ 33 ] Friberg, A.: pDM: An Expressive Sequencer with Real-Time Control of the KTH Music-Performance Rules, Computaer Music Journal,

Vol. 30, No. 1(2006), pp. 37–48.

[ 34 ] Friberg, A., Bresin, R. and Sundberg, J.: Overview of the KTH rule system for musical per-formance, Advances in Cognitive Psychology, Vol. 2, No. 2–3(2006), pp. 145–161.

[ 35 ] Fryd´en, L. and Sundberg, J.: Performance rules for melodies. origin, functions, purposes, in

Proceedings of International Computer Music Con-ference (ICMC), 1984, pp. 221–225.

[ 36 ] Fukayama, S., Nakatsuma, K., Sako, S., Nishi-moto, T. and Sagayama, S.: Automatic song composition from the lyrics exploiting prosody of Japanese language, in Proceedings Sound and

Mu-sic Computing (SMC) Conference, 2010.

[ 37 ] Grindlay, G. and Helmbold, D.: Modeling, An-alyzing and Synthesizing Expressive Piano Perfor-mance with Graphical Models, Machine Learning

Journal, Vol. 65, No. 2–3(2006), pp. 361–387.

[ 38 ] Hamanaka, M., Hirata, K. and Tojo, S.: Auto-matic Generation of Grouping Structure based on the GTTM, in Proceedings of International

Com-puter Music conference (ICMC), 2004, pp. 141–144.

[ 39 ] Hamanaka, M., Hirata, K. and Tojo, S.: Im-plementing “A Generating Theory of Tonal Music”,

Jornal of New Music Reserch, Vol. 35, No. 4(2006),

pp. 249–277.

[ 40 ] Hamanaka, M. and Tojo, S.: Interactive GTTM Analyzer, in Proceedings of the 10th

Inter-national Society for Music Information Retrieval

(ISMIR) Conference, 2009, pp. 291–296.

[ 41 ] Hashida, M. and Katayose, H.: Mixtract: and environment for designing musical phrase expres-sion, in Proceedings of Sound and Music Computing (SMC) Conference, 2010.

[ 42 ] Hashida, M., Matsui, T. and Katayose, H.: A New Music Database Describing Deviation Informa-tion of Performance Expressions, in Proceedings of

the 9th International Society for Music Information Retrieval (ISMIR) Conference, 2008, pp. 489–494.

[ 43 ] Henz, M., Lauer, S. and Zimmermann, D.: COMPOzE—Intention-based Music Composition through Constraint Programming, in Proceedings

of the 8th International Conference on Tools with Artificial Intelligence (ICTAI), Washington, DC,

USA, IEEE Computer Society, 1996, pp. 118–121. [ 44 ] Hild, H., Feulner, J. and Menzel, W.:

HAR-MONET: A neural net for harmonizing chorales in

the style of J. S. Bach, Advances in Neural

Informa-tion Processing (NIPS), Morgan Kaufmann, 1991,

pp. 267–274.

[ 45 ] Hiller, L. and Isaacson, L.: Musical composi-tion with a high-speed digital computer, Journal of

the Audio Engineering Society, Vol. 6, No. 3(1958),

pp. 154–160.

[ 46 ] Hirata, K. and Hiraga, R.: Ha-Hi-Hun: Per-formance rendering system of high controllability, in Proceedings of Rencon Workshop in

Interna-tional Conference on Auditory Display (ICAD),

2002, pp. 40–46.

[ 47 ] Katayose, H. and Inokuchi, S.: Kansei mu-sic system, Computer Music Journal, Vol. 13, No. 4(1990), pp. 72–77.

[ 48 ] Katayose, H., Uwabu, U. and Ishikawa, O.: A music interpretation system - schema acquisition and performance rule extraction, in Proceedings of

ICAD-Rencon: Performance Rendering Systems: Today and Tomorrow, 2002, pp. 7–12.

[ 49 ] Kim, T., Fukayama, S., Nishimoto, T. and Sagayama, S.: Performance Rendering for Poly-phonic Piano Music with a Combination of Proba-bilistic Models for Melody and Harmony, in

Proceed-ings of Sound and Music Computing (SMC) Con-ference, 2010.

[ 50 ] Kirke, A. and Miranda, E. R.: A survey of computer systems for expressive music perfor-mance, ACM Computing Surveys (CSUR), Vol. 42, No. 1(2009), pp. 1–41.

[ 51 ] Kitahara, T., Fukayama, S., Sagayama, S., Katayose, H. and Nagata, N.: An interactive mu-sic composition system based on autonomous main-tenance of musical consistency, in Proceedings of

Sound and Music Computing (SMC) Conference,

2011.

[ 52 ] Laske, O.: Composition Theory in Koenig’s Project One and Project Two, Computer Music

Journal, Vol. 5, No. 4(1981), pp. 54–65.

[ 53 ] Leichtentritt, H.: Mechanical music in olden times, Musical Quarterly, Vol. 20, No. 1(1934), pp. 15–26.

[ 54 ] Lerdahl, F. and Jackendoff, R.: A Generative

Theory of Tonal Music, MIT Press, Cambridge,

MA, 1983.

[ 55 ] Levitt, D.: Machine Tongues X: Constraint Languages, Computer Music Journal, Vol. 8, No. 1 (1984), pp. 9–21.

[ 56 ] Mazzola, G.: The Topos of Music –

Geomet-ric Logic of Concepts, Theory and Performance,

Birkh¨auser, Basel, Switzerland/Boston, MA, 2002. [ 57 ] Mazzola, G. and Zahorka, O.: Tempo curves

re-visited: Hierarchies of performance fields, Computer

Music Journal, Vol. 18, No. 1(1994), pp. 40–52.

[ 58 ] Mozer, M. C.: Neural Network Music Compo-sition by Prediction: Exploring the Benefits of Psy-choacoustic Constraints and Multi-scale Processing,